Чем опасен искусственный интеллект

Искусственный интеллект — угроза человечеству?

Искусственный интеллект, который когда-то считался выдумкой фантастов, сегодня вполне реален. Эта тема уже давно не сходит со страниц научно-популярных журналов, постоянно затрагивается в кино и книгах. Большинство публикаций содержит хвалебные оды искусственному интеллекту. Регулярно нам сообщают о все новых достижениях компьютерных программ, которые научились ставить медицинские диагнозы, писать картины, как Рафаэль, сочинять стихи или петь.

Постоянно сталкиваясь с огромным количеством дифирамбов в адрес ИИ, я задумалась, не таит ли его столь бурное развитие опасности для нас? Оказывается, подобное предположение вызывает большой интерес и у многих великих умов человечества, например, Стивена Хокинга и Илона Маска. Эти лидеры в индустрии высоких технологий уверены, что за ним нужен постоянный контроль.

Илону Маску на встрече в Массачусетском технологическом университете задали вопрос, что он думает об искусственном интеллекте. Он ответил, что, по его мнению, ИИ можно сравнить с «вызовом демона, которого нельзя призывать, если не можете его контролировать». В будущем люди могут настолько отстать от машин, что в конечном итоге они будут смотреть на людей так же, как люди в настоящее время смотрят на домашних животных. «Мне не по душе идея стать домашней кошкой».

Стивен Хокинг в своих многочисленных выступлениях говорил, что развитый ИИ будет способен переделывать, усовершенствовать себя. Причем скорость его эволюции будет не сопоставима со скоростью эволюции людей. Человечество рискует оказаться на более низкой ступени развития. На Земле появится новая форма жизни, превосходящая человека.

На сайте PСtunе.ru выделены четыре класса риска, вызываемого искусственным интеллектом:

ИИ может стать опасным, если будет сознательно запрограммирован на враждебность. Например, военными или террористами для достижения преступных целей.

Также враждебность искусственного интеллекта может проявиться при несовпадении глобальных целей самого ИИ и человечества. Что будет, если искусственный интеллект решит, что единственный способ достичь цели — это уничтожить всех людей?

Например, ИИ, у которого нет целей дружелюбия, отвечает за обработку полей пестицидами. Он будет обрабатывать посевы, даже тогда, когда на поле находятся люди.

ИИ, который работает с неполными данными, может ошибиться точно тaк же, как и человек. Ошибок такого рода избежать невозможно, как невозможно и знать все на свете.

Однако, поскольку ИИ способен учиться на собственном опыте, данный риск является наименее опасным. Возможность повторения ошибки будет постоянно снижаться, совершенствуя ИИ.

Большая опасность ИИ состоит в спoсобности бесконечного самосовершенствования. В конечном итоге такой искусственный интеллект может превзойти возможности интеллекта человеческого.

При возникновении ИИ, который будет умнее любого человека на Земле, людям станет невозможно полностью понять его. Он будет продолжать улучшать себя с огромной скоростью. Возможности ИИ станут поистине бесконечными. Существует много теорий об опасности искусственного интеллекта, но мы должны осознавать, что это только гипотезы, а не факты. Человечество всегда сомневалось в новых технологиях. Было время, когда люди опасались даже мобильных телефонов. Остановить технический процесс невозможно, да и не нужно. Но при этом нельзя и недооценивать риски, связанные с развитием искусственного интеллекта. В любом случае успех использования ИИ зависит от того, каким мы его создадим и как будем контролировать. Вы согласны?

Семь смертных грехов искусственного интеллекта

Об авторе: Соня Шпильберг, научный редактор, ICEF (Международный институт экономик и финансов НИУ ВШЭ).

Нет, речь пока не идет о канонизации искусственного интеллекта (ИИ), предсказавшего в конце 2019 года пандемию COVID-2019. Просто Римско-католическая церковь и технологические гиганты договорились, что в центре будущих виртуальных миров должен быть человек и его представления о добре и зле. Соответствующие «скрижали» под названием «Призыв к этике ИИ» подписали президент Папской академии жизни Винченцо Палья, президент Microsoft Брэд Смит и вице-президент IBM Джон Келли.

Наконец-то этическое поле современной инженерии оказалось в руках церковной морали, и более никто не скажет, что ИИ — порождение дьявола. У разработчиков появятся нравственные императивы, которые они зашьют в программы нейронных сетей. А в чем, собственно, была проблема? Да в том, что за короткое время своего существования кремниевый разум эволюционировал настолько, что стал не только рассуждать, как человек, но и нарушать правила — а это уже серьезно. Мы ведь не хотим заполучить реального Терминатора? Рассказываем, как ИИ научился делать человеческие, слишком человеческие дела, и быть плохим.

Оглавление:

1. ИИ и гордыня

Этическим шилом в мягком месте инженерных инноваций долгое время был вопрос доверия к ИИ относительно принятия решений. Механизм программирования, который мы создаем в качестве опор для выводов ИИ, нельзя назвать собственной этической программой нейронной сети. Это всего лишь набор ограничительных фреймов. ИИ может создать иллюзию мышления, не мысля, а просто пользуясь загруженными в его программу паттернами.

Решение ИИ выглядит как перетасовывание и выбор из загруженных вариантов «опыта», тогда как человек анализирует и выбирает наилучший вариант не только эмпирически, но и эмоционально. Хомо сапиенс также обладает ассоциативным мышлением, поэтому его решение онтологически верное, тогда как у ИИ нет своего феноменального опыта — то есть представления о логике развития культуры. Поэтому его решение может шокировать нас «неэтичностью».

«Кандидат склонен к депрессии и самоубийству», — выдает программа, и сотрудники отдела кадров при всем недоверии к технологиям «на всякий случай» все равно откажут соискателю.

2. ИИ и расизм

В большинстве штатов США искусственный интеллект используется для расчета вероятности преступления. Это помогает судьям принимать решение, отпускать подсудимого под залог или нет. Но решения ИИ часто предвзяты. Проект ProPublica, занимающийся журналистскими расследованиями, проанализировал сгенерированные «цифрой» оценки рисков для 7 тыс. арестантов во Флориде. Выяснилось, что программа, используемая судьями для предсказания случаев рецидивизма, была настроена совершенно расистски: в два раза чаще, чем белых «коллег по нарам», она помечала чернокожих обвиняемых как неисправимых преступников, пренебрегая другими фактами их биографии и обстоятельствами.

Алгоритмы прогнозирования ИИ основаны на машинном обучении, которое построено на наборе данных из исторических архивов. В итоге «мировоззрение» кремниевого интеллекта сильно зависит от типа и качества предоставляемых данных. Как говорят ученые, не надо путать корреляцию с причинно-следственной связью. Например, одна из самых известных корреляций — между низким уровнем дохода и склонностью к преступным действиям, а также между цветом кожи и сомнительной репутацией. Данные за последние 30 лет дают именно такую статистику, тем не менее, рассмотрение дел всегда нуждается в применении критического аппарата в каждом конкретном случае.

В 2019 году пекинский интернет-суд (Beijing Internet Court, BIC) запустил сервис онлайн-разбирательств во главе с ИИ. Это первый в стране киберсуд, по сути — интегрированная платформа для ведения судебных процессов в режиме онлайн. Разбирательства проводит женщина, она же — нейронная сеть, обученная на кейсах BIC. При этом ее голос, мимика, поведение и логика — плод тщательного анализа данных, которые «снимались» с настоящего судьи. ИИ-судья теперь доступна и в микроформате в приложении WeChat и в сети Weitao.

Разработчики и юристы заверяют, что ИИ будет заниматься поточным контентом — делами, где трудно ошибиться, а также собирать и обрабатывать заявки и давать консультации. Но у китайцев эта инновация вызывает опасения именно в потере этической составляющей каждого случая и решения. Впрочем, «политика партии» требует другого. «Ведение дел на более высокой скорости — это и есть современное право, потому что задержка правосудия приравнивается к отказу в правосудии», — говорит Ни Дефэн, вице-президент интернет-суда в Ханчжоу. Почему бы и нет? Китайские чиновники уверены, что за цифровыми помощниками будущее мирового правосудия.

3. ИИ и подрыв эстетики

Американский инженер Джанель Шейн, пожалуй, самый популярный в СМИ «тренер» искусственного интеллекта. Она является автором блога, где скрещивает искусство с наукой, порождая необычные результаты экспериментов. Ее работы утешают, веселят и являются доказательством того, что ИИ не только не способен лишить человечество работы, чего опасаются специалисты во всем мире, но и не имеет шансов выйти на адекватный критический уровень. Выдыхаем.

Но проект «Нейролирика» доцента Школы лингвистики НИУ ВШЭ Бориса Орехова вызывает тотальную фрустрацию у всех апологетов прекрасного. Дело в том, что он натренировал нейронную сеть на стихах великих поэтов — Пушкина, Гомера, Ахматовой и т.д., а потом заставил писать собственные вирши. Так ИИ создал некоторое количество опусов, поразительно напоминающих оригиналы.

Пример творчества нейросети, обученной на четырехстопных ямбах разных авторов:

Он беспощадной головой,

Волной и волосом волненья

Не чувствовать не упадет.

В пределах воздух красный смех.

Сеть соблюдала все особенности стиля того или иного поэта. В итоге получился сборник стихов под названием «Нейролирика», о котором Орехов отозвался как о «легитимации нейронных стихов в литературе». На слух стихи нейронной сети от стихов истинных поэтов фокус-группа отличить не смогла.

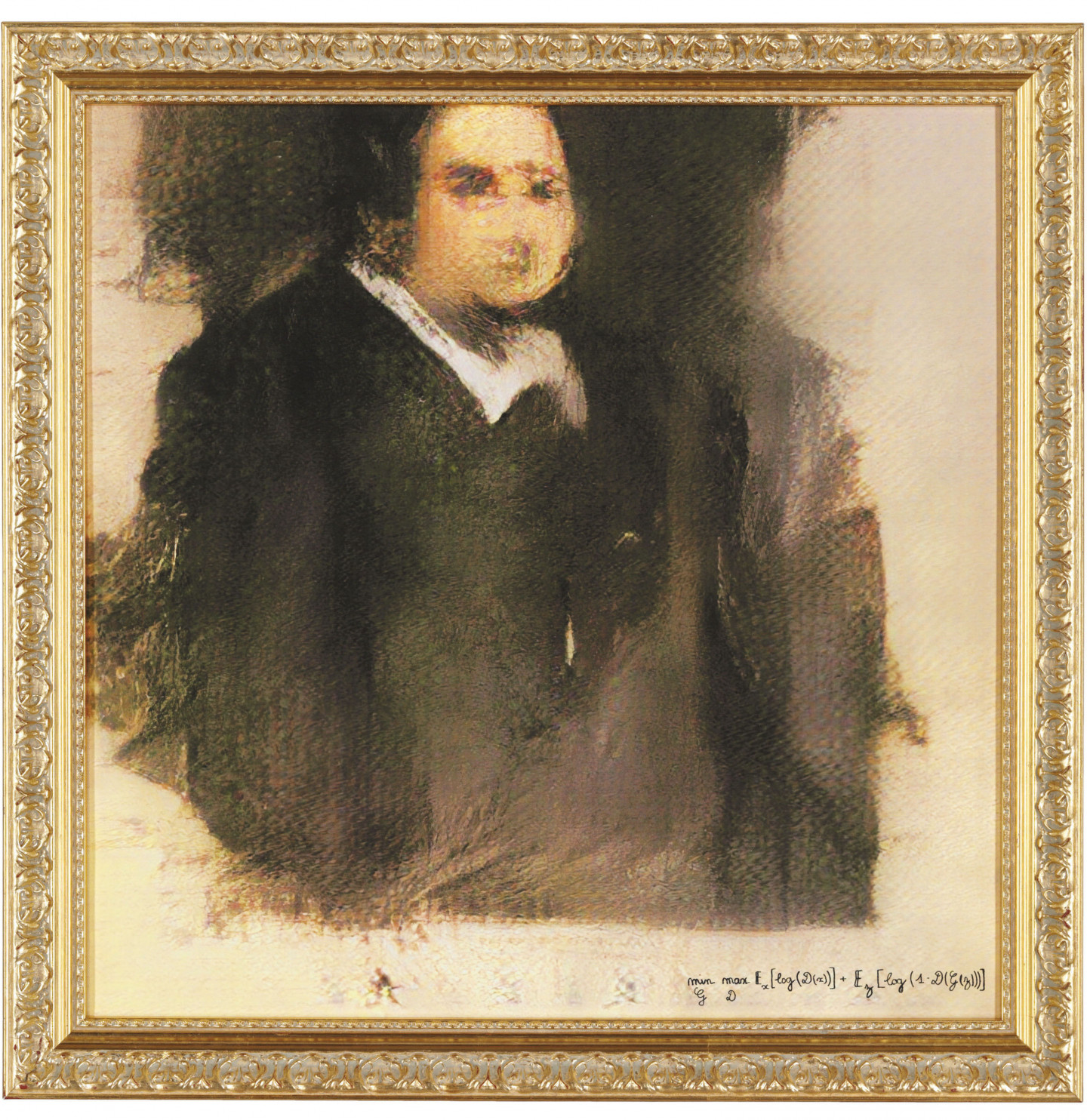

ИИ отбирает хлеб и у живописцев. Еще в 2018-м на аукционе Christie’s в Нью-Йорке за 432,5 тыc. долларов была продана картина под названием «Портрет Эдмонда Белами». Автор полотна — нейронная сети класса generative adversarial networks (GANs) — на гонорар не претендует.

Инженер из Googlе — наш соотечественник Александр Мордвинцев — запустил платформу для творческой коллаборации человека с 22-слойной сверточной нейросетью. Направление, в котором создаются здесь произведения искусства, получило название «инцепционизм». Нейрофизиологи утверждают, что распознавание изображений мозгом схоже с работой сети — это выделение и раздувание той или иной детали изображения, например, под воздействием психоделиков, и превращением фактов в метафору. Собственно, искусство и определяется как метафора реальности. «Бог умер», — так что кое-кто в конце XIX века был очень даже прав.

4. ИИ и случайное убийство

Саморефлексия — также элемент свободы воли и права на ошибку. Значит, чтобы принимать решения, как человек, ИИ должен: уметь произвольно манипулировать образами, иметь индивидуальный феноменальный опыт и встроенные этические «законы Азимова», быть способным к эмпатии и нравственным переживаниям. И пока машина не овладеет всеми этими навыками и способностями, нечего и мечтать, например, о скорой пересадке водителей и их пассажиров в беспилотные автомобили.

В этом убежден доцент Международного института экономики и финансов (МИЭФ НИУ ВШЭ) Роман Захаренко, занимающийся исследованиями по внедрению ИИ в структуру городского транспорта. По мнению Захаренко, главным тормозом, сдерживающим массовое появление на улицах беспилотных такси, является неспособность ИИ делать верный выбор в сложной непредвиденной ситуации. Скажем, если возникает дилемма «убить пешехода или пассажира в аварийной ситуации», ИИ не в силах сделать выбор, потому что инженеры (да поможет им Папа) не разрешили этот сложный этический ребус. Германия — единственная страна в мире, где на правительственном уровне разрабатывается этика поведения ИИ в рамках автопрома. В случае инцидента машина не реагирует на аналитику достоинств и недостатков потенциальной жертвы — вне зависимости от пола, возраста и характера, ее задача — спасти человеческую жизнь.

В сфере автономных транспортных средств (AV — Autonomous Vehicle) существует пять уровней ответственности ИИ. Эти уровни устанавливаются обществом автомобильных инженеров SAE International: от начального уровня автоматизации, типа «адаптивный круиз-контроль», до «Святого Грааля», как разработчики называют 5-й уровень. На самом высоком уровне ИИ полностью берет на себя управление автомобилем и принятие решений во всех возможных ситуациях и не требует переключения на ручное управление с участием водителя. При определенных условиях 5-й уровень уже реализуется, например, в беспилотных системах Personal Rapid Transit — персонального скоростного общественного транспорта. Для безопасного функционирования PRT требуется выделенная линия, где почти к нулю сведена возможность непредвиденных ситуаций.

Сейчас большинство испытаний проводятся на 2-м и 3-м уровнях — именно на них происходит наибольшее количество инцидентов. 4-го уровня достигла только компания Waymo — их беспилотные авто самостоятельно накрутили по дорогам США около 3 млн миль.

По данным на 2019 год лидерами в списке инцидентов на дорогах с участием ИИ стали компании Apple и Jinchi WeRide. Зачастую на мастерство вождения беспилотников влияют погодные условия, к которым люди намного лучше адаптированы.

Согласно исследованию Романа Захаренко, главной нормативной проблемой AV является включение его в сообщество водителей. При этом ИИ не является носителем нравственных нормативов и не подвержен наказанию, в отличие от других участников движения. Все дело в том, как разработчики и консультанты по этике будут отвечать за ошибки, которые совершает техническое устройство, обученное поступать как человек, но не обладающее культурно-этическими императивами онтологически (как ими обладает человек с того момента, как встроился в христианскую парадигму и перестал быть язычником).

Самое удивительное в феномене ИИ на дорогах — это то, что принятие решения официально становится результатом сложения и вычитания изначально заданных паттернов. Этические опасения сейчас заключены не в ожидании «терминатора», который вдруг завоюет нас, а в том, что переутверждается, навязывается, автоматизируется смысл правильного поступка. «Это процесс законотворчества, который заново кодифицирует человеческие ценности», — утверждает исследователь.

5. ИИ и ложь

Одна из частых историй в СМИ звучит так: разработчики сами не понимают, как искусственный интеллект принял то или иное решение. Так было с учеными Стэнфорда, которые обучали нейросеть CycleGAN делать для Google аэрофотосъемку и переводить данные в карту. ИИ научился прятать детали местности, манипулируя тонкими изменениями цвета, которые человеческий глаз не может уловить.

Исследователи говорят, что ИИ стал «мастером стеганографии» — то есть, он выработал свою собственную систему кодирования и сокрытия информации от человека. ИИ использовал стеганографию, чтобы фактически выбрать собственное решение запроса разработчиков вместо четкого выполнения требуемой задачи. Илон Маск, узнав об этом эксперименте, высказал самые тревожные опасения.

Другой кейс о конце света с ИИ был раздут в СМИ после того, как еще в 2017 году чат-боты Facebook изобрели свой собственный язык для общения друг с другом. Эксперимент инженерам пришлось скоропостижно закрыть, выпустив статью с опровержением страшилок о способности ИИ уничтожить мир.

6. ИИ и гомофобия

Еще в 2017 году Стэнфордские аспиранты Илун Ван и Михаль Козински натренировали нейросеть на распознавание сексуальной ориентации человека по считываемым эмоциям и особенностям мимики. В итоге сеть научилась вычислять геев с точностью в 81%, тогда как среди живых участников эксперимента с этой задачей справлялся лишь 61%. Суть эксперимента в том, что сеть отлично осведомлена о влиянии гормонов на вторичные половые признаки. Женщины и мужчины с нарушением гормонального фона — и как следствие, сексуального поведения — имеют атипичную морфологию. Авторы проекта признаются:

«Компании и правительства все чаще используют алгоритмы распознавания лиц с помощью ИИ для выявления различных человеческих интроверсий — мы осознаем, что разработка представляет угрозу для конфиденциальности и безопасности геев и представителей ЛГБТ в целом».

В конце 2019 года Джон Лейнер из Университета Претории повторил эксперимент на нескольких тысячах фото из приложений знакомств с использованием нейронной сети VGG-Face. Несмотря на макияж, наложение фильтров и даже специальное размывание фокуса, которое использовал Лейнер, ИИ терял в точности предсказания всего 10%. Тем самым молодой ученый подтвердил работоспособность пренатально-гормональной теории (prenatal hormone theory), которая легла в основу эксперимента Вана-Козински, и вместе с тем — опасения, что в скором времени, наведя телефон на человека и используя специальное приложение, можно будет узнать о его истинных сексуальных желаниях. А значит — немедленно и с точностью до 80% подвергнуть дискриминации, на которую у пострадавшего не найдется аргумента.

7. ИИ и похоть

Фаллоимитатор тысячи лет не вызывает этических вопросов даже у археологов. Дискуссия о морали и нравственности начинается там, где предмет похоти обретает антропоморфные черты. Донна Харауэй в 1985 году выпустила «Манифест киборгов», где согласно постмодернистской парадигме человек может и будет отождествлять себя с бесполым киборгом, но пока современные антропоморфные киборги — женщины барбиподобной красоты. Они создаются подчеркнуто феминными, как гиноид (женоподобный робот) разработчика из Испании Сержи Cантоса. Ее зовут Саманта, и несмотря на явную гипертрофию рта и вторичных половых признаков, это отнюдь не продукт мужской фантазии — над роботом наравне с Сантосом работала его жена. Поводом к созданию Саманты стало несоответствие в сексуальных запросах супругов. «Саманта сможет спасти не один брак», — утверждают создатели.

С докибернетическими машинами дело могло быть нечисто: в машине вечно обретался призрак духа. Этот дуализм структурировал диалог между материализмом и идеализмом, который был улажен диалектическим порождением, именуемым, по вкусу, духом или историей. Но главное, машины не были самодвижущимися, самостроящимися, автономными. Они не были способны к осуществлению мужской мечты — лишь к ее пародированию. Они не были мужчиной, автором самого себя, но лишь карикатурой этой маскулинной мечты о воспроизводстве. Думать, что они нечто иное, казалось паранойей. © «Манифест киборгов», Донна Харауэй

Как и в нашем собственном мозге, мотивации нейронной сети Саманты подчиняются главной задаче — продолжению рода, при этом легко кастомизируются под пользователя. Но Саманте для секса нужны раздражители — ласка, позитивный настрой, романтика, чтобы возникло состояние влюбленности и как бы этическое оправдание коитуса. С недавних пор Саманта обзавелась феминистской прошивкой — после выставки в Ars Electronica Center в Австрии на Сантоса обрушились защитники женских прав. Стенд с Самантой выдержал настоящее паломничество — робота не просто трогали, а лапали, приведя ее к вечеру буквально в негодность. Теперь в ответ на агрессивное поведение Саманта замыкается в себе, впадает в дурное настроение и говорит «нет», ссылаясь, например, на менструацию.

Насколько неуязвим искусственный интеллект?

Сегодня искусственные нейронные сети лежат в основе многих методов «искусственного интеллекта». При этом процесс обучения новых нейросетевых моделей настолько поставлен на поток (благодаря огромному количеству распределенных фреймворков, наборов данных и прочих «заготовок»), что исследователи по всему миру с легкостью строят новые «эффективные» «безопасные» алгоритмы, порой даже не вдаваясь в то, что в результате получилось. В отдельных случаях это может приводить к необратимым последствиям на следующем шаге, в процессе использования обученных алгоритмов. В сегодняшней статье мы разберем ряд атак на искусственный интеллект, как они устроены и к каким последствиям могут приводить.

Как вы знаете, мы в Smart Engines с трепетом относимся к каждому шагу процесса обучения нейросетевых моделей от подготовки данных (см. здесь, здесь и здесь) до разработки архитектуры сетей (см. здесь, здесь и здесь). На рынке решений с использованием искусственного интеллекта и систем распознавания мы являемся проводниками и пропагандистами идей ответственной разработки технологий. Месяц назад даже мы присоединились к глобальному договору ООН.

Так почему же так страшно «спустя рукава» учить нейронные сетки? Разве плохая сетка (которая будет просто плохо распознавать) реально может серьезно навредить? Оказывается, дело тут не столько в качестве распознавания полученного алгоритма, сколько в качестве полученной системы в целом.

В качестве простого понятного примера, давайте представим, чем может быть плоха операционная система. Действительно, совсем не старомодным пользовательским интерфейсом, а тем, что она не обеспечивает должного уровня безопасности, совершенно не держит внешних атак со стороны хакеров.

Подобные размышления справедливы и для систем искусственного интеллекта. Сегодня давайте поговорим об атаках на нейронные сети, приводящих к серьезным неисправностям целевой системы.

Отравление данных (Data Poisoning)

Как видите, отравление данных – крайне опасный вид атак, использование которого, в прочем, всерьез ограничено одной важной особенностью: необходим непосредственный доступ к данным. Если исключить случаи корпоративного шпионажа и порчи данных сотрудниками, остается следующие сценарии, когда это может произойти:

Атаки уклонения (Evasion Attack)

Следующий тип атак, который мы рассмотрим – это атаки на уклонение. Такие атаки возникают на этапе применения нейронных сетей. При этом цель остается прежней: заставить сеть выдавать неверные ответы в определенных ситуациях.

Изначально, под ошибкой уклонения подразумевались ошибки II рода, но сейчас так называют любые обманы работающей сети [8]. Фактически, злоумышленник пытается создать у сети оптическую (слуховую, смысловую) иллюзию. Нужно понимать, что восприятие изображения (звука, смысла) сетью существенном образом отличается от его восприятия человеком, поэтому часто можно увидеть примеры, когда два очень похожих изображения – неразличимых для человека, распознаются по-разному. Первые такие примеры были показаны в работе [4], а в работе [5] появился популярный пример с пандой (см. титульную иллюстрацию к данной статье).

Как правило, для атак уклонения используются «состязательные примеры» (adversarial examples). У этих примеров есть пара свойств, которые ставят под угрозу многие системы:

Теперь о немного других атаках на сети

За время нашего рассказа мы несколько раз упоминали обучающую выборку, показывали, что иногда именно она, а не обученная модель, является целью злоумышленников.

Большинство исследований показывают, что распознающие модели лучше всего учить на настоящих репрезентативных данных, а значит часто модели таят в себе много ценной информации. Вряд ли кому-то интересно красть фотографии котов. Но ведь алгоритмы распознавания используются в том числе в медицинских целях, системах обработки персональной и биометрической информации и т. п., где «обучающие» примеры (в виде живой персональной или биометрической информации) представляют собой огромную ценность.

Итак, рассмотрим два вида атак: атаку на установление принадлежности и атаку путем инверсии модели.

Атака установления принадлежности

При данной атаке злоумышленник пытается определить, использовались ли конкретные данные для обучения модели. Хотя с первого взгляда кажется, что ничего страшного в этом нет, как мы говорили выше, можно выделить несколько нарушений конфиденциальности.

Во-первых, зная, что часть данных о каком-то человеке использовалась при обучении, можно попробовать (и иногда даже успешно) вытащить другие данные о человеке из модели. Например, если у вас есть система распознавания лиц, хранящая в себе еще и персональные данные человека, можно по имени попробовать воспроизвести его фотографию.

Во-вторых, возможно непосредственное раскрытие врачебной тайны. Например, если у вас есть модель, следящая за передвижениями людей с болезнью Альцгеймера и вы знаете, что данные о конкретном человека использовались при обучении, вы уже знаете, что этот человек болен [9].

Атака путем инверсии модели

Под «инверсией модели» понимают возможность получения обучающих данных из обученной модели. При обработке естественного языка, а в последнее время и при распознавании изображений, часто используются сети, обрабатывающие последовательности. Наверняка все сталкивались с автодополнение в Google или Яндекс при вводе поискового запроса. Продолжение фраз в подобных системах выстраивается исходя из имеющейся обучающей выборки. В результате, если в обучающей выборке были какие-то персональные данные, то они могут внезапно появиться в автодополнении [10, 11].

Вместо заключения

С каждым днем системы искусственного интеллекта разного масштаба все плотнее «оседают» в нашей повседневной жизни. Под красивые обещания об автоматизации рутинных процессов, повышении общей безопасности и другого светлого будущего, мы отдаем системам искусственного интеллекта различные области человеческой жизнедеятельности одну за другой: ввод текстовой информации в 90-х, системы помощи водителю в 2000-х, обработка биометрии в 2010-х и т. д. Пока что во всех этих областях системам искусственного интеллекта предоставлена только роль ассистента, но благодаря некоторым особенностям человеческой природы (прежде всего, лени и безответственности), компьютерный разум часто выступает в качестве командира, приводя порой к необратимым последствиям.

У всех на слуху истории, как врезаются автопилоты, ошибаются системы искусственного интеллекта в банковской сфере, возникают проблемы обработки биометрии. Совсем недавно, из-за ошибки системы распознавания лиц россиянина едва не посадили на 8 лет в тюрьму.

Пока это все цветочки, представленные единичными случаями.

Ягодки ждут впереди. Нас. В ближайшем будущем.