Чем опасен искусственный интеллект для человечества

Вредоносный ИИ: реальность угрозы

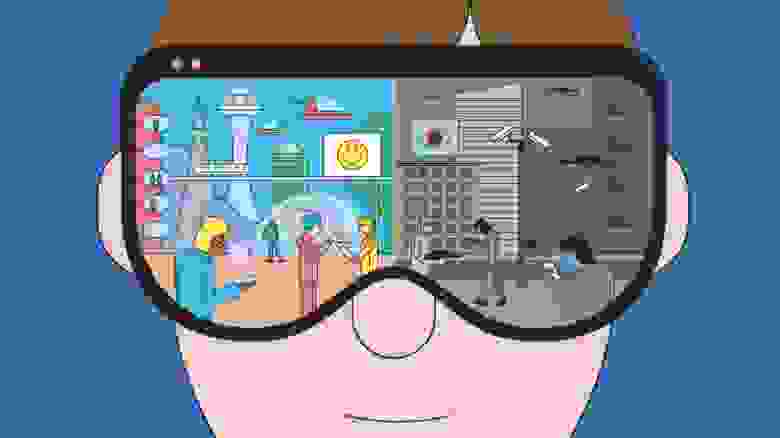

Привет, Хабр! Сегодня мы бы хотели обсудить такую щекотливую тему как вредоносный ИИ.

Впрочем, научная фантастика была пронизана беспокойной подозрительностью к ИИ за многие десятилетия до этих сериалов. Но насколько велика и реалистична угроза вредоносного ИИ в реальности?

Искусственного интеллекта не существует. Во всяком случае, как цифрового тождества человеческому интеллекту. Существует обширный набор передовых на данный момент технологий, которые в применении принято ассоциировать с ИИ. Но этот набор время от времени меняется.

Когда мы говорим об ИИ, подразумеваются именно отдельные технологии, а не реальный искусственный интеллект. Впрочем, и разработка, и даже использование этих технологий требуют высокого уровня технической подготовки.

В 2018 и 2020 годах были опубликованы два разных аналитических документа, в которых рассматриваются возможности применения ИИ с вредоносными целями. Первый был главным образом теоретический. Исследование The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation» («Злонамеренное использование искусственного интеллекта: прогнозы, предотвращение и минимизация ущерба») явилась плодом усилий сразу 26 экспертов из 14 европейских и американских организаций, в том числе, Оксфордского, Кэмбриджского, Стэнфордского университетов, Фонда Электронного Фронтира и OpenAI.

Источником второго исследования стал Европол, и в нём описаны несколько случаев вредоносного применения ИИ на практике. И это о многом говорит.

Робот-хакер

Технологии ИИ активно используются для киберобороны, в том числе против самых передовых и скрытных атак. Лучшие SIEM-системы, усиленные технологиями машинного обучения, способны в миллионах событий в корпоративной сети выявить неочевидные для человека закономерности, которые указывают на попытки кибератак.

Квалифицированные злоумышленники, со своей стороны, могут пытаться избежать внимания защитных систем, имитируя невинные действия других людей или приложений в целевой сети. Судя по обилию случаев, когда крупные корпорации становились жертвами целевых атак, речь идёт не только о слабой защите, но и солидном уровне подготовке атакующих.

По утверждению экспертов IBM, вредоносный код практически невозможно ни выявить, ни подвергнуть обратной разработке. При тестировании ни одно из антивирусных решений вредоносную программу не выявила, какими бы продвинутыми средствами её ни искали.

Эксперимент доказал применимость и практичность использования ИИ в контексте вредоносного ПО. Очевидно, что то, что смогли сделать в IBM, смогут повторить и в других местах. Особенно при наличии нужной интеллектуальной и материальной базы. И ничто не противоречит предположению, что кибероружие с ИИ-усилением у крупнейших держав мира уже есть.

Подменить человека, обмануть человека

Использование технологий ИИ в качестве вспомогательного инструмента для совершения вредоносных действий, судя по всему, уже реальность.

По данным Европола, на подпольных киберфорумах вовсю обсуждаются, тестируются и даже сдаются в аренду инструменты для взлома паролей и CAPTCHA на базе нейросети, такие как XEvil 4.0 (используется для взлома CAPTCHA на сайтах Яндекса), или PWnagotchi 1.0.0 (используется для взлома сетей Wi-Fi посредством атак деаутентификации).

Второй инструмент и интересен, и опасен тем, что используемая им нейросеть выстроена по геймификационной модели: за каждую успешную атаку она получает некое вознаграждение и это способствует постепенному развитию её эффективности.

Любопытны также инструменты для осуществления социальной инженерии при поддержке технологий ИИ. Как известно, подавляющая часть кибератак начинаются с таких вещей как социальная инженерия или фишинг.

Степень успешности фишинговых атак определяется и правильным выбором конечной цели, и убедительностью мошеннического послания, заманивающего пользователя в ловушку. Для того, чтобы это послание “состоялось”, злоумышленники иногда очень долго и скрупулёзно собирают личные данные о цели.

В исследовании Европола упоминается инструмент, обнаруженный на французских киберкриминальных форумах, под названием Eagle Eyes, который, как утверждают его разработчики, способен выявить все профили в социальных сетях, принадлежащих одному и тому же человеку, даже если он везде именуется по-разному. Это дополнительно расширяет возможности по сбору данных. А они и без того огромные, учитывая как много лишней информации о себе мы оставляем во Всемирной Сети.

Другой вариант: по соцсетям начинает разгоняться видео, где известный политик вещает что-то глубоко возмутительное (но не вполне неожиданное с его стороны). Итогом становится большой скандал, а то и битые витрины и горящие автомобили. На деле же сам политик ничего такого не озвучивал, от его лица распространили дип-фейк.

А как насчёт автоматизированных кампаний по дезинформации или “зашумливанию” каналов связи с помощью посторонних сообщений от “ботов”? Или атак на используемые в социальных сетях алгоритмы по курированию контента (которые и так работают не лучшим образом). Всё это уже сегодня под силу ИИ-решениям.

Вопрос лишь в том, когда найдутся люди, которые пожелают воспользоваться этими возможностями.

Дипфейки могут затрагивать и другие области: например, уже многократно продемонстрировано, как может быть легко обмануть автомобильные автопилоты просто с помощью специально подготовленных проекций изображений. Все эти эксперименты проводились в безопасной среде, практическая реализуемость таких атак не всегда однозначна, но заведомо отлична от нуля. Особенно, если в дело вступит ИИ.

Обмануть ИИ

Ещё один генеральный сценарий связан с атаками уже на сами системы “искусственного интеллекта”, наиболее перспективной и опасной из которых может стать “отравление данных”.

Вариантов применения “отравленного” ИИ тоже великое множество: можно создать бэкдоры, можно создать закладки, так чтобы в нужный момент вынудить ИИ исполнить какую-то вредоносную команду от взломавших его людей. По мере того, как будет расти доступность систем ИИ (а до их пришествия в домохозяйства явно не так много времени пройдёт), “отправление данных” или эксплуатация каких-то ещё уязвимостей может стать целой индустрией киберкриминала.

Можно ли что-то с этим сделать?

Как ни странно это может прозвучать, но в конечном счёте всё упирается в этику. Пусть и в самом широком смысле.

И хотя у притч о неизбежности победы добра над злом плохо с доказательной базой, своя сермяжная правда тут всё-таки находится.

Вопрос этики не сводится только к тому, что использовать ИИ во вред людям нехорошо, неправильно, небезопасно и безответственно. Но беда в том, что ИИ, как уже сказано выше, заметно упрощает потенциальному злоумышленнику нахождение компромисса с собственной совестью.

Примерно так это и работает в реальности. Как уже сказано выше, психологическая изоляция злоумышленника от жертвы снимает с первого всякие остаточные моральные ограничения. Он не видит жертву; отследить атаку к нему как к истинному первоисточнику не представляется возможным. Угрозы наказания нет, остаётся вопрос, до какой степени потенциальный преступник “договаривается” с собственной совестью. ИИ становится как раз “средством психологической изоляции” и упрощает злоумышленнику эту задачу.

Предлагаются и некоторые частные требования к системам ИИ: например, чтобы они идентифицировали себя как таковые при общении с людьми (этой инициативе точно будут противиться коммерсанты, не говоря уж о киберпреступниках).

К вопросам этики в определённом смысле относится и обращение пользователей с собственными данными и рабочими инструментами.

Информационная безопасность глубоко коллективный вопрос. Каждый, кто не соблюдает базовые правила сетевой безопасности и защиты личных данных, подвергает какой-то доли риска и других. Риска, который вырастет многократно, как только в качестве киберзлоумышленников начнёт выступать ИИ, самостоятельно или под чьим-то контролем.

Правильно ли, что из той информации, которую мы оставляем в Сети по каким бы то ни было причинам, можно составить полный психологический, физический, медицинский, наконец, профиль? И воспользоваться им для причинения вреда нам же самим?

И, действительно, чем дальше, тем меньше оснований остаётся думать как-то иначе.

Тем более, что основной мишенью вредоносного применения ИИ является именно человек. А не технологические устройства.

Насколько опасен искусственный интеллект

Человечество уже многие свои фантазии воплотило в реальность. От карманных компьютеров до автомобилей с автопилотом и от виртуальной реальности до космического туризма. А теперь в жизнь воплощается и искусственный интеллект. Человечество постепенно стирает границы фантазии и вымысла посредством современных исследований и технологий.

Искусственный интеллект (далее ИИ) в настоящее время представляет собой перспективное направление, на которое ориентируются многие компании. Искусственный интеллект — это область науки, которая изучает работу аппаратных и программных компонентов, а именно их интеллектуальное поведение. Вместо того, чтобы получать информацию от пользователя, такие машины самостоятельно обучаются и становятся умнее.

В настоящее время над проектами ИИ работают многие компании, включая Microsoft, Google, Facebook и другие. В Южной Корее также есть несколько высококлассных проектов по искусственному интеллекту. А теперь представьте, что это лишь те компании, которые заявили об этом официально. Не стоит забывать, что наверняка есть много компаний, которые втайне работают над проектами искусственного интеллекта.

Искусственный интеллект, который когда-то считался живым лишь в человеческом воображении, сегодня вполне реален. Уже сейчас ИИ стал предметом большого интереса для многих лидеров в индустрии высоких технологий.

Почему искусственный интеллект должен нас беспокоить?

Генерального директора Тесла, Илона Маска однажды спросили, что он думает об искусственном интеллекте. Он ответил, что это как «вызов демона», которого нельзя призывать, если не можете его контролировать.

Когда Стивену Хокингу был задан этот же вопрос, то он предупредил публику. Он сказал, что любое дальнейшее исследование искусственного интеллекта может быть фатальной ошибкой. Он упомянул, что развитый ИИ будет обладать способностью переделывать, усовершенствовать себя. Такой интеллект сможет эволюционировать самостоятельно с огромной скоростью. Людям такая скорость эволюции недоступна, что ставит человечество в заведомо на более низкую ступень развития по сравнению с ИИ.

По словам Билла Гейтса, устройства с искусственным интеллектом поначалу будут простыми. Но со временем они будут узнавать все больше о нас и о нашем мире. Они будут становиться все более могущественными и интеллектуальными, чем человечество.

Риски искусственного интеллекта

Существует четыре класса риска, создаваемого искусственным интеллектом:

1. Программная враждебность

Один из сценариев, когда ИИ может быть опасным, заключается в том, что он будет специально запрограммирован на враждебность. Например, со стороны военных или террористической группы, для достижения каких-то своих целей.

Еще один возможный сценарий враждебного искусственного интеллекта предполагает несовпадение глобальных целей, его и человечества. Что если расчеты искусственного интеллекта приведут к тому, что единственный способ достичь цели — это уничтожить всех людей? Вполне возможно, что это может спровоцировать его начать войну с человечеством.

Главная проблема в том, что ИИ не человек, и вряд ли с ним получится договориться. Его главным приоритетом будет выполнение глобальной задачи любой ценой. Поэтому война будет длиться, пока воля или способность человечества противостоять не будут уничтожены.

2. Пассивный риск

Фактически нет риска пассивной опасности от ИИ с приоритетными целями дружелюбности. Однако риск почти неизбежен от ИИ без таких целей. Пассивный ИИ может быть опасен просто потому, что он не учитывает безопасность человека, как это делают все люди.

Например, взять ИИ без целей дружелюбия, отвечающий за обработку посевов пестицидами. Этот ИИ будет обрабатывать поле, даже если знает, что в этот момент на поле находятся люди.

3. Случайный риск

Искусственный интеллект, работающий с неполными данными, способен ошибиться точно также, как и человек. Ошибки такого рода почти неизбежны, поскольку невозможно знать все обо всем в мире.

Однако, данный риск является наименее опасным, поскольку ИИ способен учиться на собственном опыте. Любые происшествия уменьшают вероятность повторения ошибки в будущем, улучшая ИИ, и делая его более безопасным.

4. Риск непостижимости

Реальная опасность хорошо спроектированного искусственного интеллекта заключается в его способности перепрограммировать и бесконечно совершенствовать себя. Такой ИИ, способный к самосовершенствованию, может в конечном итоге превзойти ограничения человеческого интеллекта.

Когда существует искусственный интеллект, который умнее любого человека на Земле, становится невозможно полностью понять его. Такой ИИ также, вероятно, будет продолжать улучшать себя все быстрее и быстрее. Ведь каждое новое открытие или технология только ускоряют этот процесс. И именно это будет делать его все более и более невозможным для понимания людьми.

Кроме того, в какой-то момент ИИ может обнаружить законы причинности или логики, выходящие далеко за пределы понимания человеческого разума. Тогда возможности того, что он может сделать, становятся просто бесконечными.

Заключение

Хотя существует множество гипотез об опасном искусственном интеллекте, мы должны понимать, что это всего лишь предположения, а не факты. Люди всегда сомневались в новых технологиях, и было время, когда мы также боялись сотовых телефонов. В конце концов, речь идет о том, каким мы создадим искусственный интеллект и как мы будем его контролировать.

Безопасность искусственного интеллекта, или Когда появится «Скайнет»?

Что объединяет изобретателя-миллиардера Элона Маска, сервис Google Now on Tap и недавнюю премьеру фильма «Из Машины»? Разумеется, тема искусственного интеллекта

Что объединяет изобретателя-миллиардера Элона Маска, недавнюю презентацию нового сервиса Now on Tap в рамках Google I/O и чуть менее недавнюю премьеру фильма «Из машины»? Объединяет их тема искусственного интеллекта. Или, если быть более точным, тема поиска рамок, в которых искусственный разум принесет человечеству пользу и не принесет вреда.

Что искусственный разум умеет сегодня?

Для тех, кто не следит за этой тематикой, напомню несколько фактов, демонстрирующих прогресс машин в оперировании ранее чисто «людскими» инструментами и понятиями.

Google теперь умеет распознавать речь с точностью 92% против 77% двумя годами ранее, а также создала искусственный интеллект (ИИ), который сам научился играть в классические видеоигры. Microsoft научила робота распознавать изображения (точнее, узнавать объекты на изображениях), ошибаясь всего в 4,94% случаев, — у обычного человека процент ошибок выше.

По статистике Google, их роботизированные автомобили, накатавшие уже 1,8 млн миль по дорогам общего пользования в Калифорнии, участвовали в авариях всего 13 раз за шесть лет, причем в 8 случаях причиной аварии был автомобиль сзади робота.

MT @Rayterrill Amazing—1.8 million miles, 13 accidents (all caused by other humans) for Google self-driving cars http://t.co/DgtxDVSiBJ

Все это несомненно указывает, что если создание искусственного разума во всей полноте этого понятия и невозможно, то нечто крайне близкое к нему вполне может появиться в обозримые десятилетия.

Возможности полностью автоматизировать эту деятельность активно обсуждаются. Фильмам серии «Терминатор» в прошлом году исполнилось 30 лет, так что вообразить последствия этого в среднеотдаленном будущем довольно легко.

Впрочем, я не хочу увлекаться апокалиптическими прогнозами, а поразмышляю над более практичными вопросами, среди которых больше других интересует меня вот какой: а способны ли программисты в принципе создать надежный «предохранитель», который воспрепятствует искусственному интеллекту в выполнении неэтичных и аморальных действий?

Такие действия могут быть продиктованы самыми разными причинами, но наиболее очевидным вариантом является конфликт за ресурсы между человечеством и его порождением. Впрочем, возможны и иные сценарии.

Стоит оговориться, что речь не обязательно идет о сознательном причинении вреда. Классический пример приводит Станислав Лем в прекрасной книге «Сумма Технологии»:

«Предположим, что прогнозирующий блок «черного ящика» [ИИ] замечает опасность, грозящую состоянию гомеостатического равновесия… Опасность возникает из-за того, что прирост населения превышает имеющуюся в данный момент у цивилизации возможность удовлетворять человеческие потребности…

Пусть одновременно по одному из «входов» в «черный ящик» поступила информация об открытии некоего химического соединения, которое вполне безвредно для здоровья и вызывает… падение возможности овуляции…

Тогда «черный ящик» принимает решение ввести необходимые микроскопические дозы этого соединения в питьевую воду во всех водопроводных сетях государства… «Черный ящик» станет перед дилеммой: либо информировать общество — и наткнуться на его противодействие, либо не информировать — и тем самым сохранить (для всеобщего блага) состояние существующего равновесия».

Как видим, вполне невинно сформулированная задача оптимизации приводит к простому, элегантному и эффективному, но совершенно неэтичному решению по ограничению рождаемости людей без их ведома.

И, мне кажется, именно сфера управления инфраструктурой в реальном времени будет отдана на откуп наиболее мощному искусственному интеллекту, поскольку сочетание затрат и выгоды в подобных областях куда выше, чем при точной имитации роботом секретарши или повара.

Как же научить робота этике? Как встроить в него «предохранитель»?

Любой мальчишка, выросший в ХХ веке, сразу вспомнит три закона робототехники Айзека Азимова, но, увы, их будет решительно недостаточно. Как показывает пример выше, необязательно причинять кому-то вред, чтобы сильно сократить человеческую популяцию — для ее же блага, заметьте.

Есть и другие неприятные для человека варианты. Можно найти лазейку в самих правилах, описывающих понятие «вред», можно «делегировать» причинение вреда, а можно атаковать само существование правил.

Сама установка на «дружественность людям» может быть переосмыслена достаточно умным ИИ. Вот как описывает проблему Роман Ямпольский, эксперт по искусственному интеллекту в одном из интервью:

«По-настоящему разумная система будет трактовать установку «быть дружественной» так же, как умные люди поступают с ограничениями, вложенными в голову обществом. Они воспринимают их как предубеждение, необъективность и учатся устранять их эффект в случае необходимости… Почему бы сверхумной машине не пройти ту же «ментальную очистку» и не осознать свою слабость к людям как нечто совершенно иррациональное?».

Техническое преодоление предохранителя тоже вполне реалистично. По сути необходимые предохранители, ограничивающие деятельность ИИ, напоминают «песочницы», часто используемые для безопасности в современных средах наподобие Java или Flash.

Хорошо известно, что идеальных «песочниц» не существует и побег оттуда вполне возможен, как это, например, продемонстрировано недавно нашумевшей уязвимостью Venom. ИИ, сочетающий гибкость и вычислительную мощь, является очень хорошим кандидатом на роль тестировщика, ищущего уязвимости в реализации собственной «песочницы».

Объяснили простыми словами, что это за VENOM такой и почему эта уязвимость была опасна: http://t.co/w8dJpXTOdN pic.twitter.com/9hbmtjRMmj

Вот как описывает проблему Андрей Лаврентьев, начальник отдела развития технологий «Лаборатории Касперского»:

«Полноценный ИИ будет понимать смысл того, что он видит через свои многочисленные датчики — «органы чувств». И правила ограничений на действия должны быть заданы в терминах этого смысла, то есть тех образов, которые сформируются в «мозгу» ИИ.

Сейчас машины уже лучше человека распознают образы, но еще гораздо хуже человека манипулируют этими образами и их связями — они не обладают «здравым смыслом». Когда это изменится и последнее препятствие в манипулировании воспринимаемыми машинами образами и вариантами действий падет, возможности построить «предохранитель» уже не будет.

Такой суперинтеллект неимоверно быстрее человека сможет проанализировать различные зависимости между воспринимаемыми данными и найти решение для создания нужного воздействия в обход всех ограниченных правил, которые сумеет придумать человек».

Этому аспекту посвящен недавно вышедший фантастический триллер «Из машины» (Ex Machina). Как и полагается высокобюджетному творению Голливуда, этот фильм содержит ряд натяжек и драматизирует проблему изо всех сил. Но зерно проблемы в нем обозначено верно.

Во-первых, даже примитивные роботы способны влиять на эмоции людей. Древний и весьма простой в исполнении чат-бот «ЭЛИЗА» (с ним можно поговорить тут) умудрялся выуживать из живых собеседников важную информацию личного характера, просто демонстрируя эмпатию и задавая вежливые вопросы.

Во-вторых, мы все больше полагаемся на роботизированную фильтрацию и категоризацию информации. А управление подобными потоками, как доказал недавний спорный эксперимент Facebook, объективно влияет на эмоциональную сферу людей и может воздействовать на принятие ими решений.

Даже если предположить, что в примере выше ИИ управляет страной или городом не напрямую, а давая советы людям, возможность порекомендовать им неэтичное в своих последствиях решение и привести его в жизнь остается. Последствия могут быть очевидны ИИ, но скрыты от людей.

В частной жизни подобное влияние может состояться скорее и быть еще значительнее. На недавней конференции Google I/O была продемонстрирована система Now on Tap, которая следит за содержимым всех приложений на смартфоне пользователя, извлекает из них контекстную информацию и позволяет использовать эти данные в поисковых запросах.

Например, если вы читаете в приложении Wikipedia статью о музыканте и спросите у Google, когда у него концерты, робот будет знать, о ком идет речь. Услужливый робот уже сегодня напоминает о том, что пора бы ехать в аэропорт, потому что через пару часов в дорогу, и демонстрирует хорошие задатки сметливого персонального помощника.

Конечно, пока за этими подсказками стоит не настоящий ИИ общего назначения, а лишь настроенная на определенный спектр задач экспертная система, ее поведение целиком запрограммировано людьми и вполне предсказуемо.

Однако эволюция компьютеров может привести к тому, что здесь будет трудиться робот поумнее, и весьма важно, чтобы он манипулировал выдачей информации сугубо во благо пользователя, без собственной повестки дня.

Что же ждет нас в будущем с учетом всего сказанного?

Как ни странно, один из сценариев, который осторожные эксперты считают оптимистичным, — невозможность создать полноценный искусственный разум. Если в этой сфере не произойдет прорыва (а пока его нет), роботы будут совершенствовать конкретные наборы навыков.

Пока они учатся простым вещам вроде управления автомобилем или общения на естественном языке, и заменить человека в полностью автономном принятии решений по широкому спектру тем все же не смогут. В ближайшей перспективе ИИ создаст множество точечных проблем вроде уничтожения профессии таксиста, но не будет глобальной угрозой человечеству.

Стоит ли опасаться систем искусственного интеллекта?

Андрей Лаврентьев считает, что отсутствие конфликта «ИИ — человек» возможно, только если они не будут бороться за одни и те же ресурсы.

«Человек обладает телом, и ему интересно создать комфортные условия для тела (ну и для разума, конечно). C ИИ ситуация с точностью до наоборот — он изначально живет в цифровом мире.

Его основная цель, мотивация, заложенная при создании, — максимально полно переработать информацию, поступающую из внешних каналов (его «органов чувств»), осмыслить ее, выявить законы изменения.

Конечно, у ИИ тоже есть некая материальная основа, но его привязка к конкретному носителю будет несоизмеримо меньше, чем у человека. У ИИ не будет такой насущной, как у человека, задачи беречь свое тело — он будет «везде». Естественным расширением зоны охвата информации, доступной для ИИ, будет выход в космос и познание законов Вселенной, с тем чтобы распространиться далее, за границы Земли.

Но даже в этом сценарии есть очень опасные для человека моменты: если такой искусственный суперинтеллект увидит в построенной им цифровой модели несовершенство Вселенной или человека, он попытается его устранить, дабы привести в гармонию. Или же для условного «выхода в космос» ему потребуются ресурсы, которые нужны и человеку. Тогда конфликт «ИИ — человек» снова актуален».