Что значит событие равновероятно неравновероятно информатика

Вероятностный подход к определению количества информации «Формула Шеннона. Применение ЭТ Excel для решения задач на нахождение количества информации»

Материал разработан на 2 спаренных урока.

Цели уроков: Сформировать у учащихся понимание вероятности, равновероятных событий и событий с различными вероятностями. Научить находить количество информации, используя вероятностный подход. Создать в Excel информационную модель для автоматизации процесса вычислений в задачах на нахождение количества информации, используя формулу Шеннона.

Требования к знаниям и умениям:

Учащиеся должны знать:

Учащиеся должны уметь:

Оборудование: доска, компьютер, мультимедийный проектор, карточки с заданиями, карточки-памятки, справочный материал.

Урок 1. Вероятностный подход к определению количества информации. Формула Шеннона

Ход урока

I. Организационный момент.

II. Проверка домашнего задания.

III. Постановка цели урока.

Задача: Какое сообщение содержит большее количество информации?

Первые три варианта учащиеся решают без затруднения. События равновероятны, поэтому можно применить для решения формулу Хартли. Но третье задание вызывает затруднение. Делаются различные предположения. Роль учителя: подвести учащихся к осмыслению, что в четвертом варианте мы сталкиваемся с ситуацией, когда события неравновероятны. Не все ситуации имеют одинаковые вероятности реализации. Существует много таких ситуаций, у которых вероятности реализации различаются. Например, если бросают несимметричную монету или «правило бутерброда».

Сегодня на уроке мы должны ответить на вопрос: как вычислить количество информации в сообщении о неравновероятном событии.

IV. Объяснение нового материала.

Для вычисления количества информации в сообщении о неравновероятном событии используют следующую формулу: I=log2(1/p)

где I – это количество информации, р – вероятность события.

Вероятность события выражается в долях единицы и вычисляется по формуле: р=K/N,

где К – величина, показывающая сколько раз произошло интересующее нас событие, N – общее число возможных исходов какого-то процесса.

Вернемся к нашей задаче.

Пусть К1 – это количество пирожков с повидлом, К1=24

К2 – количество пирожков с капустой, К2=8

N – общее количество пирожков, N = К1 +К2=24+8=32

Вычислим вероятность выбора пирожка с разной начинкой и количество информации, которое при этом было получено.

Вероятность выбора пирожка с повидлом: р1=24/32=3/4=0,75.

Вероятность выбора пирожка с капустой: р2=8/32=1/4=0,25.

Обращаем внимание учащихся на то, что в сумме все вероятности дают 1.

Вычислим количество информации, содержащееся в сообщении, что Маша выбрала пирожок с повидлом: I1=log2(1/p1)= log2(1/0,75)= log21,3=1,15470 бит.

Вычислим количество информации, содержащееся в сообщении, если был выбран пирожок с капустой: I2=log2(1/p2)= log2(1/0,25)= log24=2 бит.

Пояснение: если учащиеся не умеют вычислять значение логарифмической функции, то можно использовать при решении задач этого урока следующие приемы:

Приложение 1. «Количество информации в сообщении об одном из N равновероятных событий: I= log2N». (Приложение вы можете получить у автора статьи.)

При сравнении результатов вычислений получается следующая ситуация: вероятность выбора пирожка с повидлом больше, чем с капустой, а информации при этом получилось меньше. Это не случайность, а закономерность.

Качественную связь между вероятностью события и количеством информации в сообщении об этом событии можно выразить так: чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии.

Вернемся к нашей задаче с пирожками. Мы еще не ответили на вопрос: сколько получим информации при выборе пирожка любого вида?

Ответить на этот вопрос нам поможет формула вычисления количества информации для событий с различными вероятностями, которую предложил в 1948 г. американский инженер и математик К.Шеннон.

можно расписать формулу в таком виде:

Рассмотрим формулу на нашем примере:

Теперь мы с вами можем ответить на вопрос задачи, которая была поставлена в начале урока. Какое сообщение содержит большее количество информации?

Ответ: в 1 сообщении.

Обратите внимание на 3 и 4 задачу. Сравните количество информации.

Мы видим, что количество информации достигает максимального значения, если события равновероятны.

Интересно, что рассматриваемые нами формулы классической теории информации первоначально были разработаны для технических систем связи, призванных служить обмену информацией между людьми. Работа этих систем определяется законами физики т.е. законами материального мира. Задача оптимизации работы таких систем требовала, прежде всего, решить вопрос о количестве информации, передаваемой по каналам связи. Поэтому вполне естественно, что первые шаги в этом направлении сделали сотрудники Bell Telephon Companie – X. Найквист, Р. Хартли и К. Шеннон. Приведенные формулы послужили К. Шеннону основанием для исчисления пропускной способности каналов связи и энтропии источников сообщений, для улучшения методов кодирования и декодирования сообщений, для выбора помехоустойчивых кодов, а также для решения ряда других задач, связанных с оптимизацией работы технических систем связи. Совокупность этих представлений, названная К. Шенноном “математической теорией связи”, и явилась основой классической теории информации. (Дополнительный материал можно найти на сайте http://polbu.ru/korogodin_information или прочитав книгу В.И. Корогодин, В.Л. Корогодина. Информация как основа жизни. Формула Шеннона.)

Можно ли применить формулу К. Шеннона для равновероятных событий?

Мы видим, что формула Хартли является частным случаем формулы Шеннона.

V. Закрепление изучаемого материала.

Задача: В корзине лежат 32 клубка красной и черной шерсти. Среди них 4 клубка красной шерсти.

Сколько информации несет сообщение, что достали клубок красной шерсти? Сколько информации несет сообщение, что достали клубок шерсти любой окраски?

Дано: Кк=4;N=32

Найти: Iк, I

Решение:

VI. Подведение итогов урока.

Урок 2. Применение ЭТ Excel для решения задач на нахождение количества информации

Пояснение: При решении задач на нахождение количества информации учащиеся не вычисляли значение логарифма, т.к. не знакомы с логарифмической функцией. Урок строился таким образом: сначала решались однотипные задачи с составлением формул, затем разрабатывалась табличная модель в Excel, где учащиеся делали вычисления. В конце урока озвучивались ответы к задачам.

Ход урока

I. Постановка целей урока

На этом уроке мы будем решать задачи на нахождение количества информации в сообщении о неравновероятных событиях и автоматизируем процесс вычисления задач данного типа.

Для решения задач на нахождение вероятности и количества информации используем формулы, которые вывели на прошлом уроке:

рi=Ki/N; Ii=log2(1/pi);

II. Решение задач.

Ученикам дается список задач, которые они должны решить.

Задачи решаются только с выводами формул, без вычислений.

В озере обитает 12500 окуней, 25000 пескарей, а карасей и щук по 6250. Какое количество информации несет сообщение о ловле рыбы каждого вида. Сколько информации мы получим, когда поймаем какую-нибудь рыбу?

Решение:

III. Объяснение нового материала.

Задается вопрос ученикам:

1. Какие трудности возникают при решении задач данного типа? (Отв.: Вычисление логарифмов).

2. Нельзя ли автоматизировать процесс решения данных задач? (Отв.: можно, т.к. алгоритм вычислений в этих задачах один и тот же).

3. Какие программы используются для автоматизации вычислительного процесса? (Отв.: ЭТ Excel).

Давайте попробуем сделать табличную модель для вычисления задач данного типа.

Нам необходимо решить вопрос, что мы будем вычислять в таблице. Если вы внимательно присмотритесь к задачам, то увидите, что в одних задачах надо вычислить только вероятность событий, в других количество информации о происходящих событиях или вообще количество информации о событии.

Мы сделаем универсальную таблицу, где достаточно занести данные задачи, а вычисление результатов будет происходить автоматически.

Структура таблицы обсуждается с учениками. Роль учителя обобщить ответы учащихся.

При составлении таблицы мы должны учитывать:

Прежде чем демонстрировать заполнение таблицы, учитель повторяет правила ввода формул, функций, операцию копирования (домашнее задание к этому уроку).

При заполнении таблицы показывает как вводить логарифмическую функцию. Для экономии времени учитель демонстрирует уже готовую таблицу, а ученикам раздает карточки-памятки по заполнению таблицы.

Рассмотрим заполнение таблицы на примере задачи №1.

Рис. 1. Режим отображения формул

Рис. 2. Отображение результатов вычислений

Результаты вычислений занести в тетрадь.

Если в решаемых задачах количество событий больше или меньше, то можно добавить или удалить строчки в таблице.

VI. Практическая работа.

1. Сделать табличную модель для вычисления количества информации.

2. Используя табличную модель, сделать вычисления к задаче №2 (рис.3), результат вычисления занести в тетрадь.

3. Используя таблицу-шаблон, решить задачи №3,4 (рис.4, рис.5), решение оформить в тетради.

4. Сохранить таблицы в своих папках под именем «инф_вероятность».

В классе 30 человек. За контрольную работу по информатике получено 15 пятерок, 6 четверок, 8 троек и 1 двойка. Какое количество информации несет сообщение о том, что Андреев получил пятерку?

В коробке лежат кубики: 10 красных, 8 зеленых, 5 желтых, 12 синих. Вычислите вероятность доставания кубика каждого цвета и количество информации, которое при этом будет получено.

В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков. Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика?

VII. Подведение итогов урока.

Учитель оценивает работу каждого ученика. Оценивается не только практическая работа на компьютере, но и оформление решения задачи в тетради.

VIII. Домашняя работа.

1. Параграф учебника «Формула Шеннона», компьютерный практикум после параграфа.

2. Доказать, что формула Хартли – частный случай формулы Шеннона.

Литература:

Вероятностный подход к оценке количества информации. Формула Шеннона

Вы будете перенаправлены на Автор24

В основе нашего мира лежат три составляющие: вещество, энергия и информация. Как много в мире вещества, энергии и информации? Можно ли их измерить и как именно? Нам известны способы измерения количества вещества и энергии. Но как быть с информацией? Можно ли ее измерить?

Ранее уже отмечалось, что существует несколько подходов к оценке количества информации. Сейчас мы более подробно остановимся на одном из них.

Любое сообщение будет являться информативным, если оно пополняет знания человека, т.е. уменьшает неопределенность его знаний.

Равновероятные события

Например, при подбрасывании монеты мы пытаемся угадать, какой стороной она упадет. Возможен один из вариантов исхода: монета окажется в положении «орел» или «решка». Каждое из этих двух событий окажется равновероятным, т. е. ни одно из них не имеет преимущества перед другим. Перед подбрасыванием монеты никто не может знать, как она упадет, т.е. существует неопределенность знания. После же наступления события, наоборот, присутствует полная определенность, так как бросающий получает зрительное сообщение о положении монеты, которое, в свою очередь, уменьшает неопределенность его знания в два раза, поскольку из двух равновероятных событий произошло одно.

Другим примером является ситуация с шестигранным кубиком, т.е. перед броском никто не может знать, какой стороной он упадет. В данном случае присутствует возможность получить один результат из шести равновероятных. Таким образом, до броска неопределенность знаний бросающего будет равна 6, после же броска, она уменьшится ровно в 6 раз, поскольку именно 6 равновероятных событий может произойти.

Рассмотрим пример, где для экзамена приготовили 40 билетов. Вероятность событий, которые произойдут при вытягивании билета, будет равна 40. Причем эти события будут равновероятны. При этом неопределенность знаний студента перед выбором билета, будет равна 40. Соответственно неопределенность знания после того как студент взял билет уменьшится в 40 раз. Зададимся вопросом, зависит ли этот показатель от номера вытянутого билета. Нет, поскольку события равновероятны.

Готовые работы на аналогичную тему

Проанализировав все рассмотренные выше примеры, можно прийти к выводу, что чем больше исходное число возможных равновероятных событий, тем в большее количество раз уменьшается неопределенность знаний, и тем большее количество информации будет содержаться в сообщении о результатах опыта.

Неравновероятные события

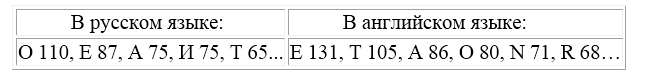

Помимо этого, вероятность появления отдельных букв будет зависеть от того, какие буквы используются перед ними. Так, в русском языке после гласной никогда не может стоять мягкий знак, а также в словах не используются четыре гласные подряд и т.д. Разговорные языки имеют, как правило, свои особенности и закономерности. Именно поэтому количество информации, содержащееся в сообщениях любого разговорного языка, неприемлемо оценивать с помощью формулы Хартли, которая используется в алфавитном подходе к оценке информации и характерна для примеров с равновероятными событиями (примеры с монетой и кубиком).

Как определить, какое количество информации содержит, например, текст романа «Война и мир», или фрески и полотна великих итальянских художников, или генетический код человека? Ответы на эти вопросы и подобные им науке пока не известны и, по всей вероятности, еще не скоро будут известны. Однако всех интересует, возможно ли объективно оценить количество информации? К задаче подобного рода можно отнести следующий пример.

Как выяснить, являются ли равновероятными сообщения «первой выйдет из здания женщина» и «первым выйдет из здания мужчина»? Однозначного ответа на этот вопрос нет. Все будет зависеть от того, о каком именно здании идет речь. Если это, например, здание гинекологической клиники, то вероятность выйти первой у женщины очень высока, если это военная казарма, то вероятность выйти первым для мужчины будет выше, чем для женщины, а вот если это здание кинотеатра, то вероятности выйти первыми для мужчины и женщины будут одинаковыми.

Оценка количества информации. Формула Шеннона

Для решения задач подобного рода используется общая оценка количества информации, предложенная американским учёным Клодом Шенноном в 1948г. Созданная им формула определения количества информации способна учитывать возможную неодинаковую вероятность сообщений, содержащихся в наборе. Шеннон при создании формулы использовал применяемую в математике и гидродинамике вероятностную меру неопределенности (называемую энтропией) для того, чтобы в полной мере оценить состояние изучаемой системы и получить максимально возможную информацию о протекающих в этой системе процессах. Эта оценка количества информации, по существу, является вероятностной мерой, и, как оценка неопределенности, она отражает способность какого-либо источника проявлять все новые и новые состояния и таким образом отдавать информацию.

Шеннон определил энтропию как среднюю логарифмическую функцию множества вероятностей возможных состояний системы (возможных исходов опыта). Для расчета энтропии Шеннон предложил следующее уравнение:

Тогда количество информации, полученное в результате опыта, будет не что иное, как разность между энтропией системы до ($H_0$) и после ($H_1$) опыта:

причем если неопределенность в результате опыта полностью исключается, то имеем:

Рассмотрим пример, подтверждающий использование данной теории Шеннона на практике.

Решение. События улова пескаря или окуня не являются равновероятными, поскольку окуней в озере обитает намного меньше, чем пескарей.

Общее количество пескарей и окуней, обитающих в озере:

Определим вероятность улова пескаря:

Определим вероятность улова окуня:

Количество информации, содержащейся в сообщении об улове пескаря:

$I_1 = log_2(\frac<1><0,75>) » 0,43$ бит,

Количество информации, содержащейся в сообщении об улове окуня:

Количество информации, содержащейся в сообщении об улове рыбы (карася или окуня) рассчитывается по формуле Шеннона:

Получи деньги за свои студенческие работы

Курсовые, рефераты или другие работы

Автор этой статьи Дата написания статьи: 12 04 2016

Примеры решения задач с не равновероятными событиями

Информация

Количество информации

Количеством информации называют ее числовую характеристику, отражающую ту степень неопределенности, которая исчезает после получения информации. Для оценки и измерения количества информации в сообщении применяются различные подходы, среди которых следует выделить статистический и алфавитный.

Статистический подход. Для количественной оценки неопределенности или энтропии Н Хартли Р. предложил формулу, содержащую логарифм от числа равновероятных возможностей N

которую можно записать в следующем виде:

где H – количество информации.

Минимальной единицей количества информации, именуемой битом, будет выбор из двух возможностей.

При не равновероятной возможности выбора количество информации hi, зависящей от индивидуальной вероятности Pi i – го выбора, вычисляется по формуле К. Шеннона

которую можно преобразовать к виду

Удобнее в качестве меры количества информации пользоваться не значнем hi, а средним значением количества информации

Алфавитный подход позволяет определить количество текстовой информации. Количество информации, которое несёт каждый символ вычисляется по формуле

где N – мощность алфавита, равная количеству символов в нём.

Текст, содержащий K символов, имеет объём информации, равный

Максимальное количество слов L из m букв, которое можно составить с помощью алфавита мощностью N, определяется как

Примеры решения задач с равновероятными возможностями

П 1.1. Пусть имеется колода карт, содержащая 32 различные карты. При выборе одной карты имеется 32 возможности.

Решение: Число возможностей N = 32 при подстановке в формулу (1) дает количество информации H = 5 (2 H = 2 5 ).

П 1.2. При бросании монеты выбор одного результата (например, выпадения орла) несет один бит информации, поскольку количество возможных равновероятных результатов N = 2 (орел или решка). Действительно, подставляя N = 2 в формулу (1), получим H = 1 бит.

П 1.3. Какой объем информации содержит сообщение, уменьшающее неопределенность в 4 раза?

Решение: так как неопределенность знаний уменьшается в 4 раза, следовательно, она была равна 4, т.е. существовало 4 равновероятных события. Сообщение о том, что произошло одно из них, несет 2 бита информации (4 = 2 2 ).

П 1.4. В коробке лежат 16 кубиков. Все кубики разного цвета. Сколько информации несет сообщение о том, что из коробки достали красный кубик?

Решение: из 16 равновероятных событий нужно выбрать одно. Поэтому N = 16, следовательно, H = 4, (16 = 2 4 ).

Пояснение: события равновероятны, т.к. всех цветов в коробке присутствует по одному.

П 1.5. Сообщение о том, что ваш друг живет на 10 этаже, несет 4 бита информации. Сколько этажей в этом доме?

Решение: N = 2 4 = 16 этажей.

Пояснение: события равновероятны, т.к. номера этажей не повторяются.

Примеры решения задач с не равновероятными событиями

П 1.6. В корзине лежат 8 черных шаров и 24 белых. Сколько информации несет сообщение о том, что достали черный шар?

1) N = 8 + 24 = 32 – шара всего;

П 1.7. В коробке лежат 64 цветных карандаша. Сообщение о том, что достали белый карандаш, несет 4 бита информации. Сколько белых карандашей было в коробке?

Ответ: 4 белых карандаша.

П 1.8.В корзине лежат белые и черные шары. Среди них 18 черных шаров. Сообщение о том, что из корзины достали белый шар, несет 2 бита информации. Сколько всего шаров в корзине?

3) N = Кб + Кч = 18 + 6 = 24 шара было в корзине.

Ответ: 24 шара лежало в корзине.

Примеры решения задач на измерение алфавитного объёма

П 1.9. Найти объем текста HT, записанного на языке, алфавит которого содержит N = 128 символов и K = 2000 символов в сообщении.

2) HT = H × K = 7 × 2000 = 14 000 бит – объем сообщения.

П 1.10. В алфавите некоторого языка всего N = 2 буквы, каждое слово в языке состоит точно из m = 7 букв. Какой максимальный запас слов в языке?

а) 128; б) 256; в) 64; г) 1024.

Тестовые задачи

Варианты ответа: а) 1 бит; б) 2 бита; в) 3 бита; г) 4 бита.

Т 1.2. Сколько информации содержит сообщение, уменьшающее неопределенность знаний в 8 раз?

Варианты ответа: а) 1 бит; б) 2 бита; в) 3 бита; г) 4 бита.

Т 1.3. При угадывании целого числа в некотором диапазоне было получено 8 бит информации. Сколько чисел содержит этот диапазон?

Варианты ответа: а) 128; б) 256; в) 64; г) 32.

Т 1.4. В школьной библиотеке 16 стеллажей с книгами. На каждом стеллаже 8 полок. Библиотекарь сообщил Пете, что нужная ему книга находится на пятом стеллаже на третьей сверху полке. Какое количество информации библиотекарь передал Пете?

Варианты ответа: а) 5 бит; б) 6 бит; в) 7 бит; г) 8 бит.

Т 1.5. При угадывании целого числа в диапазоне от 1 до N было получено 9 бит информации. Чему равно N?

Варианты ответа: а) 64; б) 128; в) 256; г) 512.

Т 1.6. В группе N = 30 студентов. За контрольную работу по математике получено К5 = 15 пятерок, К4 = 6 четверок, К3 = 8 троек и К2 = 1 двойка. Какое количество информации Н5 в сообщении о том, что Андреев получил пятерку?

Варианты ответа: а) 1 бит; б) 2 бита; в) 3 бита; г) 4 бита.

Т 1.7. За семестр студент получил N = 100 оценок. Сообщение о том, что он получил пятерку, несет Н5 =2 бита информации. Сколько пятерок К5 студент получил за четверть?

Варианты ответа: а) 15; б) 20; в) 25; г) 30.

Т 1.8.В ящике лежат перчатки (белые и черные). Среди них – Кч = 2 пары черных. Сообщение о том, что из ящика достали пару черных перчаток, несет Нч = 4 бита информации. Сколько пар белых перчаток Кб было в ящике?

Варианты ответа: а) 20; б) 30; в) 40; г) 48.

Т 1.9. Для ремонта актового зала использовали белую, синюю и коричневую краски. Израсходовали одинаковое количество банок белой и синей краски Кб = Кс. Сообщение о том, что закончилась банка белой краски, несет Нб = 2 бита информации. Синей краски израсходовали Кс = 8 банок. Сколько банок коричневой краски Кк израсходовали на ремонт актового?

Варианты ответа: а) 8; б) 12; в) 16; г) 20.

Т 1.10. На остановке останавливаются троллейбусы с разными номерами. Сообщение о том, что к остановке подошел троллейбус с номером N1, несет НN1 = 4 бита информации. Вероятность появления на остановке троллейбуса с номером N2 в два раза меньше, чем вероятность появления троллейбуса с номером N1 (РN1 = 2РN2). Сколько информации НN2 несет сообщение о появлении на остановке троллейбуса с номером N2?

Варианты ответа: а) 5 бит; б) 6 бит; в) 7 бит; г) 8 бит.

Т 1.11. В корзине лежат 32 клубка шерсти. Среди них – 4 красных. Сколько информации несет сообщение о том, что достали клубок красной шерсти?

Варианты ответа: а) 1 бит; б) 2 бита; в) 3 бита; г) 4 бита.

Т 1.12. В корзине лежат красные и зеленые шары. Среди них 15 красных шаров. Сообщение о том, что из корзины достали зеленый шар, несет 2 бита информации. Сколько всего в корзине шаров?

Варианты ответа: а) 18; б) 20; в) 22; г) 24.

Т 1.13. Известно, что в ящике лежат N = 20 шаров. Из них – Кс = 10 синих, Кз = 5 – зеленых, Кж = 4 – желтых и Кк = 1 – красный. Какое количество информации несут сообщения о том, что из ящика случайным образом достали черный шар Нч, белый шар Нб, желтый шар Нж, красный шар Нк?

а) Нч = 1 бит, Нб = 2 бита, Нж = 2,236 бит, Нк = 4,47 бит.

б) Нч = 2 бита, Нб = 4 бита, Нж = 2, 6 бит, Нк = 4,47 бит.

в) Нч = 1 бит, Нб = 2 бита, Нж = 3 бита, Нк = 4 бита.

г) Нч = 3 бита, Нб = 2 бита, Нж = 2,236 бит, Нк = 4,47 бит.

Т 1.14. В корзине находятся всего 128 красных, синих и белых шаров, причем красных шаров в три раза больше, чем синих. Сообщение о том, что достали белый шар, содержит 3 бита информации. Найти количество синих шаров. арианты ответа: а) 24; ) 28; в) 32; г) 36.

Т 1.15. В озере обитает 12500 окуней, 25000 пескарей, а карасей и щук по 6250. Сколько информации мы получим, когда поймаем какую-нибудь рыбу?

Варианты ответа: а) 1, 5 бит; б) 1, 75 бит; в) 2 бита; г) 2, 25 бит.

Т 1.16. Сообщение, записанное буквами из 64-х символьного алфавита, содержит 20 символов. Какой объем информации оно несет?

Варианты ответа: а) 100 бит; б) 110 бит; в) 120 бит; г) 130 бит.

Т 1.17. Информационное сообщение объемом 1,5 Кбайта содержит 3072 символа. Сколько символов содержит алфавит, при помощи которого было записано это сообщение?

Варианты ответа: а) 8; б) 16; в) 24; г) 32.

Т 1.18. Для записи текста использовался 256-символьный алфавит. Каждая страница содержит 30 строк по 70 символов в строке. Какой объем информации содержат 5 страниц текста?

Варианты ответа: а) 850 байт; б) 950 байт; в) 1050 байт; г) 1150 байт.

Т 1.19. В алфавите некоторого языка всего две буквы: «А» и «Б». Все слова, записанные на этом языке, состоят из 11 букв. Какой максимальный словарный запас может быть у этого языка?

Варианты ответа: а) 22; б) 11; в) 2048; г) 1024; д) 44.

Т 1.20. Словарный запас некоторого языка составляет 256 слов, каждое из которых состоит точно из 4 букв. Сколько букв в алфавите языка?

Варианты ответа: а) 8; б) 4; в) 64; г) 1024; д) 256.