Что такое dynamic boost

Как производители видеокарт умудряются повышать fps в играх за счет софта

Другое дело — новые технологии от производителей самих комплектующих, направленные на увеличение количества fps в играх, снижение задержек и повышение общего качества картинки при неизменной нагрузке на «железо». Это куда эффективнее, ведь постоянно наращивать ядра/частоты и одновременно уменьшать техпроцесс не получится, а потому выгоднее работать над софтом, способным выжать из видеоускорителей все соки.

Сегодня мы разберемся, на какие ухищрения идут производители комплектующих, и что они делают для того, чтобы улучшить свои продукты для превосходства над конкурентами.

Nvidia DLSS и AMD FSR — пусть работают нейросети

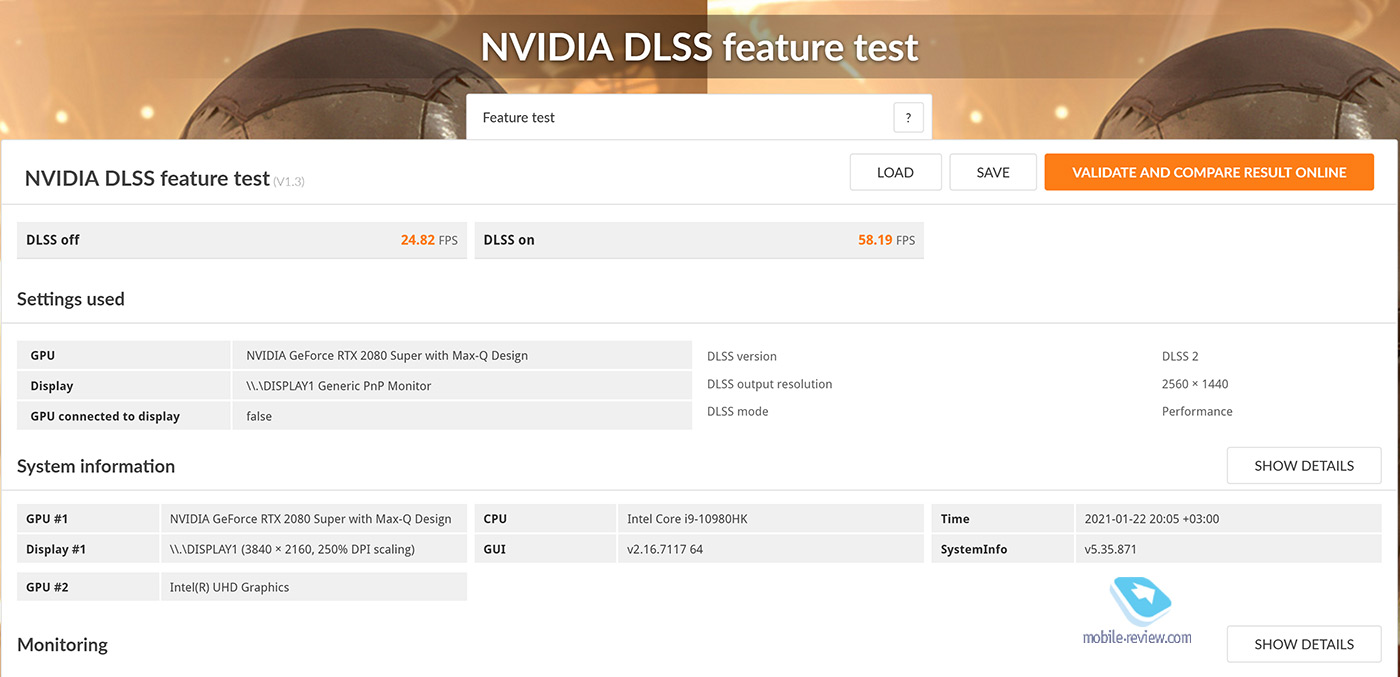

Deep Learning Super Sampling или DLSS — разработка компании Nvidia, направленная на повышение разрешения изображения без увеличения нагрузки на видеочип за счет нейросетей. Суть технологии в том, что сначала нейросеть обучают на суперкомпьютерах собирать попиксельно картинку в низком разрешении, одновременно демонстрируя аналогичные изображения, только уже в суперразрешении. Важно, что при этом используются не мощности GPU-чипа, а специально предназначенные для этого тензорные ядра отдельного выделенного блока. Как итог, пользователь получает картинку в разрешении, например, близком к истинному 4К, но при этом нагрузка на видеопроцессор остается такой же, как при Full HD.

Nvidia представила DLSS в 2018 году и на сегодняшний день актуальной является ее более продвинутая вторая версия. Компания AMD в этом плане отставала, что сильно огорчало ее фанатов, но в начале июня 2021 года «красные» все же дали ответ — FidelityFX Super Resolution (FSR). Этот аналог DLSS призван также уменьшать нагрузку на видеочип за счет снижения разрешения рендеринга при неизменности итоговой картинки с повышением частоты кадров. Хотя ответ AMD менее технологичен, он более универсален и не требует специальных тензорных ядер, а поддерживают разработку все видеокарты начиная с Radeon RX Vega и RX 400.

Рост производительности при неизменности качества изображения? Звучит как очередной маркетинговый трюк, но на самом деле это рабочая схема, увеличивающая мощность видеоадаптеров на 15−25%, а в некоторых случаях и на все 50%. Интересно, что AMD обещает прирост в производительности едва ли не на 90% со включенной FSR — хотелось бы верить! Так или иначе, но технологии рабочие и действительно серьезно повышают количество fps в играх без усиления нагрузки на GPU, а соответственно и роста рабочих температур. Что самое важное, игр с поддержкой DLSS 2.0 и FSR с каждым месяцем становится все больше и больше, а значит, и старенькие видеокарты еще смогут послужить год-другой, пока не наладится ситуация с видеокартами и другими комплектующими.

Nvidia Reflex и AMD Radeon Boost — моментальный отклик

Мгновенный отклик — залог успеха топового геймера. Однако это не значит, что обычному любителю компьютерных игр не нужна подобная технология по уменьшению лагов, — разве кто-то фанатеет от эффекта желе в управлении? Вовсе нет и хотя эти технологии от AMD и Nvidia не прибавляют количества кадров в секунду в играх, они существенно улучшают отзывчивость, что порой куда важнее высоких показателей фреймрейта.

Высокие задержки главным образом возникают тогда, когда мощность центрального процессора превосходит возможности видеокарты. То есть процессор передает графическому адаптеру больше кадров, чем тот может обработать. Видеоадаптер становится своего рода «бутылочным горлышком», из-за чего и играть в таком режиме становится некомфортно. Nvidia Reflex и AMD Radeon Boost призваны оптимизировать работу CPU и GPU для уменьшения задержек. Кроме того, у обеих компаний есть еще по одной технологии в запасе по уменьшению лагов — это Anti-lag (AMD) и Low Latency (Nvidia). У каждой функции есть свои преимущества и недостатки, но если взять в целом, то явным фаворитом по улучшению отзывчивости управления является Nvidia Reflex.

Dynamic Boost — помощь нуждающимся

Эта технология касается уже мобильных решений, а точнее — игровых ноутбуков, оснащаемых экономичными Max-Q вариантами видеокарт от Nvidia. Актуальная на сегодня разработка Dynamic Boost 2.0 призвана регулировать энергопотребление компонентами ноутбука во время выполнения сложных задач (среди которых и игры) для достижения максимальной производительности.

Известно, что игры больше нагружают видеоадаптер, нежели процессор, а потому CPU время от времени может простаивать. В компании Nvidia подумали, что нерасходуемую энергию можно пустить на нужды видеокарты, тем самым регулируя TDP CPU и GPU. В итоге графический адаптер может получать до 20 резервных Вт энергии, за счет чего увеличивается фреймрейт или сокращается время рендеринга кадров в играх.

Dynamic Boost не просто перенаправляет незадействованную энергию нуждающемуся компоненту, — технология также призвана оптимизировать соотношение мощность/нагрев для более стабильной работы компьютера.

Resizable BAR и AMD Smart Access Memory — прямой доступ к видеопамяти

Современные игры — это скопище огромного числа текстур и моделей высокой детализации, которые перед появлением на экране ПК сперва проходят долгий путь от накопителя до оперативки, а затем перенаправляются из RAM в память видеокарты. Обычно процессор передает эти данные из оперативки в память видеокарты частями (не более 256 МБ за раз), не имея доступа ко всему объему VRAM, что негативно влияет на количество fps. Resizable BAR и технология SAM от AMD разработаны для того, чтобы обеспечить CPU полный доступ к памяти видеокарты, за счет чего наблюдается повышение частоты кадров в играх на 5−11%.

Стоит отметить, что AMD SAM — технология, реализованная на уровне «железа», и поддерживается только новейшими видеоадаптерами Radeon RX 6000-й версии.

Resizable BAR, используемый Nvidia, является софтовой функцией, хотя ее также поддерживают только флагманские модели серии GeForce RTX 3000-й серии. Кроме того, далеко не все игры позволяют задействовать эту технологию, что на видеокартах AMD, что на графических адаптерах от Nvidia, так как в части проектов наблюдается не увеличение, а даже снижение количества fps.

GeForce Experience и Radeon Software — оптимальные настройки для каждой видеокарты

Программное обеспечение для видеоадаптеров от Nvidia и AMD имеет в своем составе пресеты и настройки, позволяющие улучшить быстродействие видеокарт автоматически. Естественно, что при этом жертвуется часть каких-то графических красот, но лучше так, чем играть с невыносимыми лагами и подтормаживаниями, но с лучшим качеством картинки. Насладиться игровым процессом во втором случае не получится, как ни старайся.

Кроме того, в программном обеспечении обеих компаний можно поиграться с частотами графических ядер и видеопамяти, настроить охлаждение и получить дополнительные 15−20% производительности, что никогда не будет лишним.

Вся правда о TGP в видеокартах NVIDIA GeForce RTX 30 для ноутбуков

С момента официального анонса нового поколения мобильных видеокарт NVIDIA GeForce RTX 30-й серии для ноутбуков в сети появилось множество разной и в тоже время противоречивой информации о новой графике. Мы расскажем о частотах и энергопотреблении новых видеокарт в наших ноутбуках, а также дадим ответ на вопрос, почему одна и та же видеокарта, установленная в разных ноутбуках, может показывать разную производительность, и как выбрать именно то, что нужно вам.

Почему мобильная графика раньше была медленнее десктопной?

Прежде чем переходить к техническим характеристикам мобильных видеокарт GeForce RTX 30-й серии, стоит вспомнить, с чего всё началось. Откуда появилась технология Max-Q, для чего она создавалась и какие преимущества она предоставила пользователям. Давайте вспомним, с чего всё начиналось.

С момента своего появления мобильная графика отставала от аналогичных по названию десктопных версий. В начале нулевых техпроцесс всё ещё измерялся в десятках и сотнях нанометров, и несмотря на то, что топовая десктопная графика того времени не требовала двух- или трёх-слотовых систем охлаждения, уместить её в ноутбуках не представлялось возможным. Ведь остальные электронные компоненты также были большими и требовали больше места для размещения на материнской плате. К тому же системы охлаждения того времени были не так эффективны, как нынешние. В итоге NVIDIA снижала мощность мобильных видеокарт, чтобы сделать возможной их установку в ноутбуки. Даже драйвера для мобильных и десктопных видеокарт в то время различались и выпускались строго по отдельности.

Чтобы пользователи лучше понимали, какая видеокарта устанавливается в ноутбук, мобильная графика обозначалась иначе, чем десктопная. Когда названия серий состояли из одной цифры, в названии мобильной графики появилось дополнительное слово «Go». Например, видеокарта NVIDIA GeForce 4 MX 460 предназначалась для компьютеров, а NVIDIA GeForce 4 Go 460 – для ноутбуков.

Когда видеокарты NVIDIA стали наращивать количество унифицированных шейдерных процессоров, одного лишь снижения частот стало недостаточно. Чтобы уложиться в теплопакет, с которым может справиться система охлаждения ноутбуков, NVIDIA стала отключать часть шейдерных процессоров в видеоядре.

Разница в производительности десктопных и мобильных видеокарт сохранялась до 2016 года, пока NVIDIA не представила архитектуру Pascal и видеокарты GeForce GTX 10-й серии. На этом этапе NVIDIA смогла свести к минимуму разницу между десктопными и мобильными GPU. Для обозначения мобильных видеокарт больше не требовались дополнительная буква, индекс или слово.

У NVIDIA GeForce GTX 1080 и GTX 1060, созданных для ноутбуков и компьютеров, стало одинаковое количество ядер CUDA. Даже у мобильной GeForce GTX 1070 оказалось чуть больше CUDA-ядер по сравнению с её десктопным аналогом. Разумеется, частоты у мобильных и десктопных видеокарт немного различались, но разрыв между мобильной и «полноценной» десктопной графикой в рамках одного поколения стал не настолько большим и заметным, как это было ранее. А в зависимости от эффективности системы охлаждения, разницы могло и вовсе не быть, как, например, в случае с ноутбуком ROG G703.

Появление архитектуры Pascal стало прорывом для тех, кто предпочитал играть на ноутбуках которые, в отличии от компьютера, всегда можно взять с собой. Ноутбуки с видеокартами GeForce GTX 10-й серии легко справлялись с играми того времени.

Появление технологии Max-Q

Игровые ноутбуки с топовой графикой, которая справляется с современными играми — это прекрасно. Однако, у любой медали есть две стороны. Производительная видеокарта непременно будет горячей, для неё потребуется большая система охлаждения, которая во многом определяет толщину и вес ноутбука.

Для примера возьмём ROG G703, высокую производительность которого обеспечивал 4-ядерный процессор Intel Core i7-7820HK в паре с видеокартой NVIDIA GeForce GTX 1080. Топовая конфигурация для своего времени! Однако, при толщине в 51 мм и весе в 4,7 кг ROG G703 совершенно точно нельзя назвать ноутбуком, который можно носить с собой на работу каждый день. Скорее, это полноценная замена десктопа, которую при необходимости можно легко перенести в другое место. Главное, не забыть с собой огромный блок питания :).

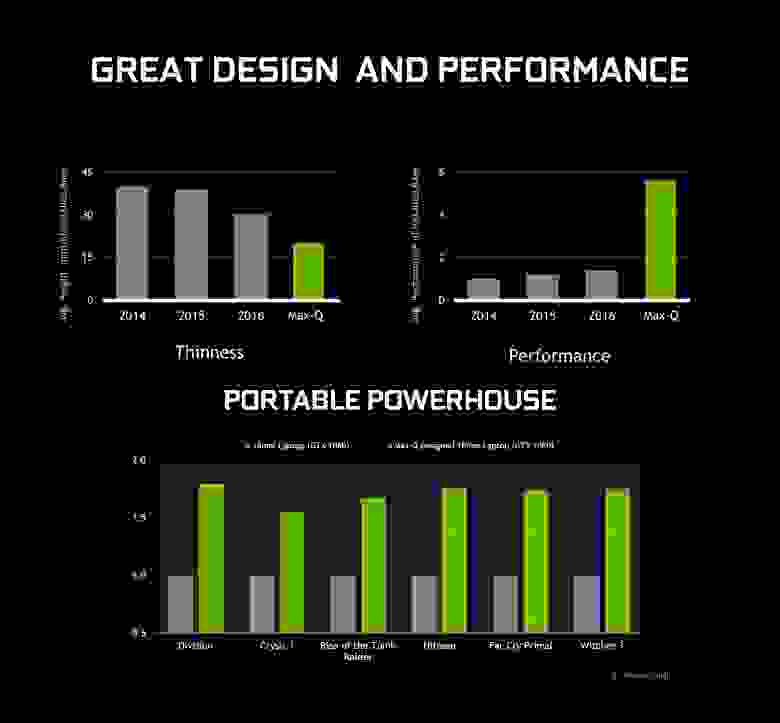

Пользователям хотелось получить не только мощные, но и тонкие игровые ноутбуки, а производители стремились удовлетворить потребности. Все-таки, ноутбук ассоциируется с компактностью и мобильностью. К тому же, игровые ноутбуки многие используют для работы – мощная начинка одинаково хорошо справляется как с играми, так и с большинством тяжёлых задач, вроде сложных расчётов, обработки фото, видеомонтажа и так далее. Но это требовало создания более энергоэффективных видеокарт, которыми в будущем и стали линейки под названием NVIDIA Max-Q.

В аэродинамике точкой Max-Q называют момент максимальной нагрузки на ракету в атмосфере, который особенно учитывается конструкторами. Компания NVIDIA применила похожий подход при разработке серии видеокарт Max-Q, которые работают на пределе своей энергоэффективности.

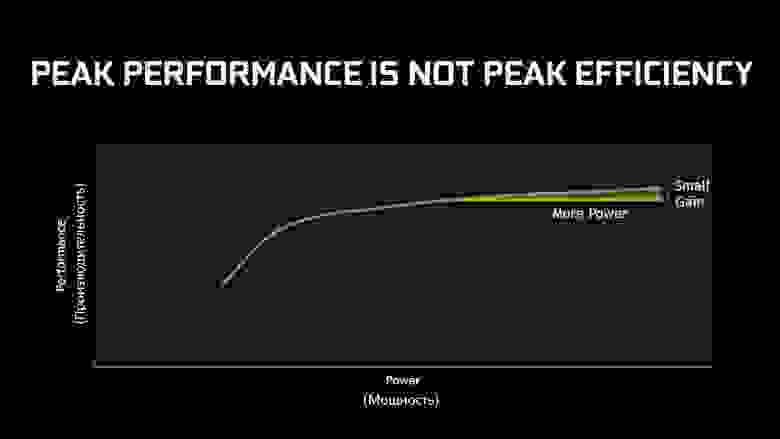

Необходимо пояснить, что не стоит путать понятия «энергоэффективность» и «производительность». В первом случае графика работает с максимальной производительностью относительно потребляемой мощности, и не выходит за пределы заложенного лимита энергопотребления. Во втором случае происходит прирост производительности, за который приходится расплачиваться увеличивающимся тепловыделением и энергопотреблением.

Зависимость между потребляемой мощностью и ростом производительности нелинейная. При увеличении потребляемой мощности прирост производительности сперва будет заметным, линейным, а потом, после прохождения точки максимальной эффективности, прирост производительности (который не стоит путать с самой производительностью) замедляется. Проще говоря, видеокарта NVIDIA GeForce GTX 1080 будет быстрее GTX 1080 Max-Q, но при этом потребует улучшенной системы охлаждения и станет потреблять больше энергии.

В результате в 2017 году на рынке появилось два типа ноутбуков: с классической графикой GTX 10-й серии и с графикой Max-Q. Появление линейки Max-Q позволило выпускать тонкие и лёгкие игровые модели, чего не удавалось добиться ранее. Для Max-Q не требуется крупногабаритная система охлаждения. При этом, видеокарты Max-Q остались производительными. Например, топовая версия GeForce GTX 1080 Max-Q оказалась почти в 2 раза быстрее обычной мобильной GeForce GTX 1060.

Благодаря появлению видеокарт Max-Q, мы смогли выпустить тонкие, лёгкие и при этом мощные игровые ноутбуки. Первой моделью стал 15-дюймовый ROG Zephyrus GX501. В ноутбуке толщиной 17,9 мм и весом 2,26 кг была установлена графика NVIDIA GeForce GTX 1080 в дизайне Max-Q в паре с 4-ядерным процессором Intel Core i7-7700HQ. Для рынка ноутбуков 2017 года это стало революцией.

Различия между TDP и TGP

Долгое время энергопотребление видеокарт обозначалось аббревиатурой TDP. Расшифровать эти три буквы можно как Thermal Design Point или Thermal Design Parameter. Значение TDP обозначало, сколько Ватт тепла нужно отводить от кристалла GPU, и не указывало общее энергопотребление видеокарты. Параметр TGP напротив указывает, сколько Ватт потребляет вся видеокарта целиком.

Графика NVIDIA GeForce RTX 30-й серии в ноутбуках ASUS и ROG

За время существования графики NVIDIA GeForce RTX 10-й и 20-й серий, мы успели привыкнуть к тому, что видеокарты для ноутбуков и десктопов стали практически одинаковыми. Однако, выход мобильных видеокарт нового поколения на архитектуре Ampere снова поменял правила игры.

Десктопные видеокарты NVIDIA GeForce RTX 30-й серии оказались не только производительными, но и требовательными к питанию. Согласно официальному сайту NVIDIA, энергопотребление GeForce RTX 3080 составляет 320 Вт, когда как GeForce RTX 2080 Super потребляла 250 Вт. При этом, мы имеем в виду энергопотребление, указанное без заводского разгона и самых пиковых значений.

Разница в энергопотреблении у старого и нового поколения видеокарт оказалась заметной. Впервые видеокарта NVIDIA с одним GPU потребляет более 300 Вт. Учитывая высокое энергопотребление и впечатляющую производительность графики, перед инженерами NVIDIA появилась сложная задача по оптимизации десктопной графики к мобильным реалиям. Если системы охлаждения ASUS и Republic of Gamers легко могут отвести от десктопной видеокарты всё лишнее тепло, то в случае с ноутбуками мы ограничены толщиной корпуса, которая не позволяет установить СО толщиной несколько сантиметров.

В результате, инженерам NVIDIA пришлось вынужденно вернуться к старым методикам –отключению CUDA-ядер. Также при разработке ноутбука стало возможным ограничивать TGP видеокарты как в большую, так и в меньшую стороны. Это означает, что на этапах проектирования и производства можно выставить максимальное энергопотребление согласно возможностям системы охлаждения. В результате на рынке появились ноутбуки с одинаковым названием видеокарт, но разной производительностью, что закономерно привело в замешательство многих пользователей.

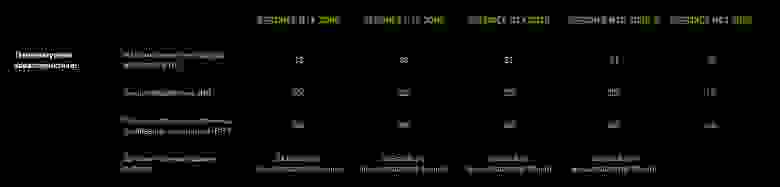

Мы всегда открыто рассказываем о компонентах своих игровых ноутбуков. Чтобы у наших пользователей не осталось вопроса, какая именно графика используется в заинтересовавшем ноутбуке, мы публикуем таблицу с данными TGP и рабочими частотами для каждой отдельной модели. Скоро эти данные станут доступны на нашем официальном сайте в разделе технических характеристик на страницах новых ноутбуков.

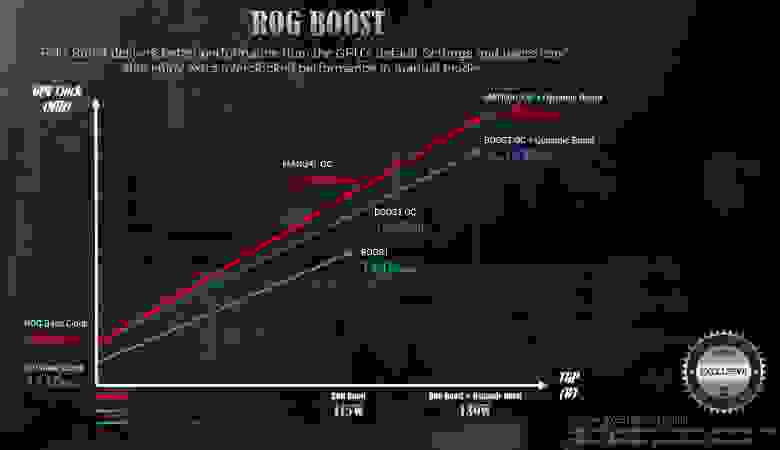

В таблице указано как энергопотребление видеокарты (TGP), так и дополнительная мощность, потребляемая в режиме Dynamic Boost. Вместе с мощностью в таблице указана частота Boost Clock. Стоит отметить, что это скорее базовые частоты, на которых будет работать GPU. Реальная максимальная частота окажется выше, она зависит от системы охлаждения ноутбука и температуры в конкретный момент.

Теперь разберёмся с новой мобильной графикой на примере. Рассмотрим пять 15-дюймовых ноутбуков с графикой NVIDIA GeForce RTX 3070: ROG Zephyrus Duo 15 SE, ROG Zephyrus G15, ROG Strix SCAR 15, TUF Dash F15 и TUF A15. Для того, чтобы сравнение стало наглядным, поместим ноутбуки в отдельную таблицу.

В сравнении наглядно видно, что производительная система охлаждения Active Aerodynamic System, которая используется в ROG Zephyrus Duo 15 SE, может отвести 130 Вт тепла от видеокарты. Основная мощность в 115 Вт приходится на стандартное энергопотребление (TGP), и ещё 15 Вт – на Dynamic Boost. Если система решит, что возможностей системы охлаждения ноутбука хватит для увеличения нагрузки на графику, то, благодаря GPU Boost, видеокарта получит дополнительные 15 Вт мощности и сможет работать быстрее. В результате её энергопотребление вырастет до 130 Вт.

Системы охлаждения остальных ноутбуков ROG Zephyrus G15, TUF Dash F15 и TUF A15, сделаны по классическому принципу. В них у видеокарт был снижен параметр TGP, чтобы система охлаждения справилась со своей задачей. Вместе с TGP закономерно снизились частоты примерно на 16%, но при этом энергопотребление платы снизилось на 30%.

Заключение

Мы делаем всё возможное, чтобы предложить нашим пользователям полную и разнообразную линейку ноутбуков с разными форм-факторами, производительностью и ценой. Надеемся, что опубликованная информация по энергопотреблению мобильных видеокарт будет для вас полезной, и поможет лучше разобраться в современном рынке игровых ноутбуков, и понять различия в мобильной графике нового поколения в ноутбуках ASUS и Republic of Gamers.

PS. По просьбам в комментариях добавили скидку в 5000 рублей по промокоду habr на все ноутбуки с графикой NVIDIA GeForce RTX 30-серии в нашем Интернет-магазине.

Что такое dynamic boost

Долгое время понятие игровой ноутбук воспринималось как шутка. Отставание мобильной видеокарты от своей настольной копии доходило до двукратных значений. Играть на самых дорогих решениях было можно, но, купив флагманскую модель ноутбука, вам приходилось постоянно копаться в настройках, вместо того чтобы наслаждаться игрой. С появлением технологии Max-Q Dynamic Boost от NVIDIA всё изменилось. В настоящее время отставание между мобильной и настольной версией одной и той же модели видеокарты опустилось до приемлемых значений.

реклама

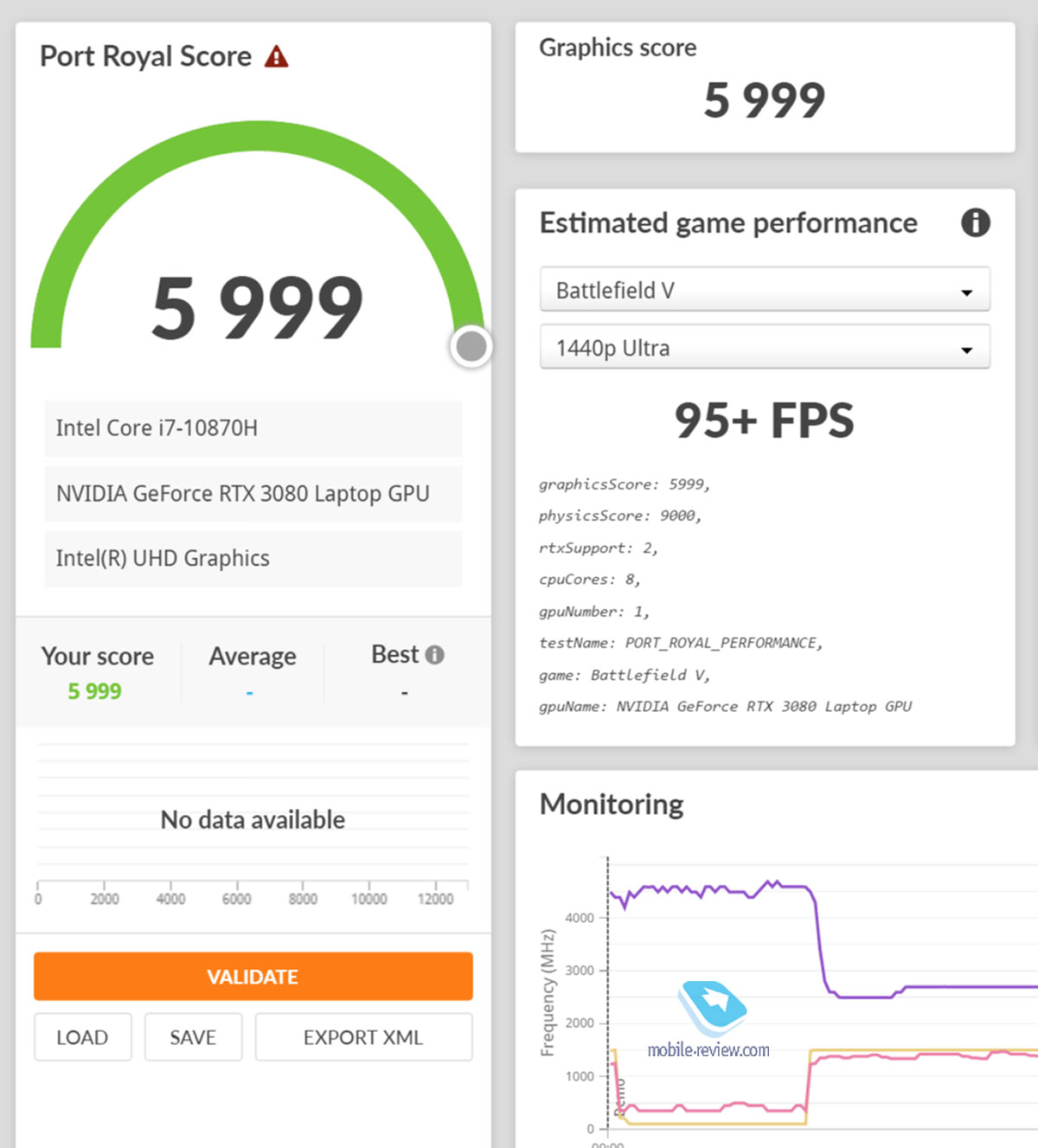

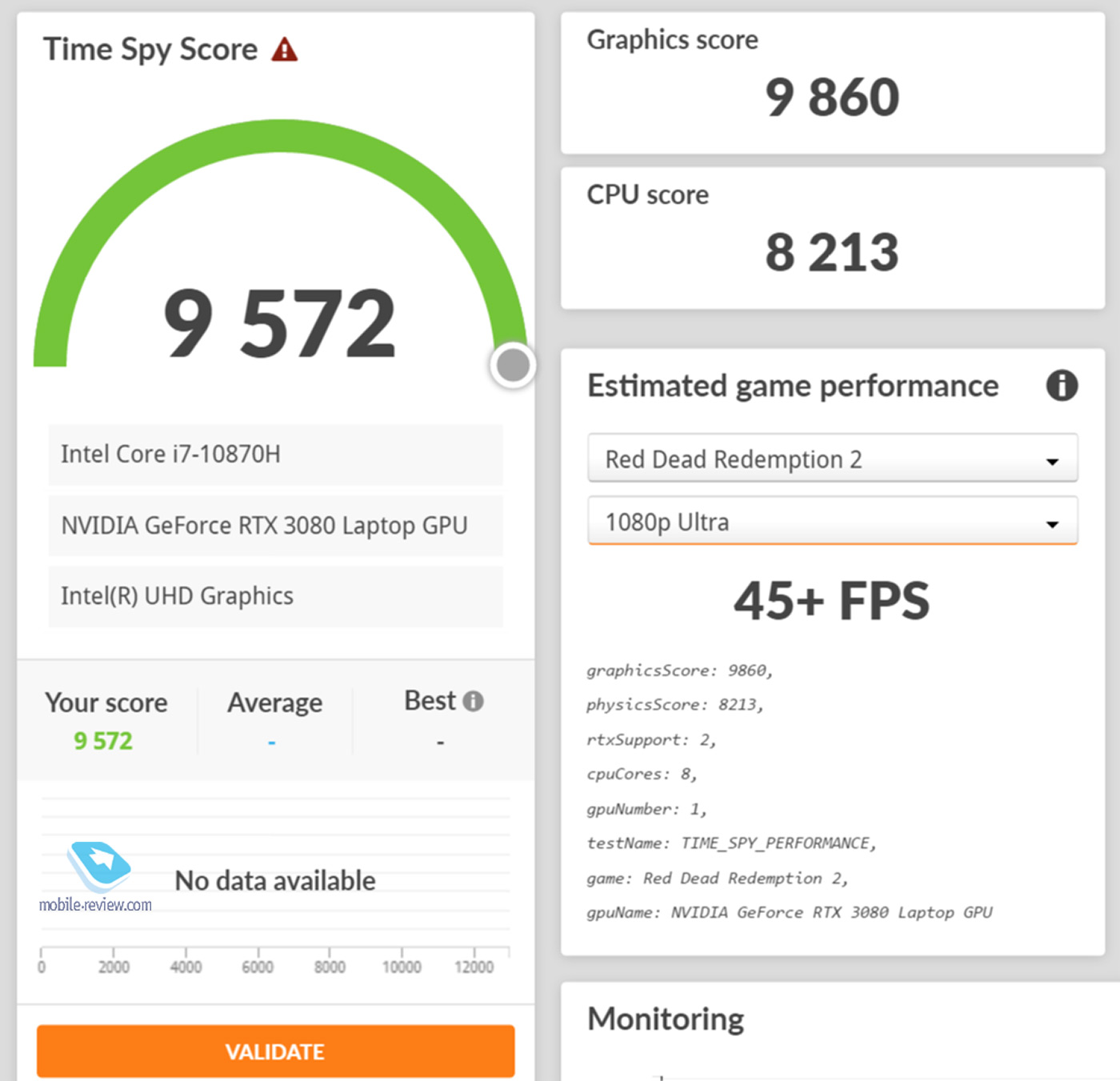

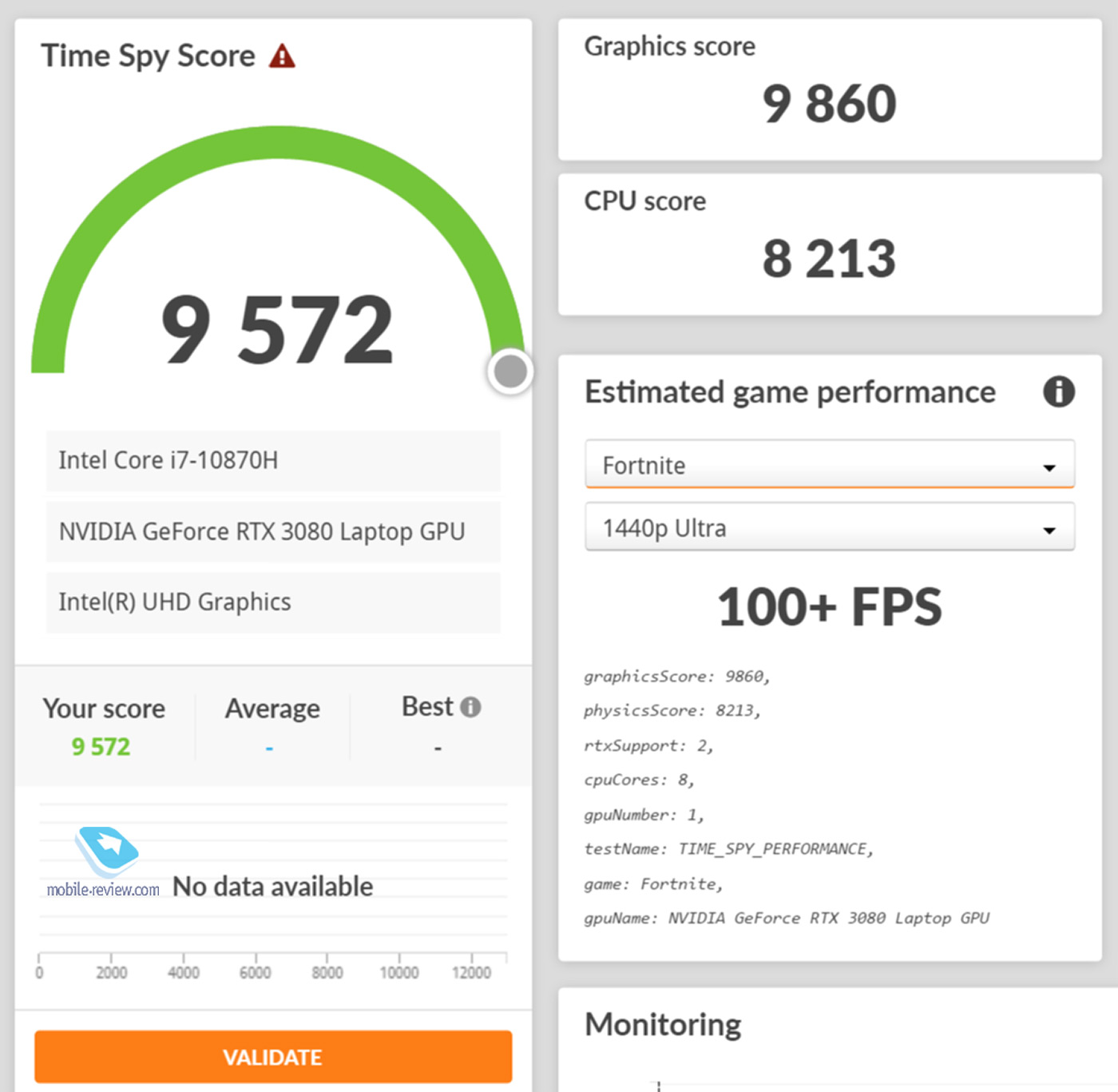

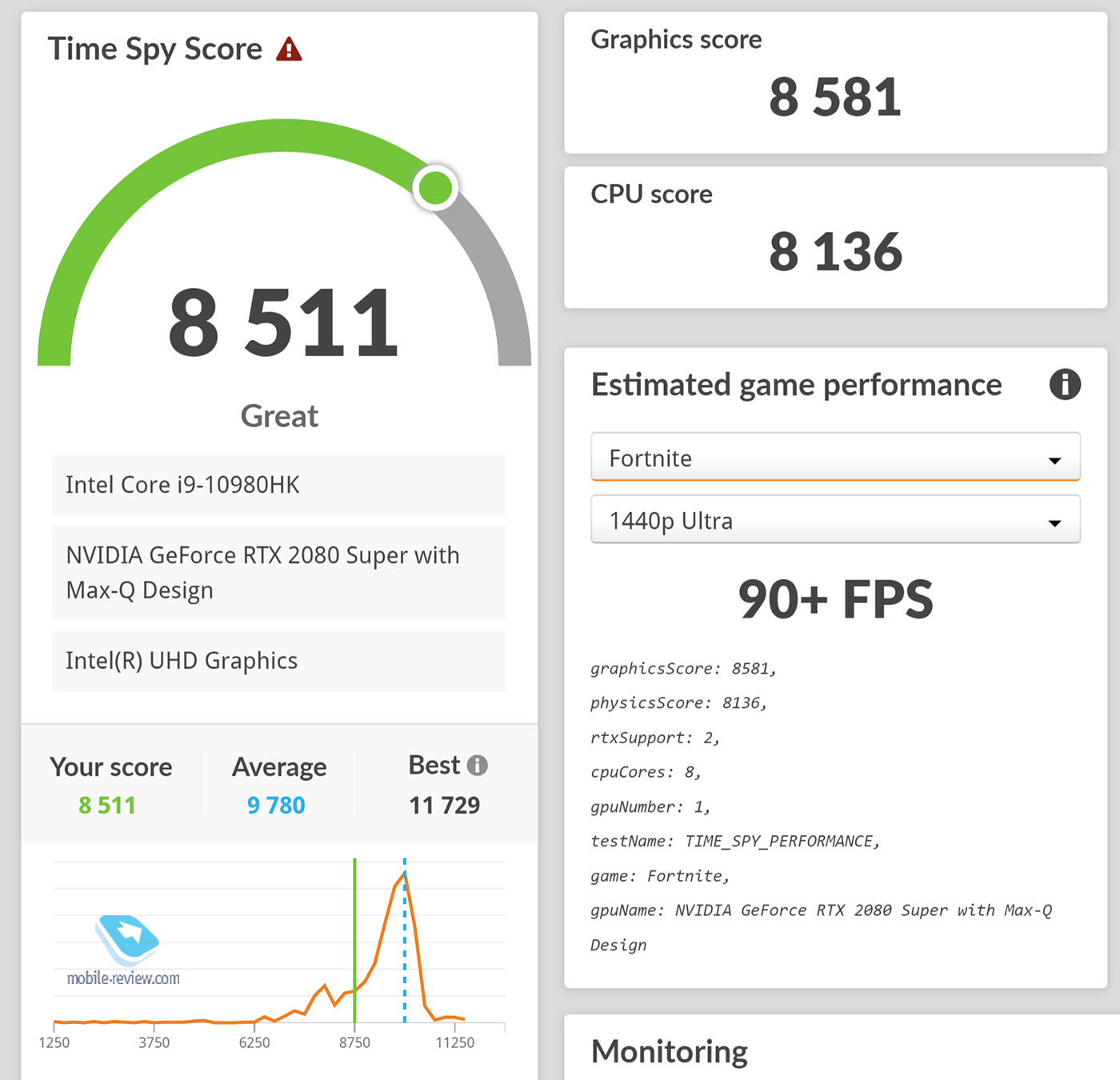

Стоит отметить, что алгоритмы Max-Q Dynamic Boost постоянно улучшаются. Так, на момент своего выхода, она позволяла увеличить производительность некоторых моделей на скромные 5%. Давайте взглянем, как обстоят дела сейчас. В тестировании принимала участие видеокарта GeForce 2070 Max-Q. Тесты проведены в следующих синтетических бенчмарках 3DMark: Time Spy, PortRoyal и Fire Strike Extreme. Вначале даны результаты со включённым Max-Q Dynamic Boost, а после эта функция была выключена.

Dynamic Boost: ON

Dynamic Boost: OFF

Из таблицы выше видно, что активация новой функции способна увеличить производительность в отдельных тестах на 16 и более процентов. Однако есть и такие случаи, когда прирост не превышает 9%. Вот только за всё нужно платить. В первую очередь владельцы ноутбуков заплатят энергопотреблением. Диаграмма ниже показывает, как повышается этот показатель после активации Max-Q Dynamic Boost. Некоторые партнёры компании NVIDIA рекомендуют включать новую технологию только когда ноутбук подключён к сети.

Тест: что умеет Nvidia GeForce RTX 3080 в ноутбуке?

Содержание

Введение

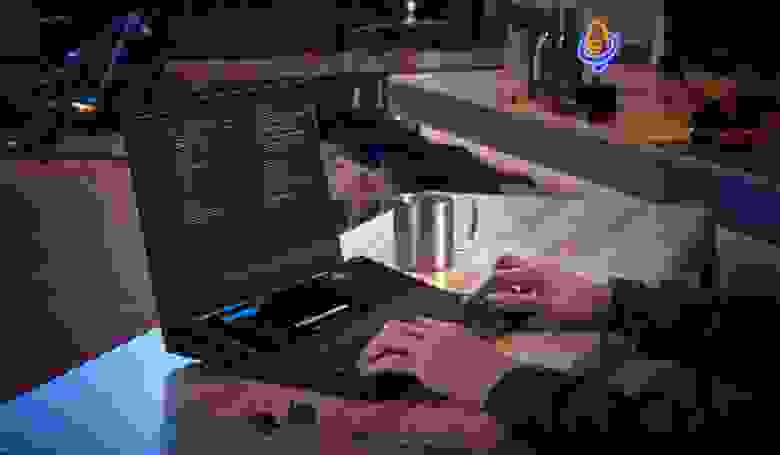

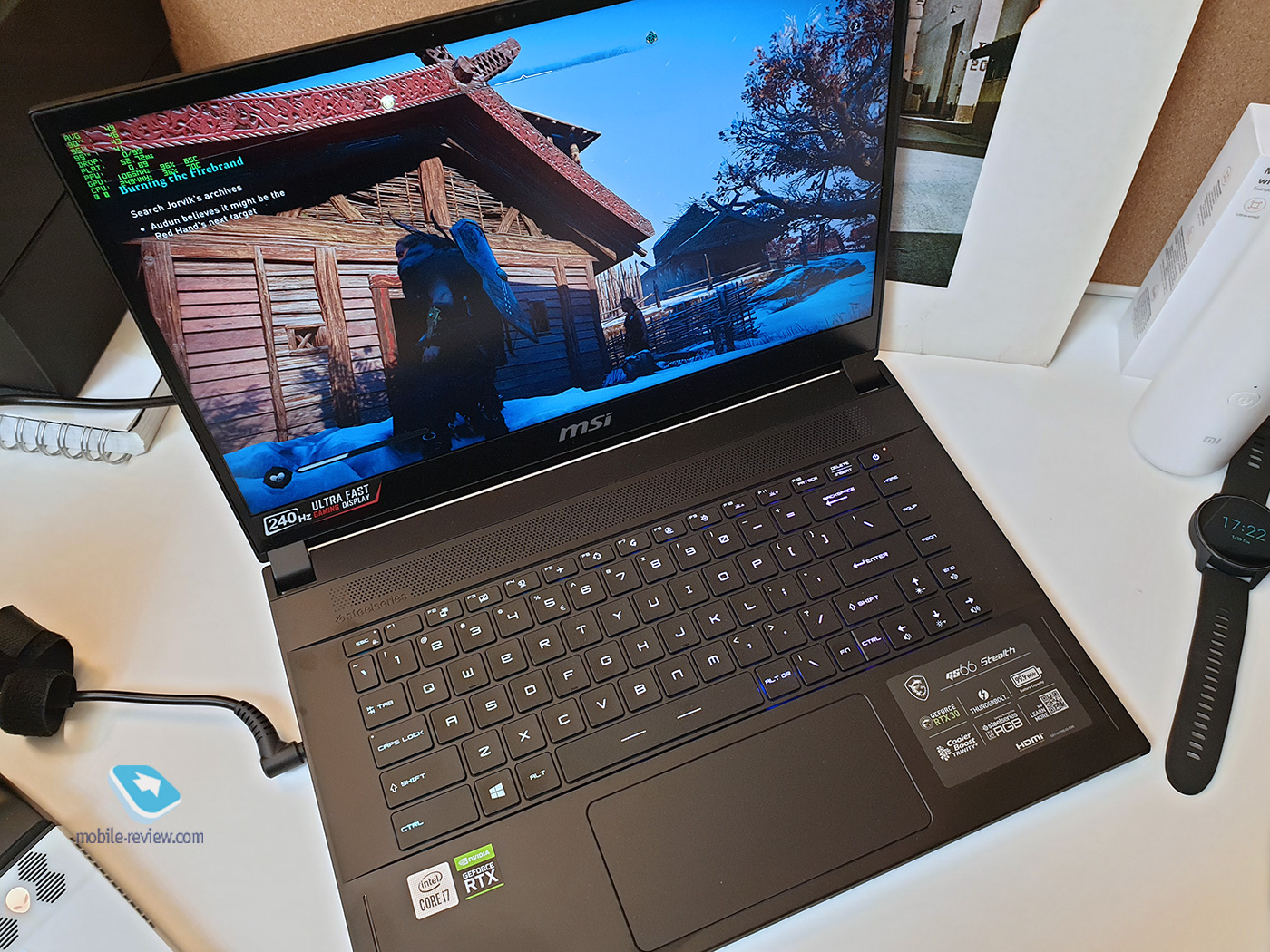

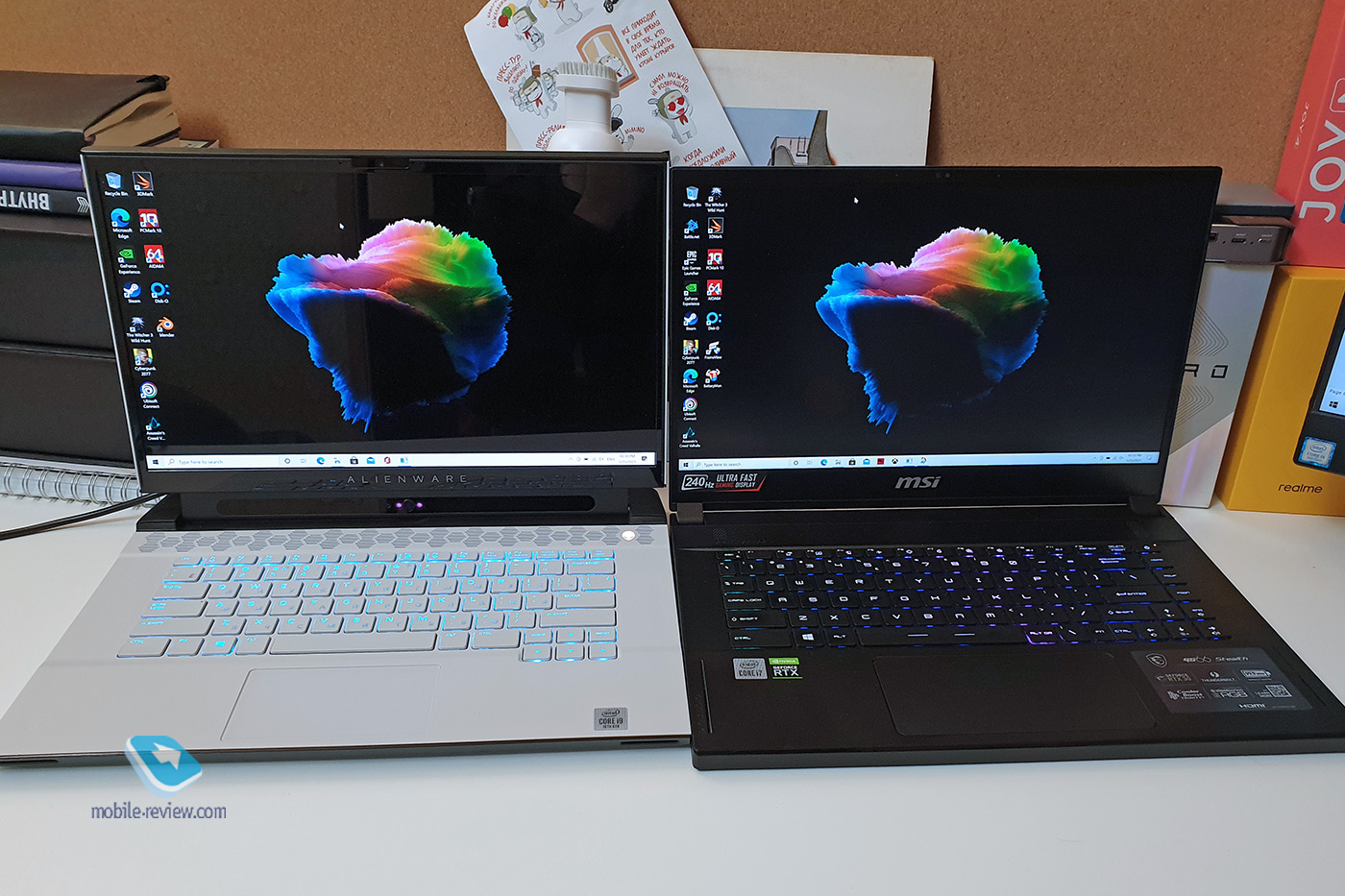

В данный момент у меня на тесте оказалось два чертовски хороших ноутбука. Первый – Dell Alienware с 4К OLED экраном и картой GeForce RTX 2080 Super Max-Q. Тугой сплав потрясающего дизайна и впечатляющей производительности. Второй ноутбук – это MSI GS66 Stealth. Всё субъективно, но визуально он проще, зато у него экран 240 Гц с разрешением 1440p и новая сногсшибательная карта RTX 3080 Laptop GPU, исполненная по технологиям третьего поколения Max-Q дизайна. Каждый ноутбук заслуживает отдельного обзора, материалы выйдут в ближайшее время. А пока, раз есть такая возможность, давайте посмотрим, что умеет новая карта RTX 3080 (очень много всего!), насколько отстаёт RTX 2080 (отстаёт, но не так критично, как может показаться), стоит ли сломя голову бежать за ноутбуками с картами 30-й серии обладателям 20-й серии (можно и повременить, а вот всем остальным стоит обновиться) и может ли игровой ноутбук заменить игровой настольный компьютер или консоль (на 100% может!).

Почему это интересно?

Игры – это новые книги и сериалы

В последние годы индустрия игр получает всё больше внимания. Причин множество. Например, распространение мобильного гейминга приводит к тому, что после смартфонов пользователям начинает хотеться более качественных продуктов и они обращают внимание на компьютеры и консоли. Плюс киберспортивные соревнования вышли из подполья на большие экраны. Доходы киберспортсменов пока что далеки от зарплат футболистов или звёзд ММА, но уже позволяют вести правильный образ жизни.

Ну а пандемия усадила за клавиатуры и геймпады почти всех. Всё-таки, помимо книг и сериалов, нужны и активные развлечения, а игры с их огромными открытыми мирами и невероятной графикой стали в какой-то степени субститутом путешествий.

К тому же истории, рассказанные в хороших играх, зачастую не только не уступают сериалам и литературе, но и превосходят их. Так как, в отличие от книги, в игре именно игроку предстоит совершить сложный выбор – спасти брата или жителей города, отомстить или пощадить, проявить мелочность или щедрость, решить, что важнее, свои интересы или общественные нужды. И каждое решение повлияет на сюжет в целом, развитие событий и судьбы других персонажей.

NVIDIA делает ААА-игры доступными как никогда

30-ая серия видеокарт от Nvidia стала большим событием. Если говорить про десктопные версии, представленные в сентябре 2020 года, откинув все разговоры про технологические инновации, то больше всего впечатлили две вещи: производительность и цена.

Представленный выше график стал широко популярен. Во-первых, оцените разрыв в производительности между RTX 2080 Super и RTX 3080. Для сравнения посмотрите на разницу между 1080 Ti и 2080 или 980 Ti и 1080 Ti. Во-вторых, цена. Nvidia предлагает купить видеокарту, которая по производительности была мощнее, чем 2080 Ti и 2080 Super, по чрезвычайно привлекательной цене.

Однако всё это были десктопные версии. В Интернете быстро появились сравнения размеров новых карт с консолями. Соответственно, сразу же возник вопрос, как перенесут эти технологии в ноутбуки, особенно учитывая тот факт, что Nvidia продвигала идею тонких игровых ноутбуков (толщиной 18 мм), ставших возможными благодаря Max-Q дизайну видеокарт.

Будем откровенны, несмотря на все усилия производителей, до сих пор у многих в голове крепко сидит мнение, что для игр нужен игровой настольный компьютер, а если речь про ноутбук, то это должен быть пятикилограммовый ящик толщиной с ладонь.

С картами RTX 30-й серии скептикам будет всё сложнее отрицать очевидный факт, что новый игровой компьютер – это не гроб на колёсиках, а тонкая и лёгкая машинка, позволяющая в удовольствие играть на настройках «Ультра» в разрешении 1440p и 4К.

Главные факты и тесты

Что представляет собой лэптоп с картой RTX 3080 Laptop GPU 16 ГБ?

В качестве подопытного образца выступил MSI GS 66 Stealth.

Основные технические характеристики:

Когда представили консоли нового поколения, было много разговоров, как быстро грузятся игры. Это казалось феноменально круто. Но ноутбуки не отстают! 44 секунды занимает старт Cyberpunk 2077 начиная с клика на иконку рабочего стола, потом надо нажать «Продолжить игру», и вот уже можно управлять героем. Загрузка Assassin’s Creed: Valhalla из главного меню (нажать «Продолжить») занимает 6-7 секунд. И это очень хорошо!

Говоря про видеокарту, следует отметить, что в данном ноутбуке стоит версия на 16 ГБ. Такое количество памяти в большей степени оценят те, кто занимается рендерингом графики. Остальные могут сэкономить и взять 8 ГБ. За время теста ни одна игра больше 6 ГБ памяти не потребовала.

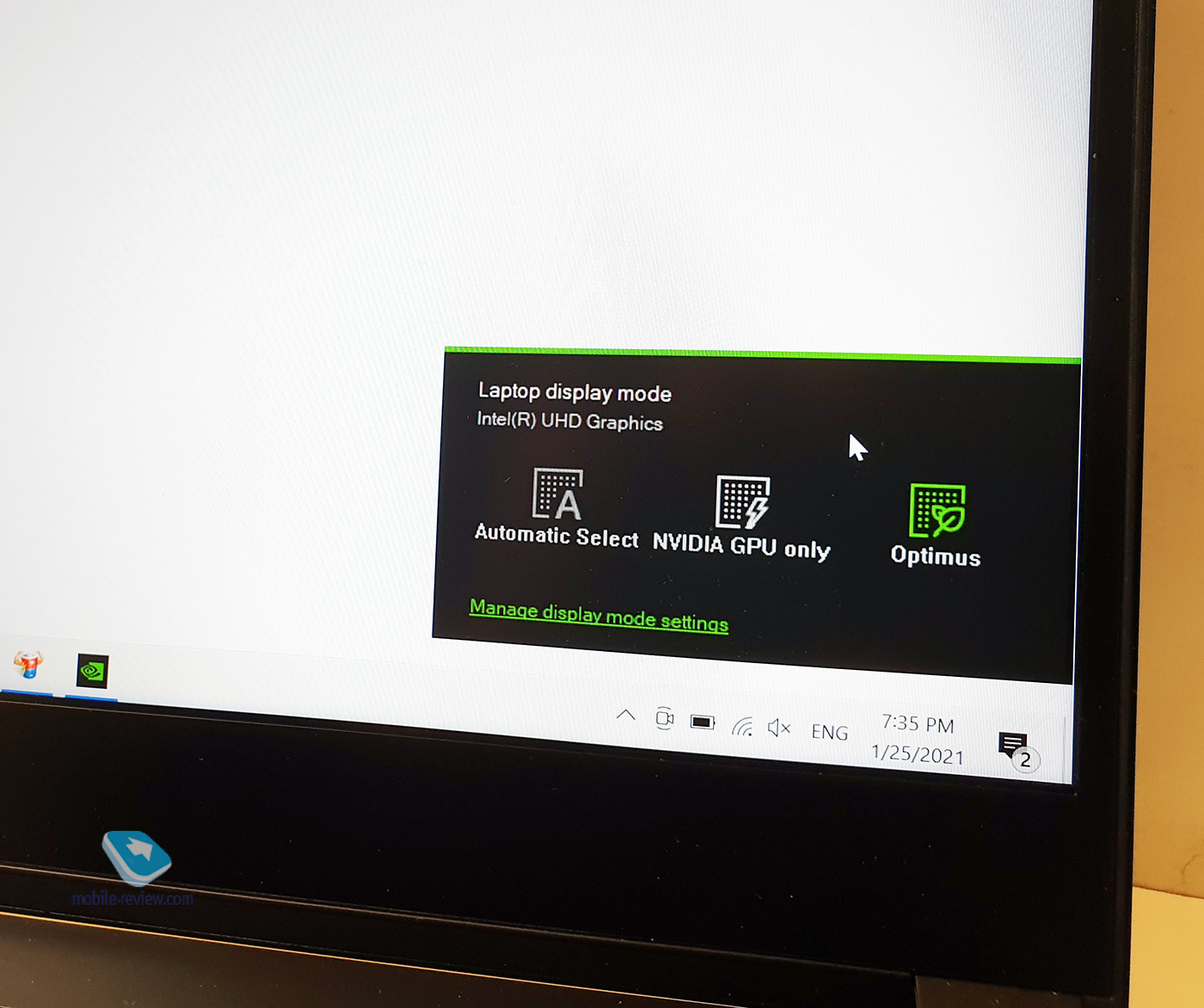

К слову, одна из приятнейших особенностей новых ноутбуков (впрочем, она стала доступна ещё в RTX 20-серии Super) – это Advanced Optimus. Полагаю, все геймеры знают, что такое G-Sync. Для остальных поясню. Нередко так бывает, что экран не успевает за видеокартой обновлять картинку, происходит небольшая рассинхронизация, и возникают так называемые разрывы. Зачастую это бывает в играх, в которых видеокарта выдаёт высокое количество кадров в секунду. Nvidia придумала, как синхронизировать частоту экрана с видеокартой, и назвала технологию G-Sync. Вещь классная, но был один минус. Чтобы всё работало гладко, Nvidia запрещала интегрированную графику. Таким образом, ноутбук всегда использовал дискретную графику, из-за чего время автономной работы значительно снижалось.

Advanced Optimus позволил исправить этот неприятный момент. Теперь ноутбук с экраном G-Sync способен переключаться между видеокартами. Например, с дискретной видеокартой ноутбук способен проработать 3-3.5 часа. Переключение в режим Optimus даёт уже около 6 часов работы, а это совсем другая история.

Основные постулаты были заявлены в недавней презентации, когда Nvidia с лёту заявила, что даже ноутбуки с GeForce RTX 3060 в 1.3 раза быстрее, чем дефицитная PlayStation 5. GeForce RTX 3080 идёт ещё дальше и берёт планку в 100 fps на настройках «Ультра» в разрешении 1440p.

Однако давайте по порядку.

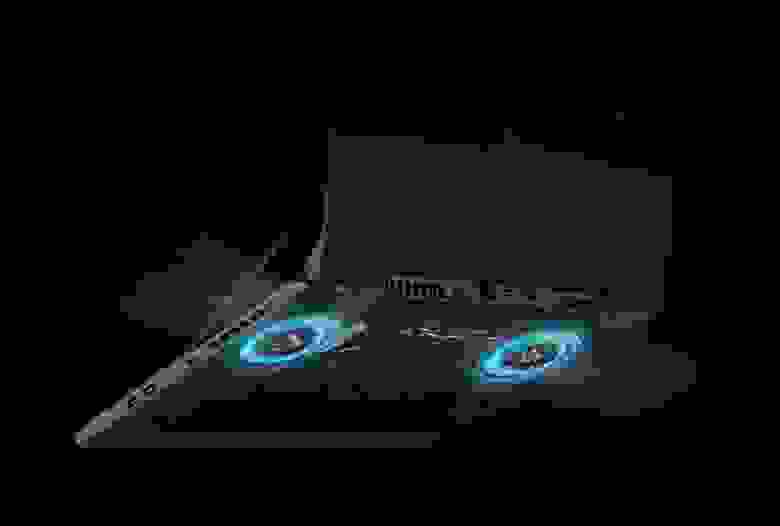

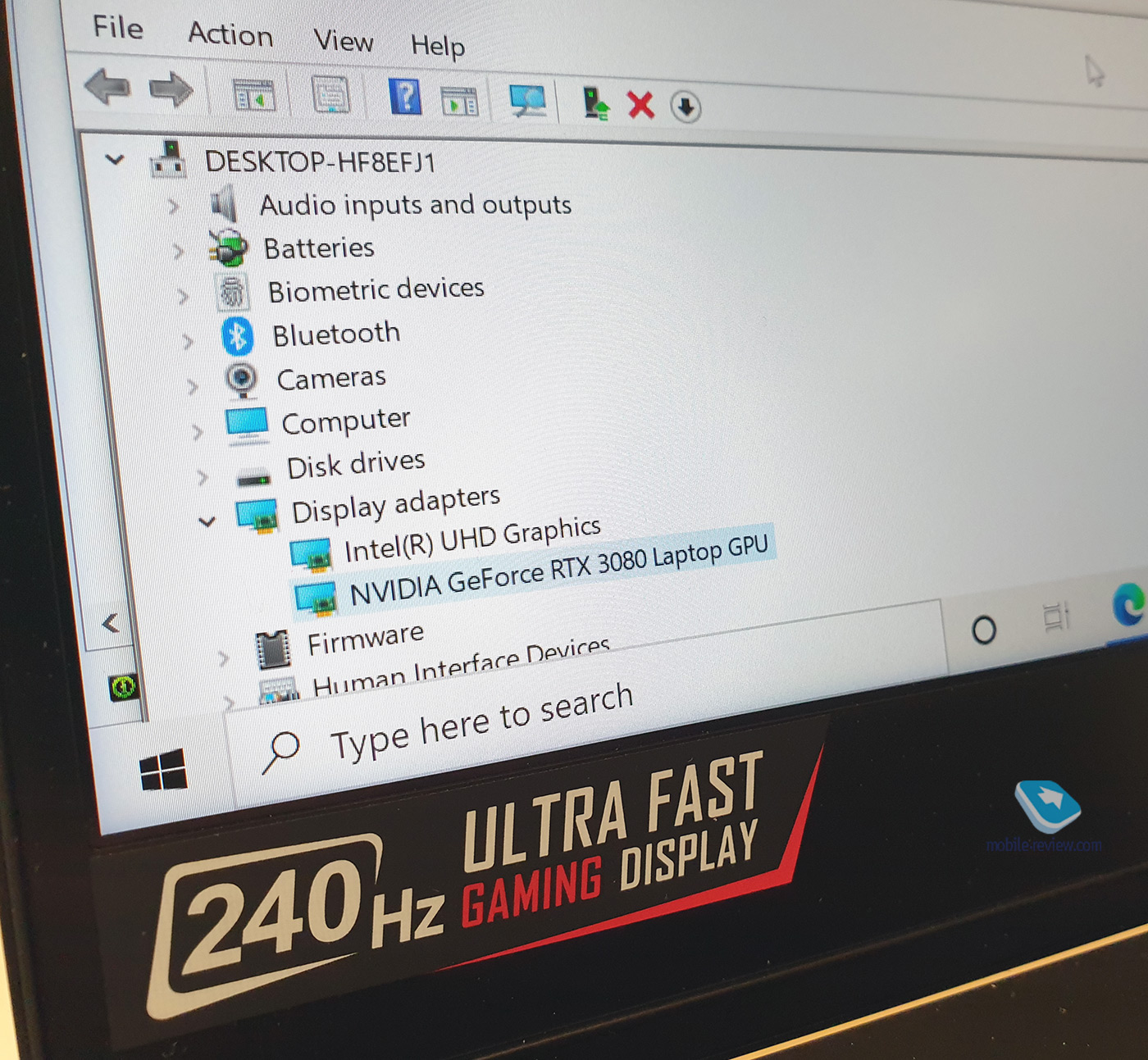

Новые видеокарты для ноутбуков основаны уже на третьем поколении технологии Max-Q. К слову, приятная новость. Теперь Max-Q видеокарты могут работать как с процессорами Intel, так и AMD. Главное визуальное отличие заключается в том, что Nvidia спрятала название Max-Q. Если заглянуть в список устройств, можно увидеть приписку Laptop GPU. Max-Q же теперь позиционируется как комплекс технологий.

Так, например, Max-Q 3-го поколения включает в себя:

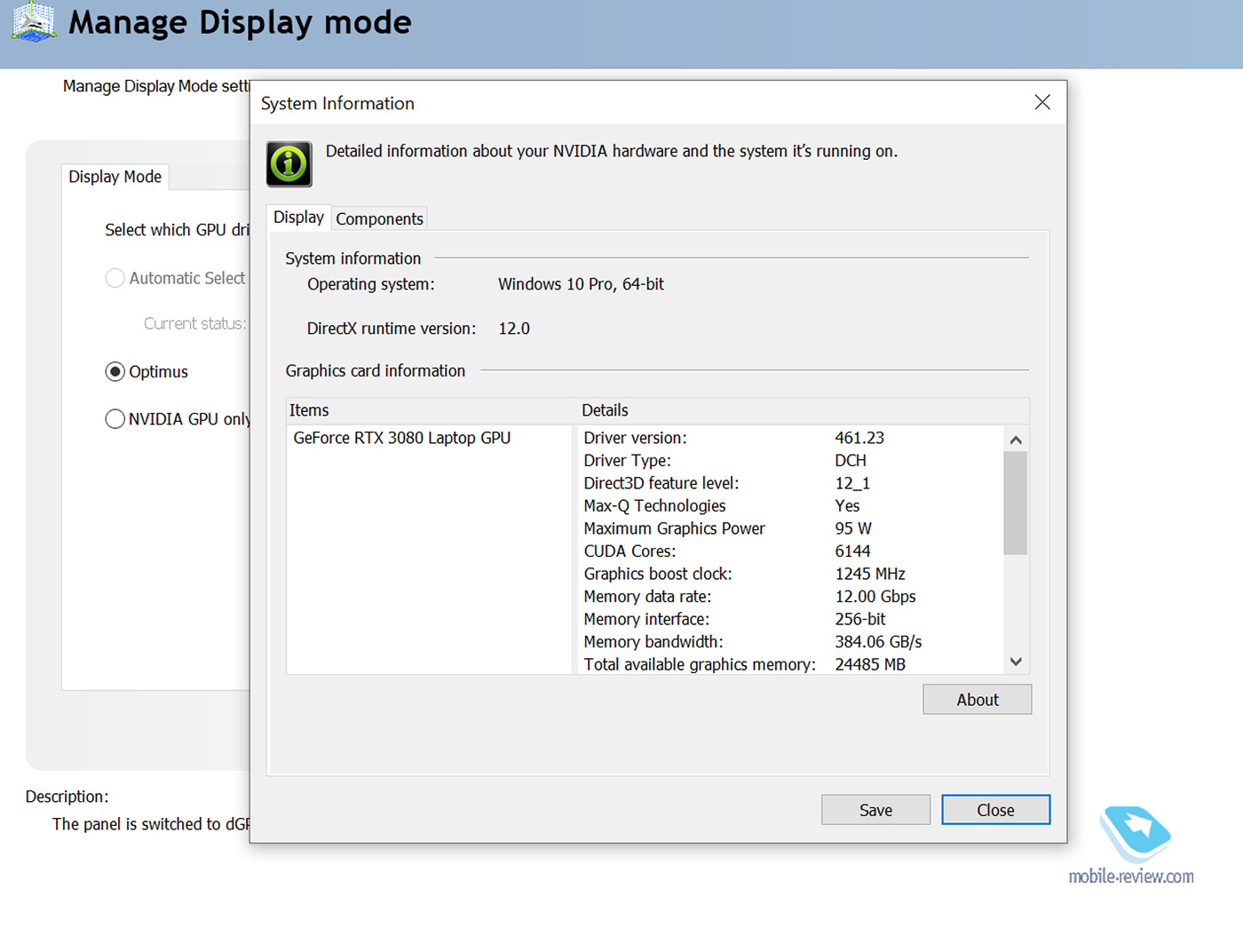

Ну а чтобы узнать, используется ли технология Max-Q в конкретной видеокарте, надо зайти в контрольную панель Nvidia. Там же, кстати, можно посмотреть, сколько потребляет видеокарта. Также Nvidia обещает, что производители будут давать эту информацию на сайтах.

Уже долгое время игровые ноутбуки выходят с экранами Full HD. В какой-то степени это было оправдано. Тут и относительно небольшие экраны, да и в целом производительности для 4К гейминга не всегда хватало. 20-ая серия RTX видеокарт сдвинула дело с мертвой точки, и в продаже стало появляться больше вариантов с экранами, отличными от Full HD. Однако всё это были опциональные и довольно редкие решения, как, например, Dell Alienware с 4К OLED экраном, у которого основные варианты предусматривали экран с разрешением 1920 на 1080 точек.

GeForce RTX 30-й серии – это игры в разрешении 2560 на 1440 точек по умолчанию. С подобным разрешением типичный 15.6-дюймовый дисплей превращается в ретина-дисплей, когда глаз не может различить отдельный пиксель. Здесь действует простое правило: чем больше пикселей, тем чётче изображение. Скажу честно, это большое удовольствие – после Full HD перейти на 1440p.

Стандарт Full HD уходит в прошлое. Ему на замену приходит Quad HD. И, пожалуй, это изменение, которое заметят даже те, кто не интересуется играми. Вероятно, ультрапортативные ноутбуки ещё какое-то время будут выходить с Full HD экранами, но с рынком и потребителями не поспоришь. Распространение 1440p ноутбуков приведет к тому, что все захотят подобное разрешение.

Dynamic Boost 2.0 – одна из главных технологий в новых видеокартах. Если коротко, то она занимается распределением энергии между CPU и GPU. Традиционно распределение мощностей было статистическим и определенным изначально. Однако зачастую, особенно в играх (в зависимости от разных игровых сцен), нагрузка распределяется неравномерно между процессором и видеокартой. Первая версия Dynamic Boost могла забрать у процессора и перенаправить энергию на видеокарту.

Обновленная версия Dynamic Boost 2.0 гораздо лучше. Во-первых, искусственный интеллект ещё более точно помогает распределять энергию. Во-вторых, теперь не только CPU может поделиться энергией с видеокартой, но и наоборот.

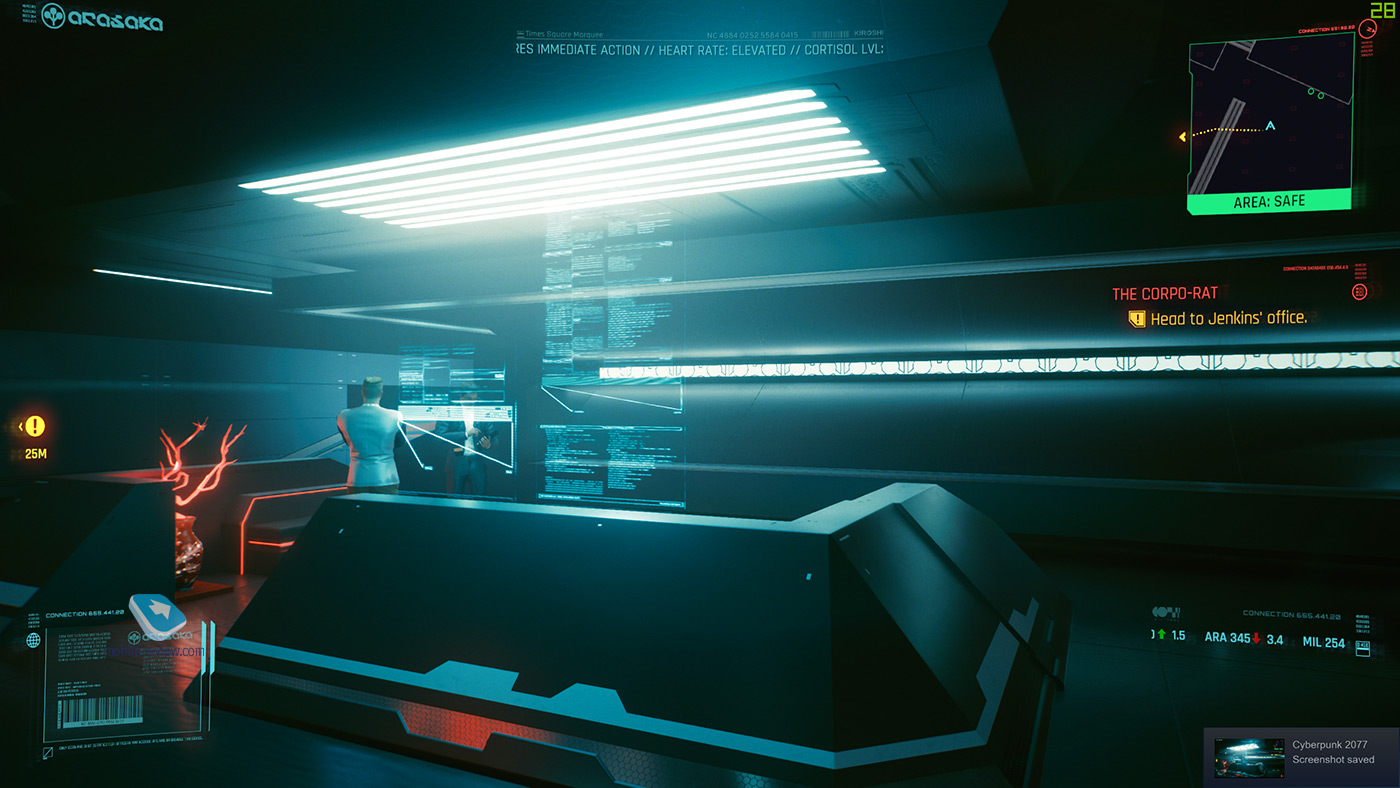

Для проверки того, как распределяется энергия между процессором и графикой, можно скачать приложение FrameRate, которое занимается мониторингом показателей (в левом верхнем углу на картинке выше). Проще всего заметить разницу при смене настроек графики. Чем выше настройки графики, тем больше энергии забирает видеокарта и меньше получает процессор, и наоборот. И в Assassin’s Creed Valhalla и Cyberpunk 2077 распределение энергии не сильно заметно, а вот в «Метро: Исход» на низких настройках графики CPU / GPU – 45 Вт / 69.6 Вт, на настройках «RTX + DLSS On» CPU / GPU – 19.6 Вт / 92.9 Вт.

К сожалению, сам пользователь не может замерить прирост производительности от Dynamic Boost 2.0, так как технология активирована по умолчанию. Но по замерам самой Nvidia прирост производительности составляет от 10% до 16% в зависимости от игры. Таким образом, благодаря технологии игрок просто получает примерно 10 fps дополнительно.

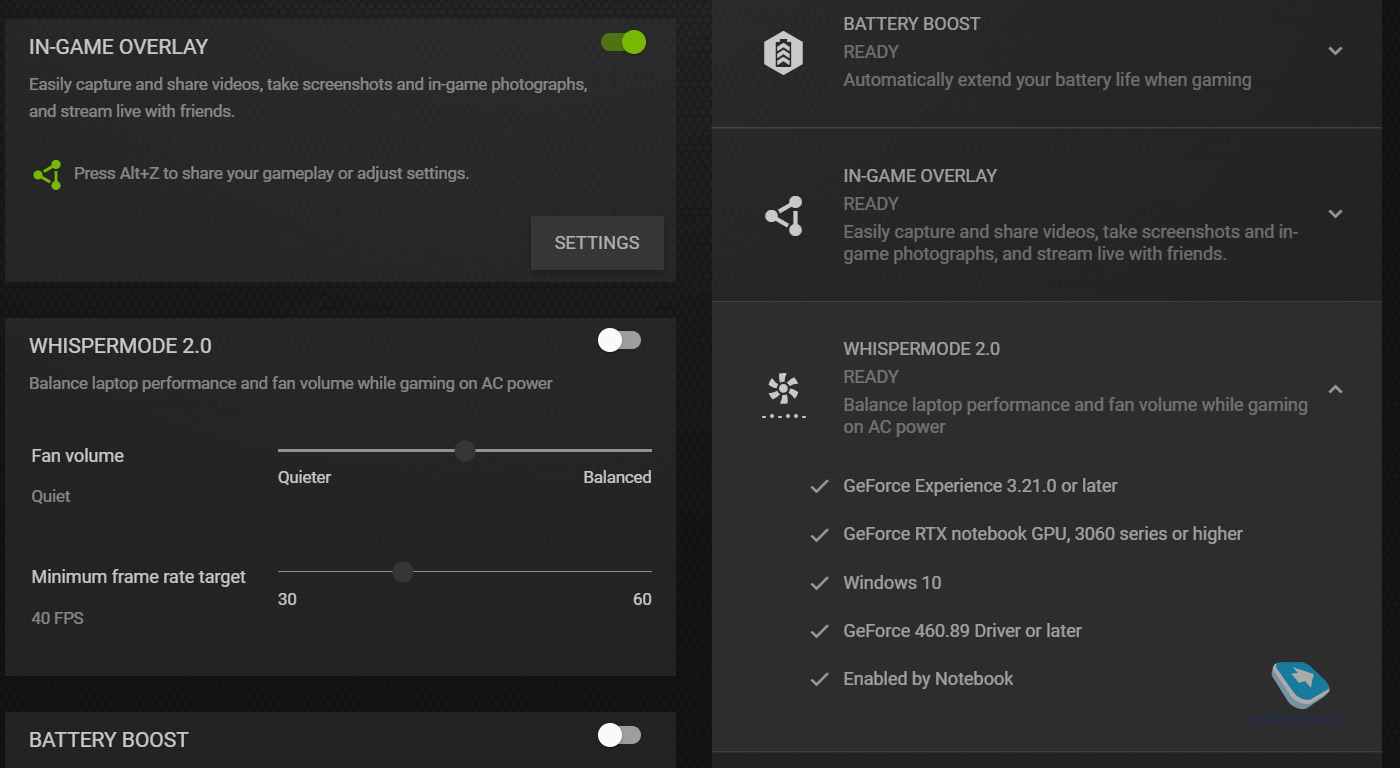

Whispermode 2.0 – это технология, созданная, чтобы сделать игровые ноутбуки бесшумными, если говорить языком маркетинговых слоганов. А если по-простому, то это попытка найти баланс между частотой кадров и шумом вентиляторов. Whispermode 2.0 – это только для ноутбуков с картами 30-й серии, так как тут не только софт, но и аппаратные механизмы.

В GeForce Experience есть три варианта – сбалансированный, тихий и самый тихий. Также там надо выставить частоту кадров, к которой система должна стремиться (от 30 до 60 fps).

Профессионального шумомера у меня нет, так что пришлось воспользоваться приложением на смартфоне. В обычном режиме в игре Cyberpunk 2077 смартфон, лежащий рядом с отверстиями для вентиляции, показал уровень шума в 58 дБ, а в максимально тихом режиме Whispermode 2.0 с 30 fps – уже 49 дБ.

На картах RTX 20-й серии также есть Whispermode (но не 2.0), и доступен он, если активировать режим экспериментальных функций. На ноутбуке Dell Alienware с картой RTX 2080 Super получилось 59 дБ в обычном режиме и 48-54 дБ в Whispermode. На мой взгляд, главное отличие в том, что в Whispermode 2.0 ноутбук стабильно работает с уровнем шума 49 дБ. А в предыдущем поколении сначала работает тихо, потом разгоняется до 53-54 дБ (видимо, охлаждается), затем снова возвращается в тихий режим. Субъективно, из-за подобного Whispermode 2.0 воспринимается гораздо круче, потому что через небольшой промежуток времени забываешь про шум вентиляторов. Предыдущее же поколение регулярно напоминает о себе.

Разные серии видеокарт, но толщина у обоих ноутбуков одинаковая.

Откровенно говоря, пожалуй, это моя любимая технология от Nvidia. DLSS, или Deep Learning Super Sampling – это технология, когда обученный искусственный интеллект достраивает картинку. DLSS прошла долгий путь. Первая версия технологии не взлетела, так как для обучения ИИ под каждую задачу (игру) требовалось создавать отдельный полигон для тренировок. А это непростая и накладная вещь, поэтому разработчики попросту саботировали DLSS 1.0. В DLSS 2.0 всё иначе. Теперь для каждой игры не нужно отдельно тренировать ИИ, и разработчикам гораздо проще внедрить технологию в игру.

Например, DLSS 2.0 в игре Cyberpunk 2077 творит чудеса, позволяя получить до 80 fps. К слову, настройки DLSS теперь изменились. Раньше у опции было два положения, «вкл.» и «выкл.». Теперь пользователю доступно несколько вариантов – авторежим, упор на качество картинки, сбалансированный режим, производительность и ультрапроизводительность.

К слову, DLSS 2.0 позволяет играть в Cyberpunk 2077 на средне-высоких настройках и 40 fps от батареи. Долго играть вы сможете, батареи хватит на 1 час 15 минут, но само по себе это очень хорошо.

В Cyberpunk 2077 в разрешении 2560 на 1440 точек карта RTX 3080 для ноутбуков способна выдавать около 30 fps в настройках «Ультра» с максимальной трассировкой лучей. Если к данной опции добавить DLSS 2.0, то производительность составит уже 54-56 fps. Если поставить трассировку лучей в среднее положение, то можно получить 80 fps.

Вероятно, выбор режима DLSS 2.0 зависит от конкретной игры, так как в Cyberpunk 2077 значительной разницы в текстурах в разных режимах я рассмотреть не смог. Точнее, если вы откроете в оригинальном разрешении и приглядитесь к иголкам сосны, то можно заметить, что в оригинальном изображении как будто чуть выше резкость, чем на картинке с 80 fps.

Исторически повелось так, что профессионалы, работающие с графикой, покупали видеокарты серии Quadro. Однако сегодня очевидно, что работа с графикой – это не только удел профессионалов. Куда ни глянь, везде блогеры и контент-креаторы, которые предпочитают покупать более широко распространенные ноутбуки с GTX и RTX видеокартами. В качестве ответа на ситуацию Nvidia придумала отдельный драйвер для тех, кто работает с графикой. Его можно выбрать в приложении GeForce Experience.

Внутренняя аналитика компании показала, что драйвер стал пользоваться популярностью. И если раньше он обновлялся раз в несколько месяцев, то теперь новая версия выходит каждый месяц и нередко бывает привязана к обновлению того или иного профессионального софта.

В RTX 3080 постарались учесть потребности работающих с графикой. Специально для них есть версия видеокарты с 16 ГБ оперативной памяти вместо стандартных 8 ГБ.

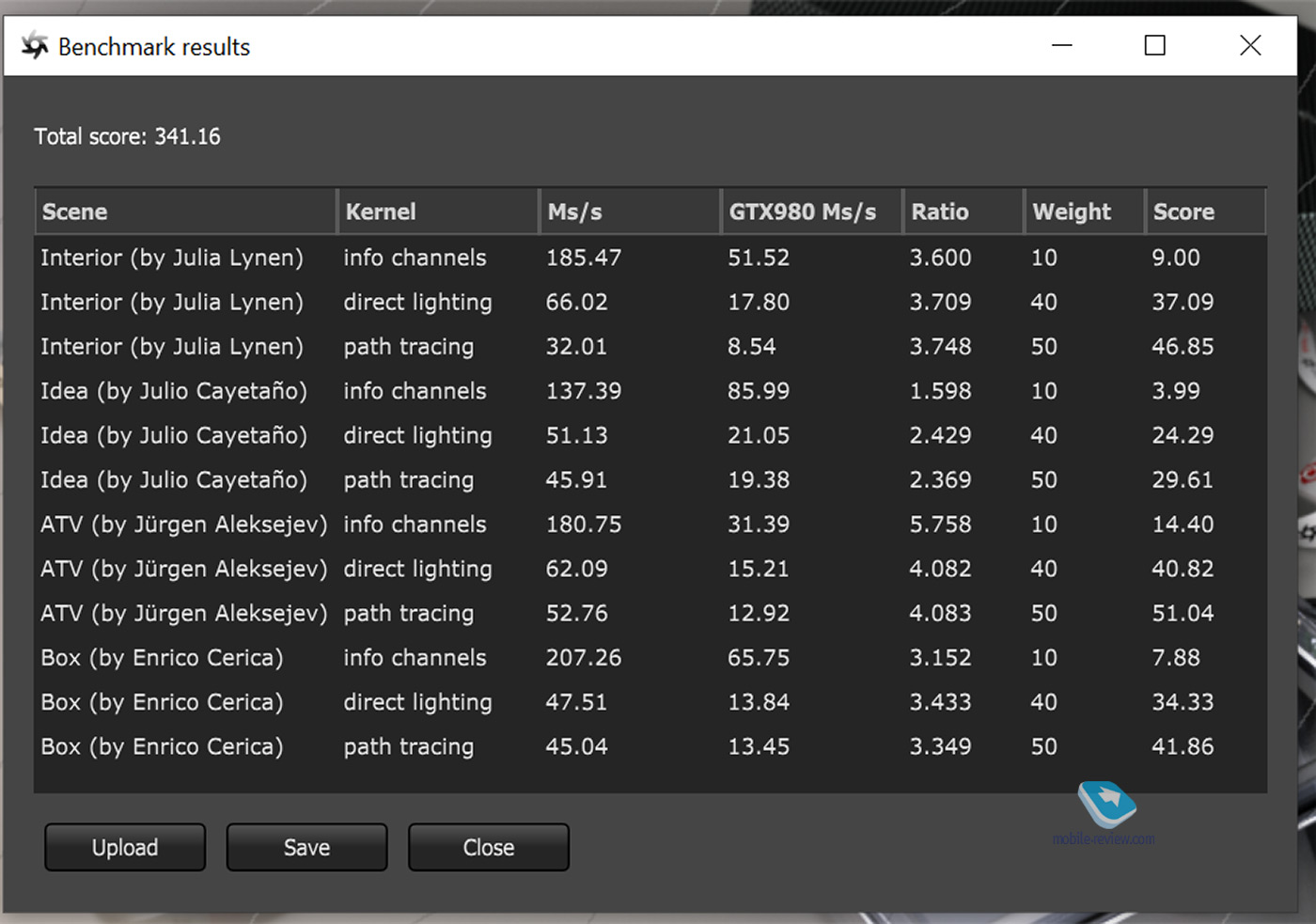

В целом, в новых видеокартах и второе поколение RT-ядер, и больше памяти. Всё это даёт значительный прирост производительности. Например, бенчмарк для рендеринга Octanebench показывает прирост производительности примерно в 1.5 раза по сравнению с RTX 2080 Super. Бенчмарк V-Ray показывает рост 2х.

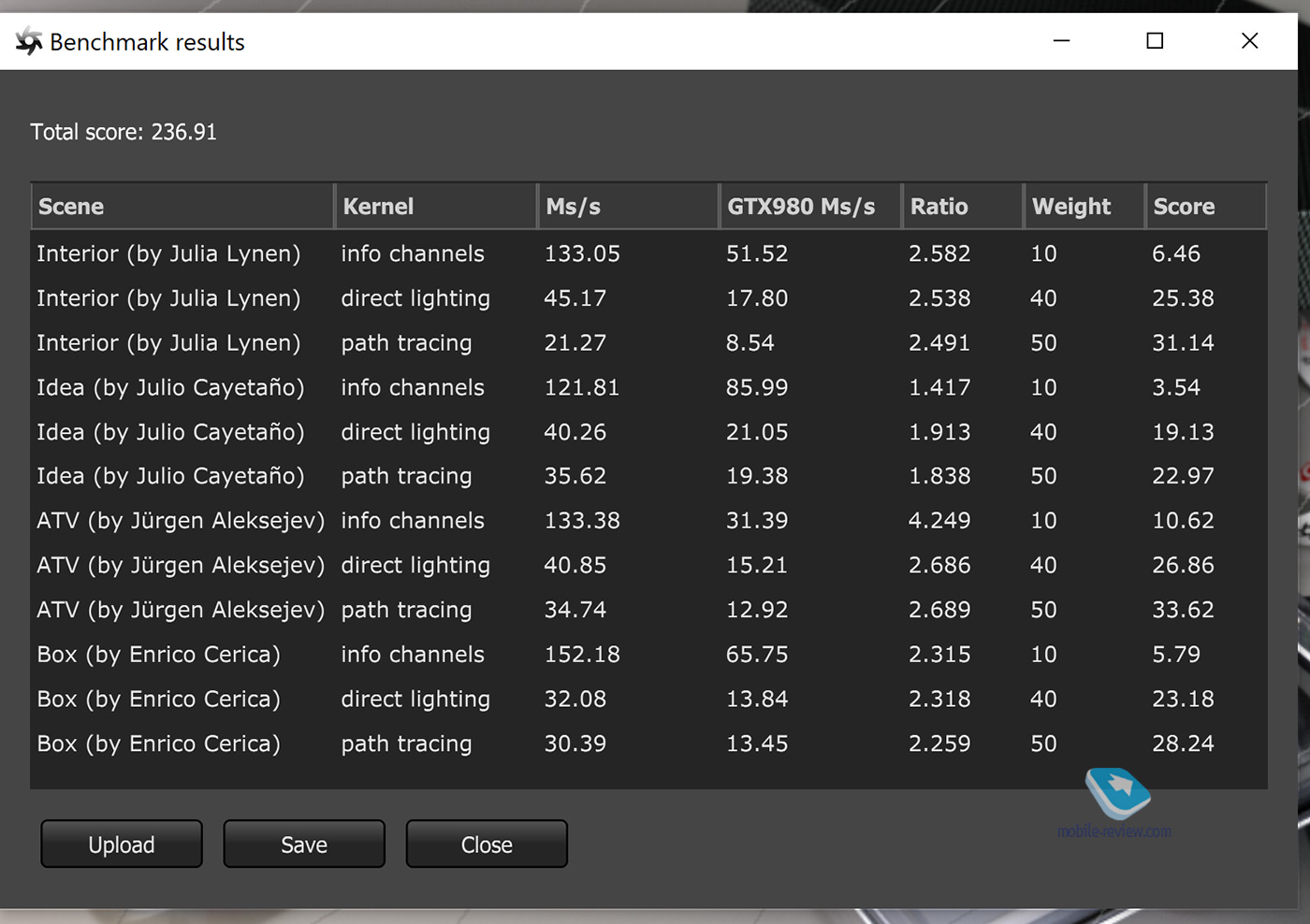

Ниже – скриншоты Octanebench. У RTX 2080 Super 236 баллов, у RTX 3080 Laptop GPU – 341 балл.

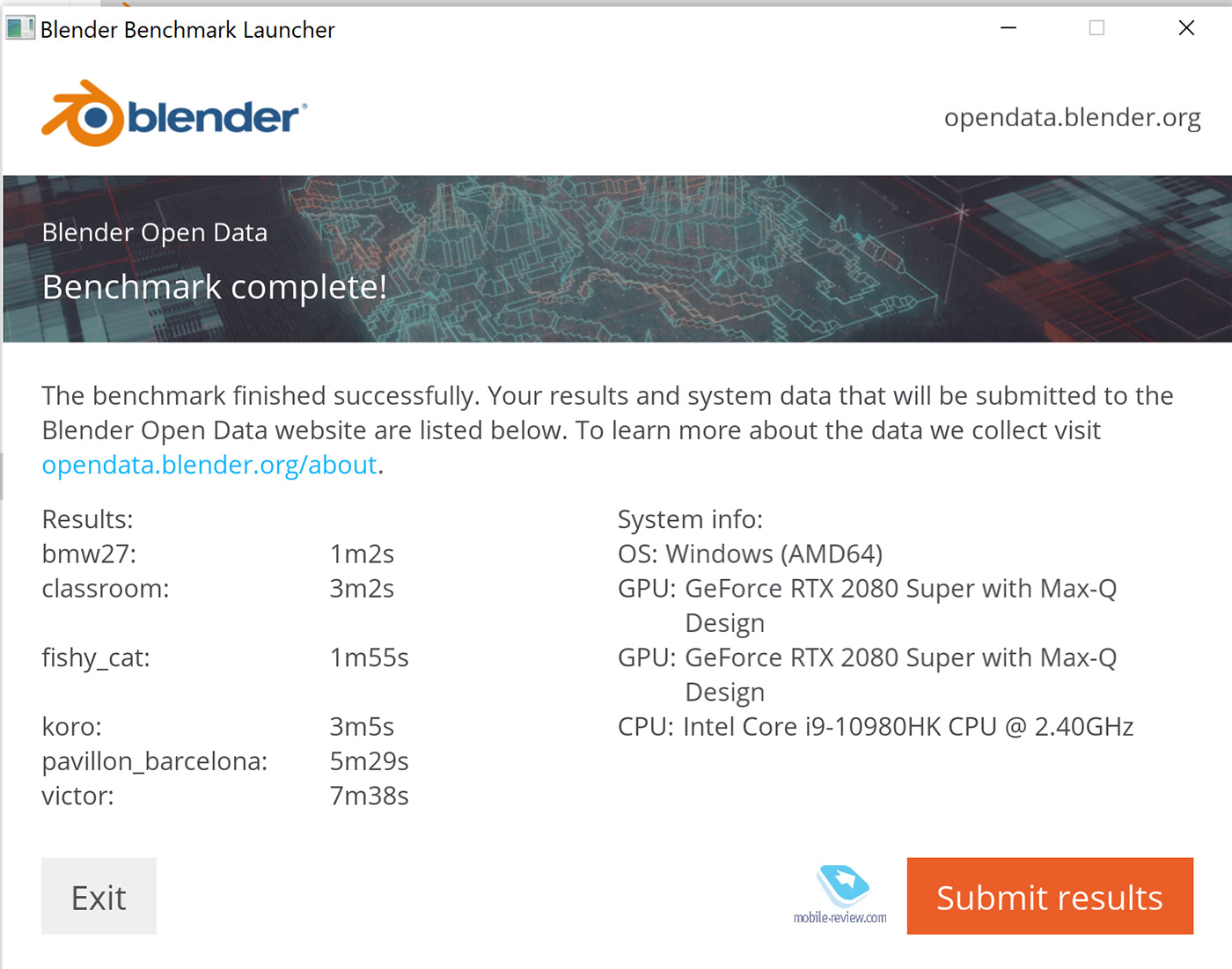

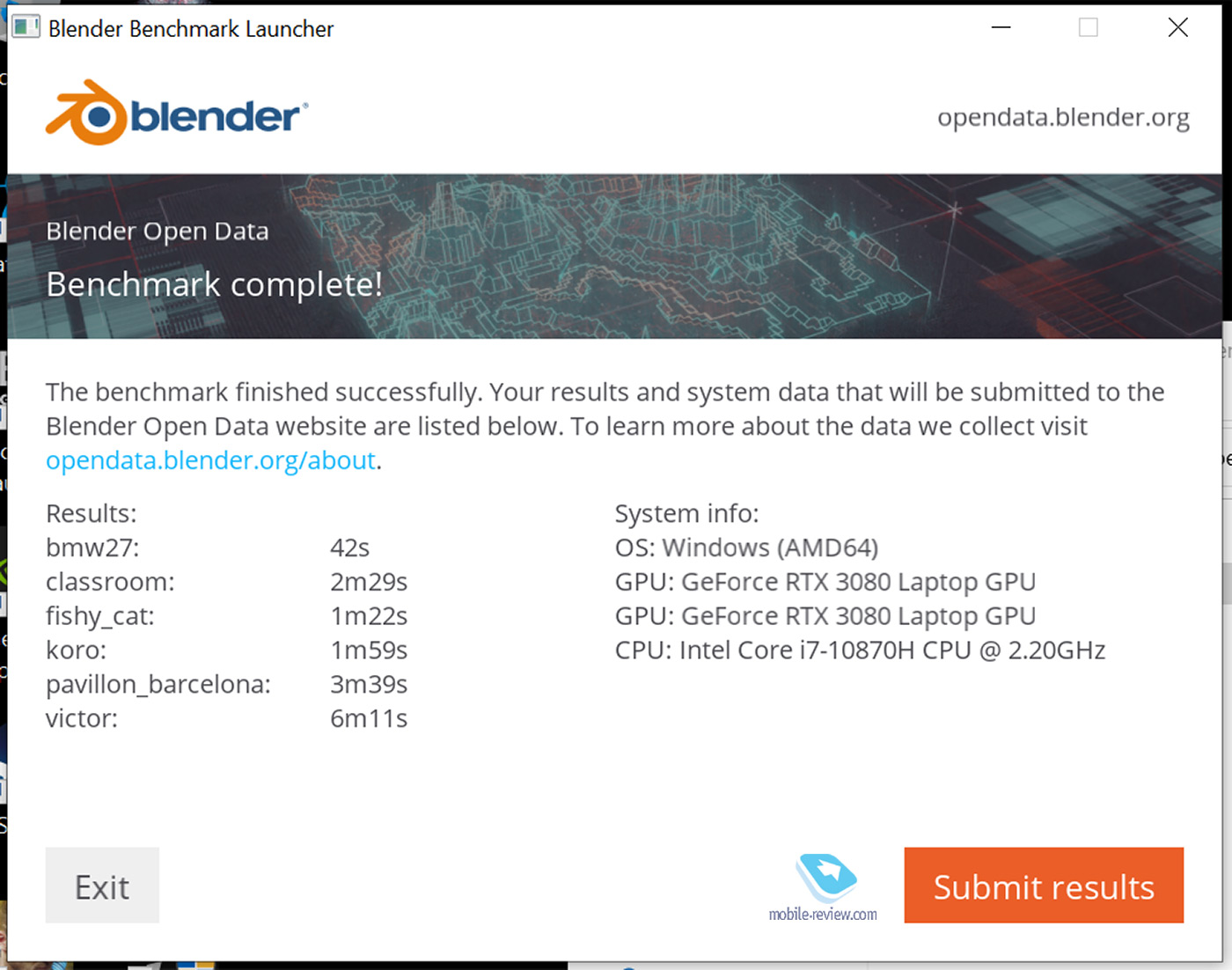

А вот Blender бенчмарк. Выигрыш RTX 3080 Laptop GPU значительный. Карта гораздо быстрее проходит тесты.

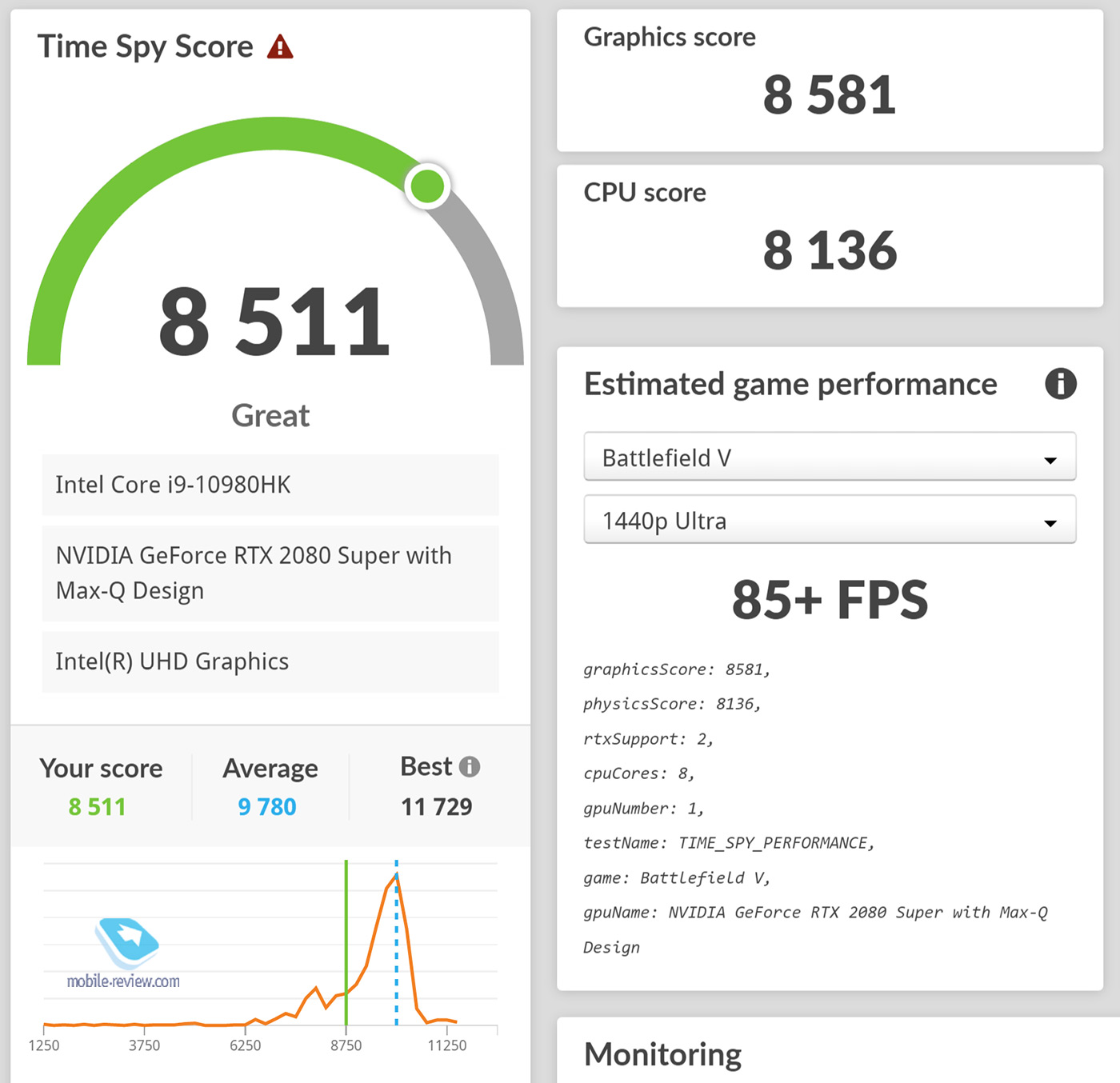

Насколько впереди RTX 3080 Laptop GPU по сравнению с RTX 2080 Super Max-Q?

Пожалуй, сразу успокою всех владельцев ноутбуков с RTX 2080 Super Max-Q. У вас отличная видеокарта, которая будет радовать вас ещё многие годы.

RTX 3080 Laptop GPU, безусловно, лучше. И если замерять в процентах, то разница покажется более чем значительной. Здесь и далее говорим про разрешение 1440p (новый стандарт всё-таки) и настройки «Ультра».

К сожалению, фотография не передаёт всю безграничную глубину черного цвета OLED-экран Dell Alienware. Впрочем, у MSI GS66 экран тоже шикарный. Мощное антибликовое покрытие и без засветов.

Например, в Assassin’s Creed: Valhalla прирост составляет почти 40%, то есть 41 fps у 2080 Super Max-Q против 57 fps.

В Cyberpunk 2077 разница в процентах составляет 25-40% в зависимости от того, как играться с настройками. Всё-таки DLSS 2.0 – это вещь! Но всё равно больше 60 fps на RTX 2080 Super у меня выбить не получилось, в то время как RTX 3080 Laptop GPU отлично выбивает 80 fps. Другой момент, что OLED-экран в Alienware даст 100 очков вперёд.

Ну и, разумеется, я не мог не запустить бенчмарк на века «Ведьмак 3». Радует, что обе видеокарты позволяют играть на максимальных настройках. RTX 2080 Super Max-Q выдаёт стабильные 60 fps, в то время, как 3080 Laptop GPU – «целых» 76 fps. Не хватает тут, конечно, DLSS и трассировки лучей.

В цифрах разница значительная, но если не брать соревновательные игры (Fortnite или Call of Duty), то заметите ли вы разницу между 60 и 80 fps или просто будете играть и наслаждаться игрой, не обращая внимания?

В Microsoft Flight Simulator на настройках «Ультра» частота кадров прыгает в диапазоне 45-60 fps. Как я понимаю, тут ещё надо учитывать, что игра постоянно качает данные из интернета.

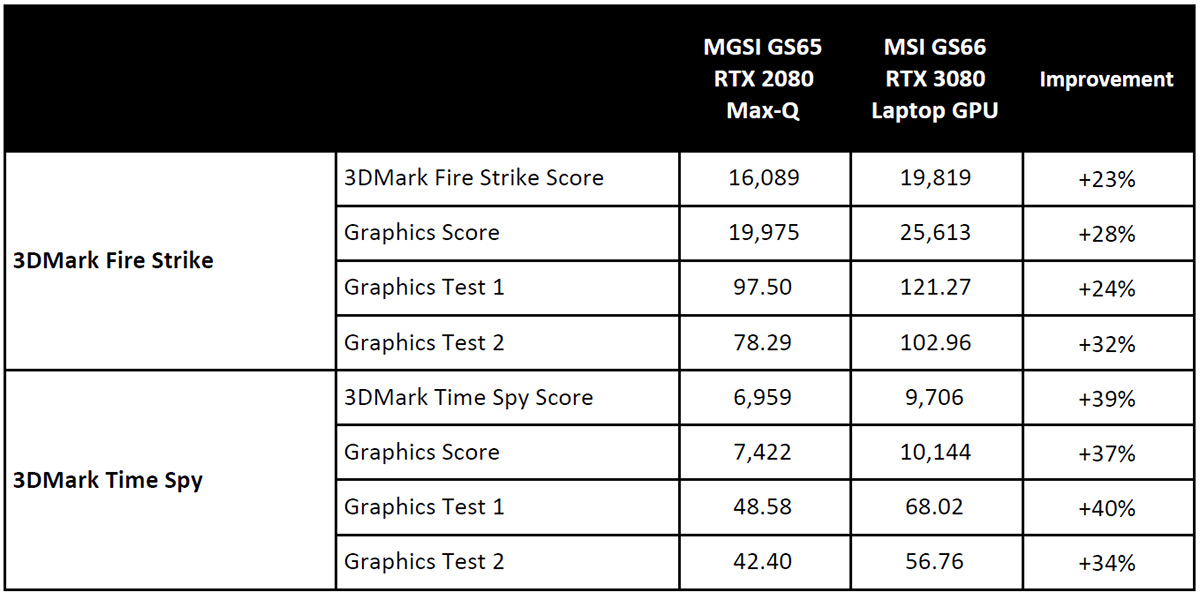

Напоследок – немного синтетических тестов. Nvidia поделилась вот такой табличкой, показывающей, как доминирует RTX 3080 Laptop GPU. Вероятно, вы будете часто видеть эту таблицу в Интернете.

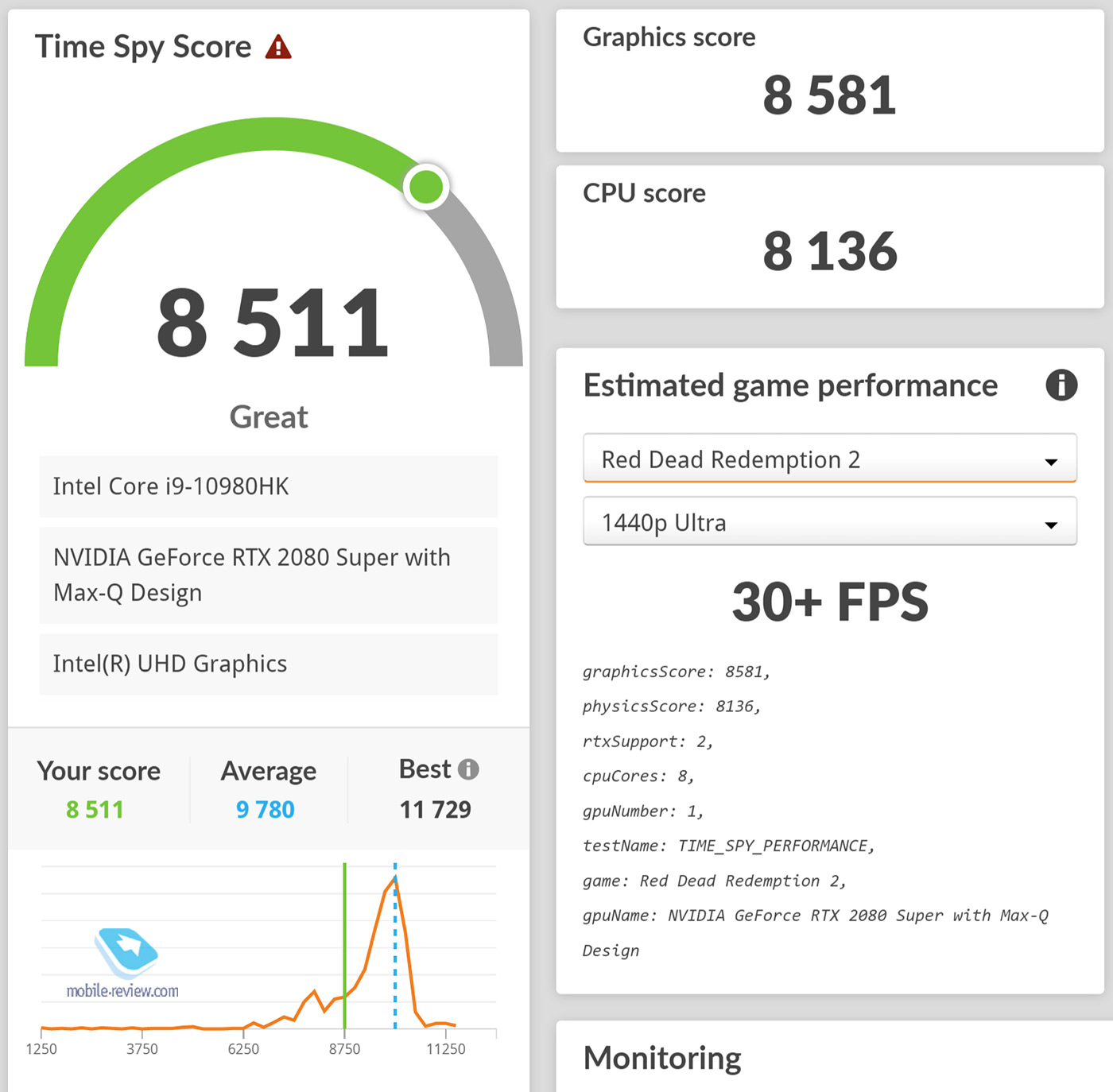

Тут следует обратить внимание на то, что идёт сравнение с картой RTX 2080 Max-Q. У меня на руках был Dell Alienware с RTX 2080 Super Max-Q, который показал гораздо более достойные результаты.

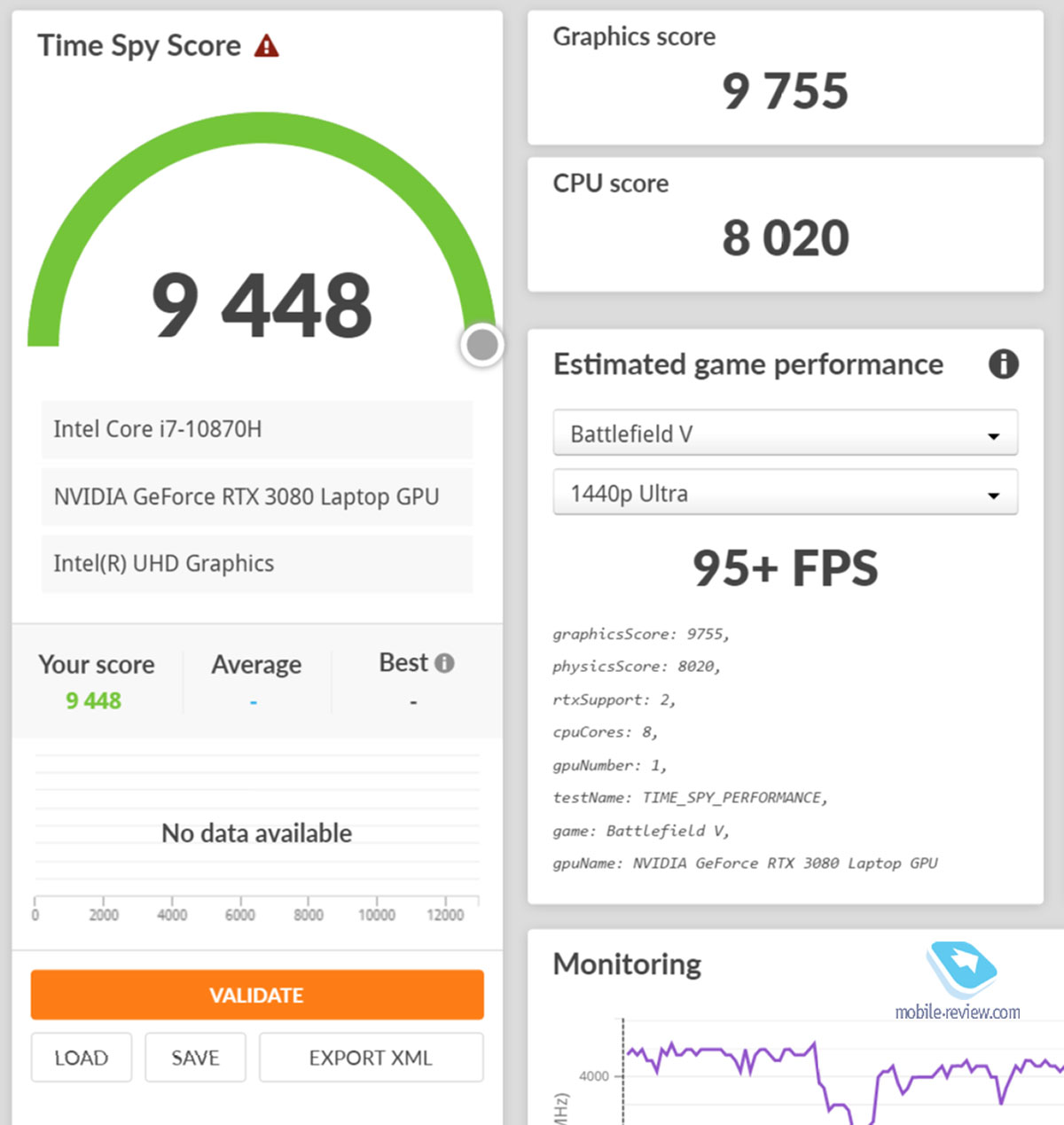

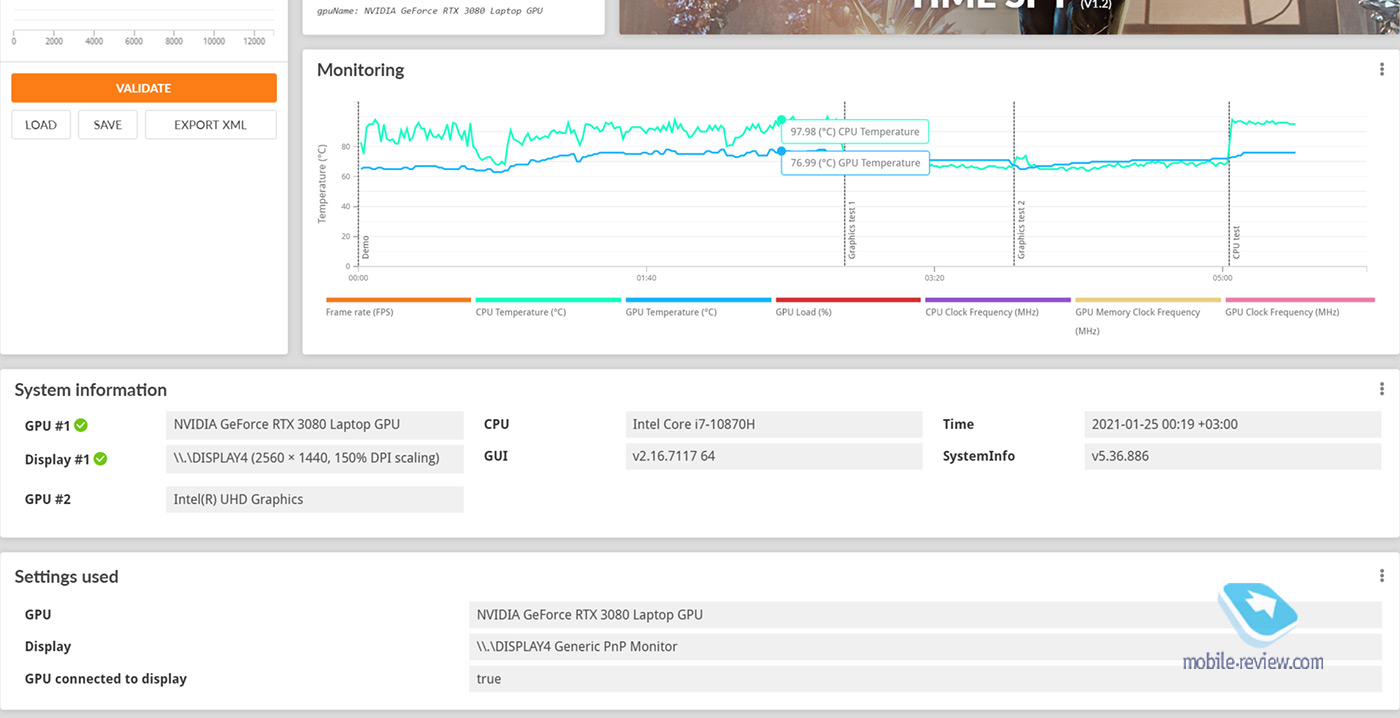

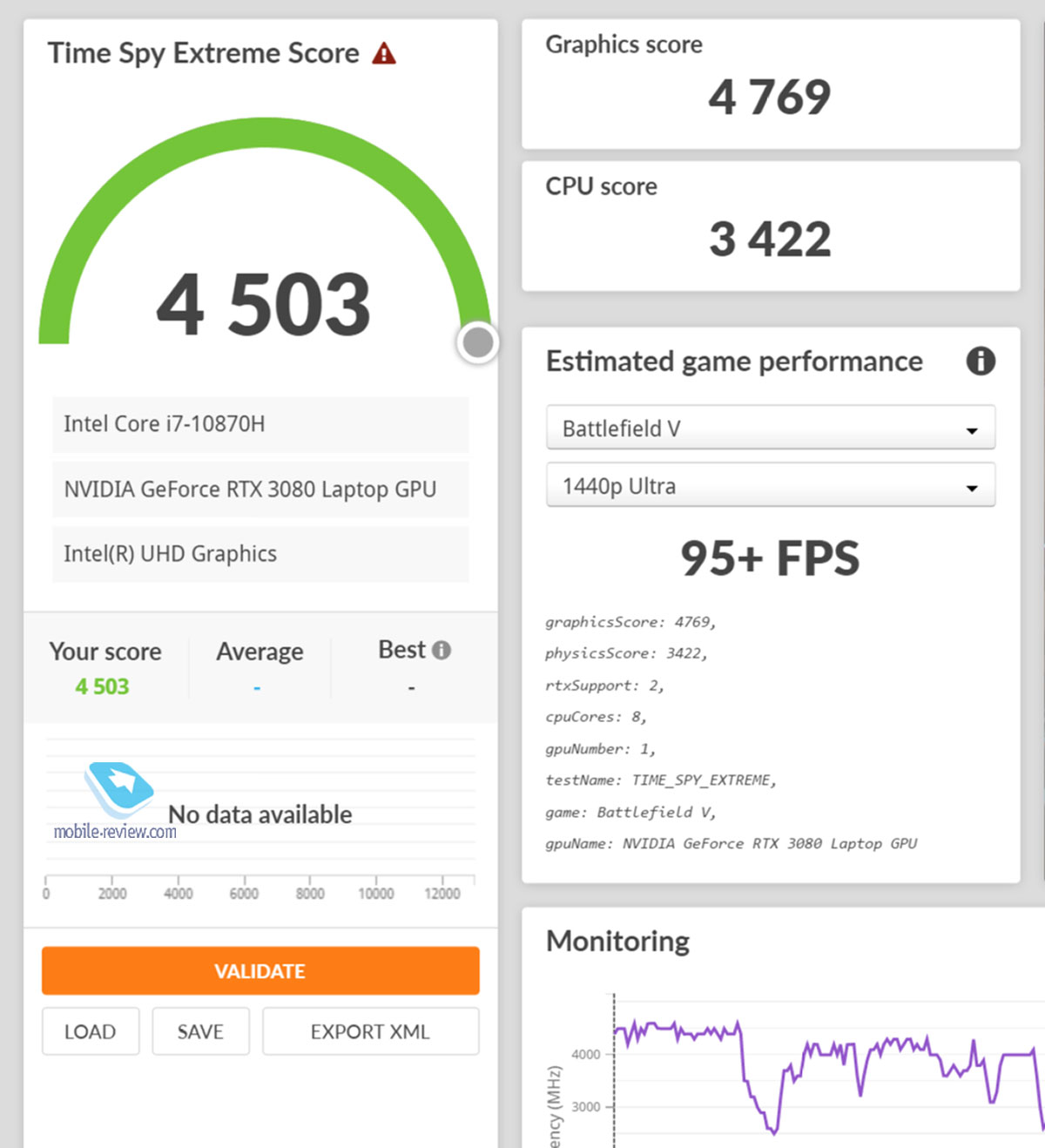

Скриншоты RTX 3080 Laptop GPU.

Не мог не обратить внимания, что новые GPU стали чуть горячее. GPU 20-й серии обычно в тесте показывали температуры в районе 65-70 градусов. RTX 3080 Laptop GPU показывает 76 градусов. Хотя судить по одному ноутбуку, конечно, нельзя.

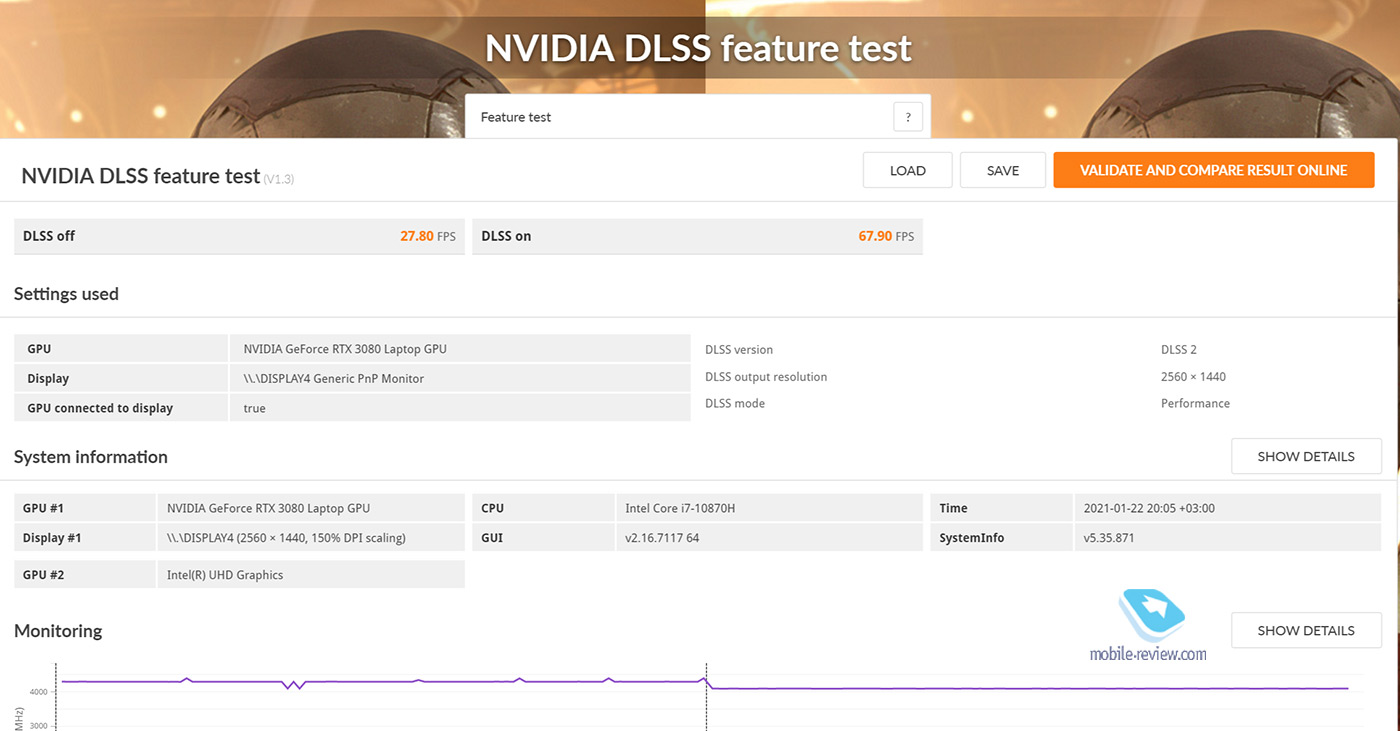

Обратите внимание на DLSS тест. В режиме «DLSS отключен» 27,8 кадра в секунду, в режиме «DLSS включен» – 67,9 fps.

Скриншоты RTX 2080 Super Max-Q.

Заключение

Выводы достаточно простые. Во-первых, начинается новая эпоха гейминга, когда разрешением по умолчанию становится 1440p. На это значение будут ориентироваться разработчики, так что всем владельцам железа, заточенного на Full HD, стоит неспешно начинать задумываться про апгрейд.

Технология DLSS 2.0 творит чудеса. Хочется верить, что все больше разработчиков будут внедрять её, так как она позволяет значительно увеличивать частоту кадров. Например, я запустил Cyberpunk 2077 на ноутбуке с картой RTX 2060 и c DLSS 2.0. В разрешении Full HD он выдал стабильные 60 fps.

RTX 3080 Laptop GPU – очень хорошая видеокарта, которая превращает ноутбук в полноценный игровой компьютер. Если у вас RTX 2080 Super Max-Q, то бежать обновляться не стоит. Можно спокойно подождать ещё пару лет, так как запас прочности у 20-й серии ещё хороший.

Ну и напоследок ложка дёгтя. Игровой ноутбук может быть сколь угодно тонким и легким, но адаптер питания – это по-прежнему кирпич весом под 700 граммов.

Могу предположить, что 30-я серия от Nvidia приведет к перелому, когда, говоря про игровой компьютер, начнут подразумевать ноутбук, а не десктоп.