Что такое bionic в айфоне

О технологии Neural Engine в чипах Apple А-серии

Было опубликовано 20 января 2020 года

Обновлено 21 декабря 2021 года

Приставка «Bionic» к названию процессоров появилось не просто так. На кристалле стал размещаться еще один процессор, который маркетинг Apple назвала «нейронным движком» (Neural Engine).

Он основан на нейронных сетях, которым еще лет 20 назад пророчили лидирующую роль в вычислительной технике.

Позже на помощь Neural Engine пришли блоки AMX, но об этом ниже.

Для чего нужен Neural Engine

Отдельный процессор NPU значительно ускоряет работу таких ресурсоёмких задач как: дополненная реальность (поддерживаемая фреймворком Apple ARKit), машинное обучение и построение нейронных сетей (поддерживаемые фреймворком Apple Core ML).

Технология позволяет Apple реализовать нейронную сеть и машинное обучение более энергоэффективным способом, чем использование основного или графического процессора. CPU и GPU не предназначены для работы с ИИ.

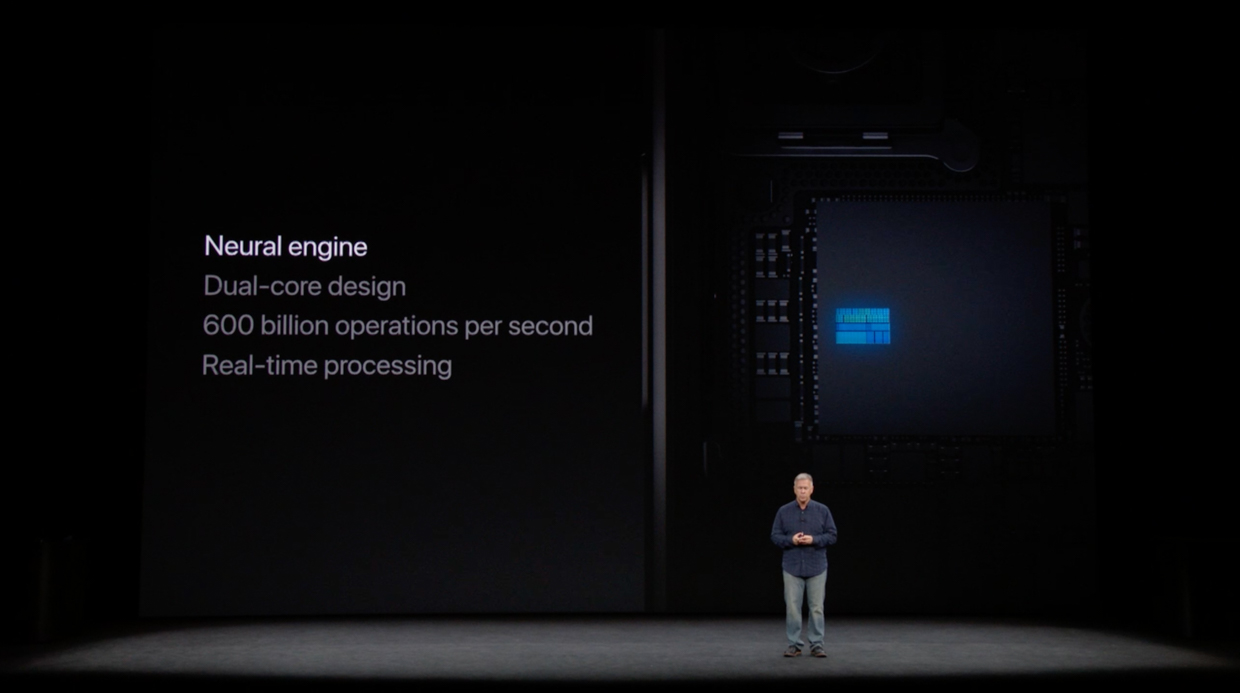

Первое поколение

Впервые нейронный процессор появился в Apple A11 Bionic. Предыдущий чип Apple A10 имел приставку Fusion.

Это первое поколение Neural Engine, которое было встроено чип Apple. В него установлено 2 ядра и оно может выполнять до 600 миллиардов операций в секунду. Появившемуся Face ID он был необходим.

Сторонние приложения не могут использовать нейронный движок этого поколения, что приводит к аналогичной производительности нейронной сети для старых iPhone.

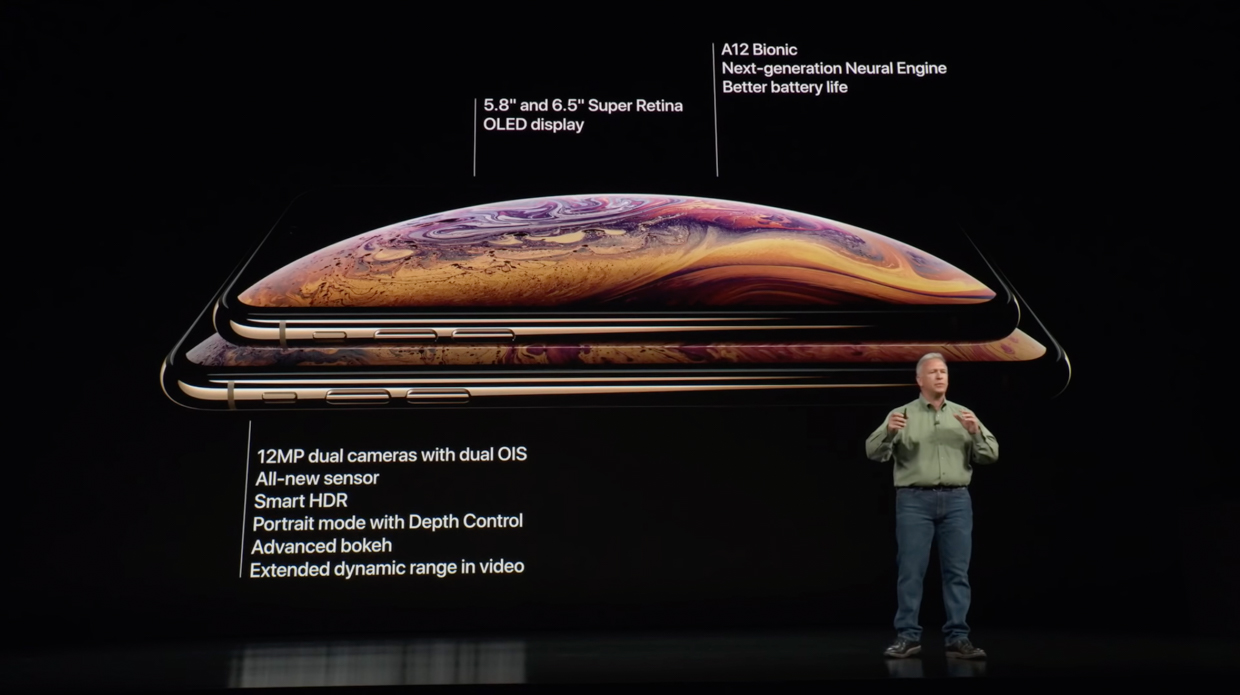

Второе поколение

Следующее поколение сделало достаточно большой рывок по сравнению с предыдущим.

Вторая версия включает в себя “нейронный движок» следующего поколения, который установлен сразу в трех чипах компании Apple.

Это поколение имеет целых 8 ядер и может выполнять до 5 триллионов операций в секунду, что до 9 раз быстрее по сравнению с Apple A11.

Нейронный процессор очень пригодился iPhone XR с его одной основной камерой для портретного режима.

В отличие от Neural Engine 1-го поколения, 2-ое поколение предоставляет доступ для сторонних приложений.

Третье поколение

Третье поколение не сильно продвинулось по сравнению со вторым, но улучшения есть.

Следующий процессор Apple A-серии также включает в себя Neural Engine нового поколения.

Имеет 8 ядер, как и ранее, которые стали на 20% быстрее и на 15% меньше потребляют энергию, а также работают до 6 раз производительнее. Производительность доходит до 6 триллионов операций в секунду.

Apple добавила в 3 – е поколении специальный ускоритель — блоки AMX. Они ориентированы на выполнение ключевых задач машинного обучения.

Присутствует доступ для сторонних приложений.

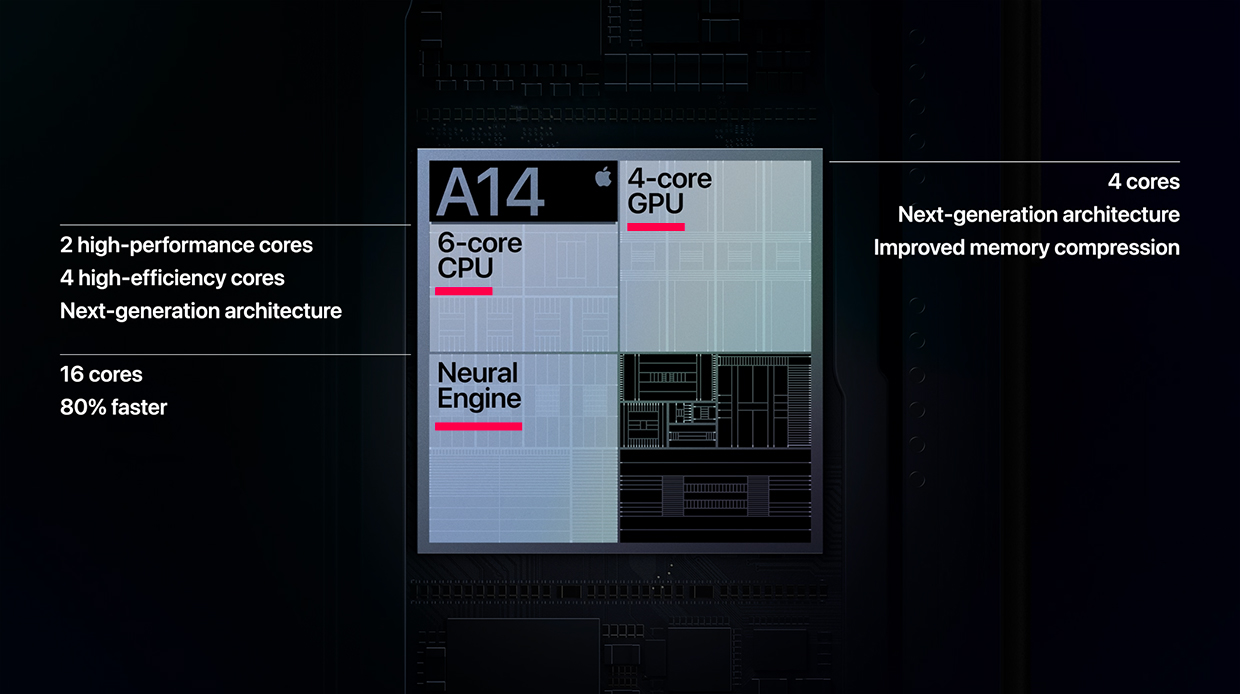

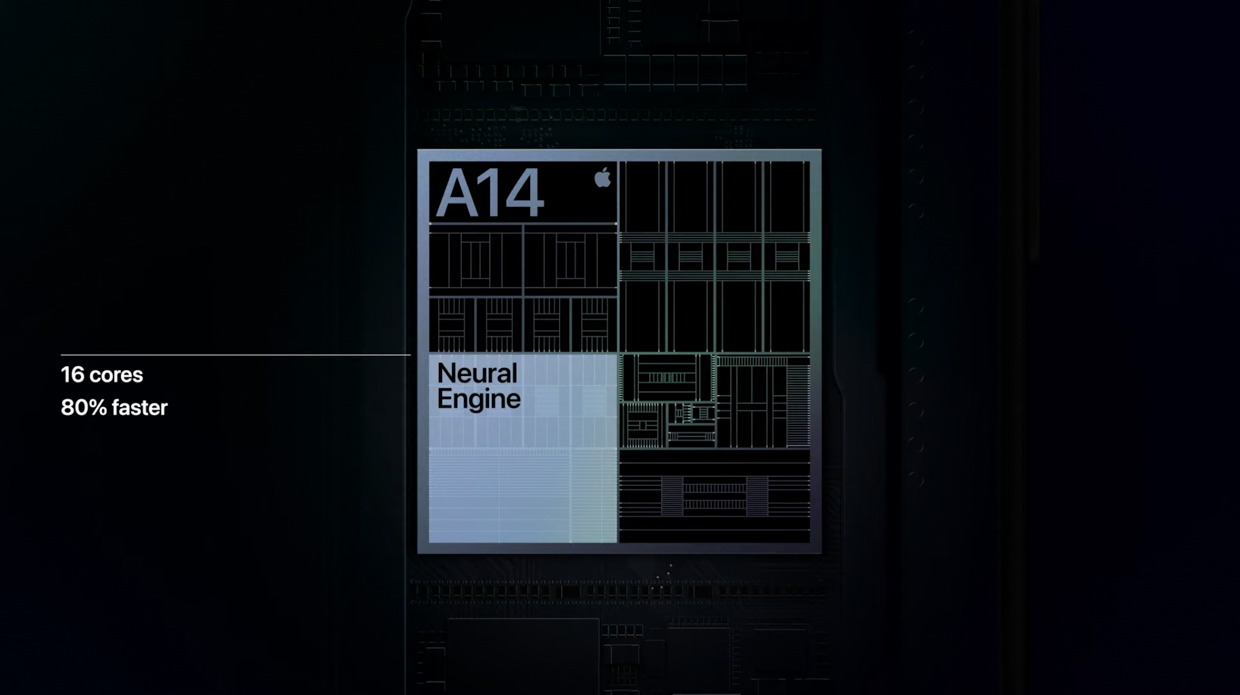

Четвертое поколение

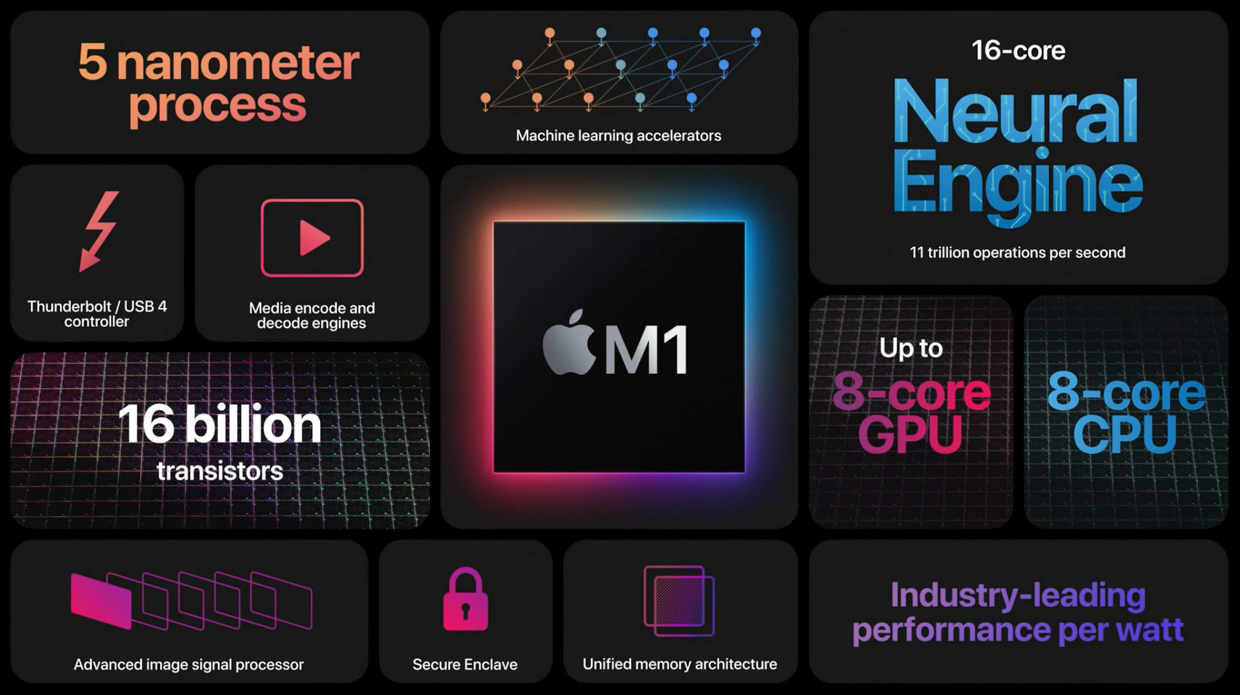

Это поколение стало первым для Mac. Neural Engine этого поколения стал сильно лучше в задачах с использованием ИИ.

Четвертая версия содержит в себе нейронный процессор более нового поколения.

В нем установлено 16 ядер, больше чем ранее в целых два раза. Они выполняют до 11 триллионов операций за 1 секунду, что по утверждениям Apple на 80% быстрее.

В этом поколении нейронный процессор пригодился для функции Deep Fusion для всех камер iPhone 12.

В чипах использующих это поколение, как и в A13, установлен специальный ускоритель — блоки AMX. Они ориентированы на выполнение ключевых задач машинного обучения.

Присутствует доступ для сторонних приложений.

Пятое поколение

Следующее обновление Neural Engine снова не стало большим, после серьезного его улучшения в A14 Bionic, но прирост есть.

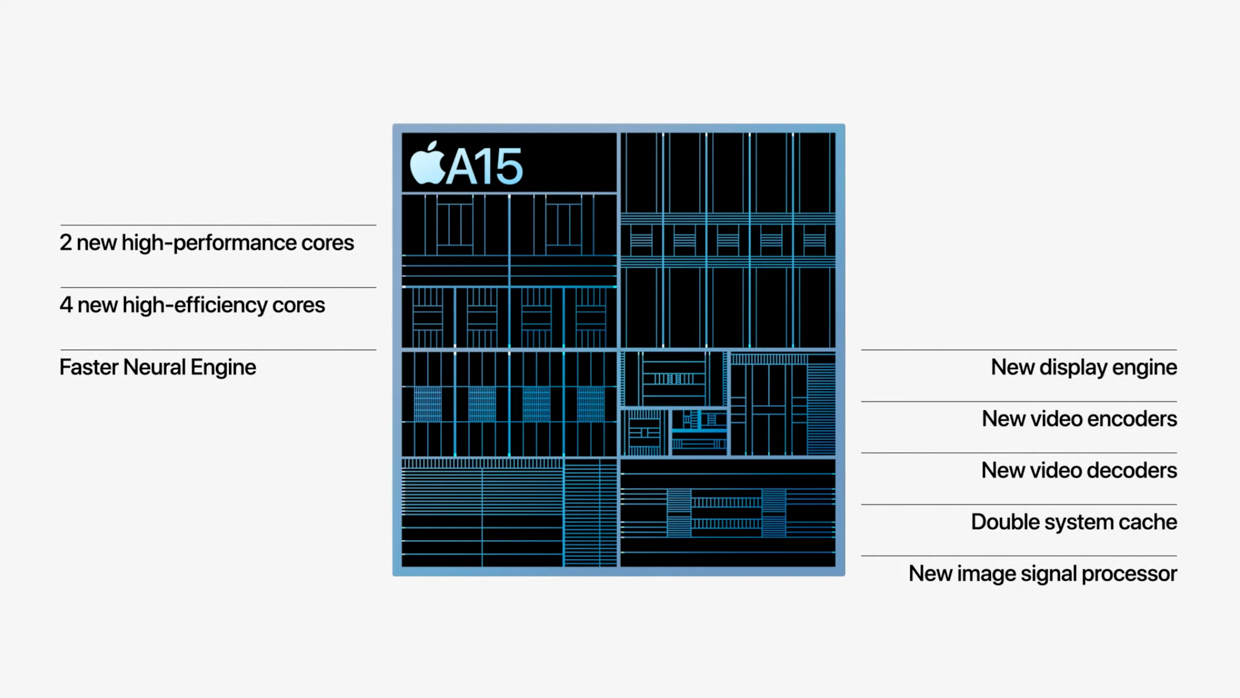

Следующий чип Apple A-серии также включает в себя Neural Engine нового поколения.

В нем установлено как и ранее 16 ядер, здесь ничего нового. Они способны выполнять до 15.8 триллионов операций за 1 секунду, что существенно больше по сравнению с предыдущим поколением.

Новый режим Киноэффект в iPhone 13 активно использует нейронный процессор.

В чипах использующих это поколение, как и в A13, установлен специальный ускоритель — блоки AMX. Они ориентированы на выполнение ключевых задач машинного обучения.

Присутствует доступ для сторонних приложений.

Apple A13 Bionic — процессор iPhone 11. Что в нем особенного

Как обычно, новая “яблочная” система-на-чипе была одним из самых ярких моментов очередного сентябрьского шоу. 18 ядер разного назначения, 7-нанометровый процесс второго поколения, торжество искусственного интеллекта, мощи и экономичности. Это провокационно (конкуренты в бешенстве), вызывающе, очень похоже на правду. Боюсь, что добром это не кончится, но пока Apple удается оставаться первой.

Новый чип iPhone 11, iPhone 11 Pro и iPhone 11 Pro Max

Наглая самоуверенность “зарвавшегося фрукта” порождает волну уничтожающей критики. В чем только не обвиняют системы-на-чипе от Apple. Их де специально затачиваются на достижение рекордных результатов в бенчмарках, результаты достигают не сами чипы, а их вертикальная интеграция с железом и программным обеспечением устройств в которых они используются. Процессоры в “яблочных” SoC (System-on-Chip, или “система-на-чипе”) поражают отсталостью своей архитектуры. Apple A13 Bionic тут не исключение: согласно моде, в процессорах конкурентов уже по три кластера ядер, а у Apple, по старинке, их два. Это очень многообещающий подход, рано или поздно Apple его творчески переосмыслит и использует, пока же требуемый результат достигается и без этого.

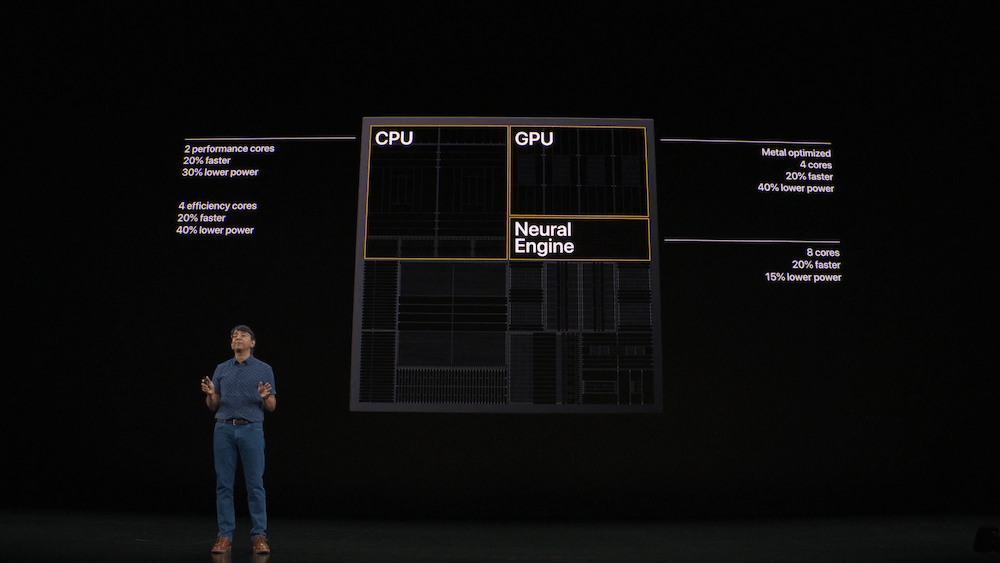

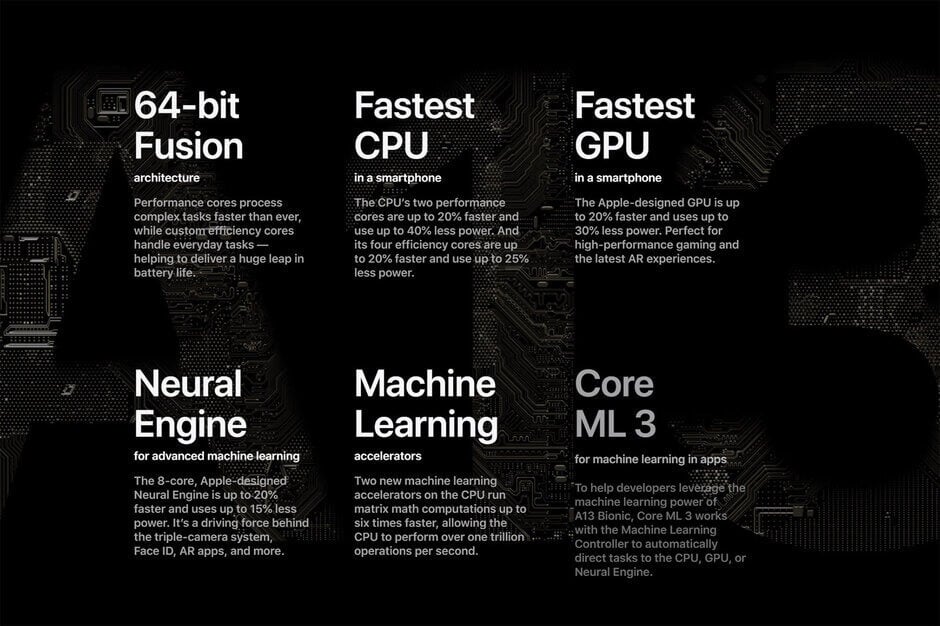

Apple A13 Bionic, по мнению некоторых экспертов, всего лишь незначительный апгрейд A12. Судите сами: те же 6 ядер (два производительных и четыре энергосберегающих) в центральном процессоре, те же 4 ядра “собственной разработки” в графическом и те же 8 в нейронном процессорах. Тот же 7-нанометровый процесс что и раньше – только “второго поколения”. Напоминает Intel с её процессами 14 нм+ и 14 нм++, не правда ли? И вообще ничего нового! Кэйин Дрэнс и Срибалан Сантанам из микро-электронного подразделения Apple зря утруждались, рассказывая об особенностях Apple A13, уважаемые эксперты им не поверили. Их право. Если бы в A13 было что-то нетривиальное – видимо решили они – Apple хранила бы гордое молчание. Некоторые увидели в их разговорчивости зловещий признак надвигающейся катастрофы.

Масла в огонь подлило интервью на процессорные темы, которое дали Wired Фил Шиллер и Ананд Шимпи. Как оказалось, основатель ресурса Anandtech теперь работает в Apple, в том самом микро-электронном подразделении компании о котором, кстати сказать, почти ничего не известно. Впрочем, экспертов удивил вовсе не опрометчивый поступок одного из самых авторитетных обозревателей, а сам факт интервью.

Зловещие предзнаменования

Тот же технологический процесс

Apple A12/A12X Bionic были первыми коммерчески доступными чипами производимым по технологии 7 нм. К сентябрю 2019 года 7-нанометровые чипы утратили статус сенсации. Их выпускала уже не только TSMC – пришло время сделать следующий шаг. Объявив о начале альфа-тестирования технологического процесса 5 нм, TSMC анонсировала экстремальную ультрафиолетовую литографию (EUV), и улучшенный 7-нанометровый процесс N7+. Новый процесс дебютировал в системе-на-чипе Kirin 985, для устройств с Android’ом на борту. Но Apple A12/A12X Bionic, несмотря ни на что, сохранили лидерские позиции. Преимущества и недостатки SoC определяются не только прогрессивностью технологического процесса, но и массой других факторов. Вертикальная интеграция, исповедуемая Apple чуть ли не с первых дней её истории сотворила очередное чудо.

Для производства Apple A13 Bionic используется еще более передовой процесс, N7 Pro, по словам TSMC это намного лучше чем N7+, и что-то совсем другое. В чем это выражается в реальности – неизвестно. В Apple про N7 Pro и про N7+ знают, скорее всего, не хуже чем в TSMC, но реальных железобетонных фактов о том чем они отличаются – нет. Может быть, это всего-лишь новая этикетка на том же самом. Может быть различия между ними столь существенны что TSMC не рискнула обескураживать других покупателей её чипов.

Планы TSMC еще совсем недавно звучали как фантастика. В 2020 компания планировала запустить массовое производство по технологическому процессу 5 нм. Необходимое для этого оборудование было готово к испытаниям, пробные партии 5-нанометровых чипов уже выпускались (для альфа-тестирования у партнеров), и отзывы были положительными, но интереснее всего другое: в 2022 TSMC собиралась начать массовое производство 3-нанометровых чипов. Но тестирование на то и тестирование, чтобы выявлять проблемы, а некоторые из проблем запросто могут оказаться крепкими орешками. Человечество уже и без этого зашло слишком далеко. Скорее всего, так и случилось.

Недавно TSMC сообщила о корректировке планов. В 2020 теперь планируется запуск процесса N6, которого в предыдущих версиях плана не было. Запуск N5 перенесен на более позднее время. Пока, судя по информации от TSMC, с N6 все хорошо, но пока в каком-нибудь из чипов 2020 года этот процесс не будет применен, ни о чем определенном говорить не приходится. И возможны всякие неожиданности. В порядке бреда – что если первой компанией освоившей 6-нанометровый процесс станет Intel? У них самый сильный стимул из всех – речь идет о жизни и смерти. Представьте себе что и как изменилось бы в этом случае.

A13 – это банальный апгрейд A12?

Я уже упоминал об общем в конструкции A12 и A13, повторяться не буду. Apple никогда не занимается изменениями ради изменений, едва ли это порок. Прежде чем что-то изменить, в компании принято тысячи раз подумать, многократно взвесить новые идеи, и в конце концов очень часто новые идеи отправляются в архив. Нарушение традиций приводит, как выяснилось в результате экспериментов с клавиатурой и с Touch Bar, не только к экономии времени, но и к проблемам. Архитектура в A13 консервативная и проверенная временем, из неё (с уверенностью в 100%) можно выжать необходимые технические характеристики, а сосредоточившись на других аспектах добавить в SoC традиционную изюминку.

Центральный процессор состоит из двух “силовых” ядер Lightning, с тактовой частотой в 2,65 ГГц и четырех энергосберегающих ядер Thunder. Lightning – это “молния”, Thunder это “гром”. Кроме того, оба кодовых наименования вызывают некоторые ассоциации, может быть только у меня: Lightning это еще и один из разъёмов используемых в мобильных и в некоторых других устройствах от Apple, Thunder заставляет вспомнить про Thunderbolt. Те кто заявляет об отсутствии изменений в этих ядрах по сравнению с ядрами в A12, видимо, обладает сверхъестественными способностями. Видит лучше чем электронный микроскоп, ориентируется в миллиардах транзисторов, ощущает их жизненный пульс. Занимавшиеся разработкой ядер центрального процессора уверяют что ядра радикально доработаны и улучшены. Центральный процессор стал производительнее, на 20-30%, и экономичнее на 30-40%.

Энергоэффективность на 30 % лучше

Экономичнее, в том числе, и из-за нового трюка, которому обучили SoC в Apple. Любой блок SoC который не используется, может быть обесточен. И быстро (почти моментально) возвращен к жизни как только в нем возникнет необходимость. Экономичнее еще и из-за того что при проектировании процессора были изучены самые используемые приложения в App Store, оказалось что подавляющему их большинству, большую часть времени, мощь “силовых ядер” не требуется. Каким-то магическим способом (вертикальная интеграция – это магия), процессор вычисляет оптимальный режим и включает его. Звучит неуютно, но вроде бы проблем из-за этого не обнаружено.

Один из слайдов с презентации A13

Графический процессор доработан, улучшен, это самый мощный GPU для работы с Metal 2. Нейронный процессор, у которого как и прежде 8 ядер, производительнее в 6 раз. А машинным обучением теперь занимается специальный контроллер. Фил Шиллер назвал одного из бенефициариев (тех, кто получает выгоду) от интеллектуальной составляющей новой SoC – это TTS, Text-to-Speech. Превращение текстов в речь (чтение их вслух). Если вы не в курсе, впервые такая технология на массовом компьютере была показана Apple во время демонстрации первого Mac’а, 35,5 лет назад. В те времена она была несовершенна до предела, с течением времени TTS становились все совершеннее, но искусственную речь отличить от настоящей было элементарно. Вроде бы это обещают исправить – я занимался TTS, и в это не верю. Но – вдруг?

Это вовсе не “банальный апгрейд”. Только два вопроса: будет ли A13X вообще, и каким будет A14? Но всему свое время.

Это продолжение серии про чипы разработанные Apple. Предыдущая часть здесь.

Новости, статьи и анонсы публикаций

Свободное общение и обсуждение материалов

Лонгриды для вас

Apple уже выпустила iOS 15.3 beta 1. Пока нововведение не содержит ни одного функционального нововведения, но его уже могут установить все желающие. Рассказываем, где взять профиль и на что нужно обратить внимание перед обновлением

Apple серьёзно урежет возможности Siri в iOS 15. Теперь вы не сможете совершить голосом банковский перевод, вызвать такси и выполнить ещё 20 команд, которые голосовой ассистент Apple раньше выполнял без каких-либо затруднений

Все пользователи по-разному относятся к покупке новых смартфонов. Одни обновляются каждый год и ходят с топовым iPhone, другие считают, что устройством без проблем можно пользоваться несколько лет. В статье поделились мнением о том, сколько должен служить новый смартфон от Apple.

«Процессоры в “яблочных” SoC (System-on-Chip, или “система-на-чипе”) поражают отсталостью своей архитектуры. Apple A13 Bionic тут не исключение: согласно моде, в процессорах конкурентов уже по три кластера ядер, а у Apple, по старинке, их два» — не, я конечно, ни разу не эксперт в процессорах, но прочитав это сразу вспомнилось, что пока конкуренты множили всякие ядра и мегагерцы, Apple перешла с 32-битного процессора на 64-битный в 5S. И тут все такие: «А что, так можно было?». Поэтому какая разница, сколько там ядер, если конечная цель — производительность? Поэтому пока можно только порадоваться тому, что как сказал автор, «пока же требуемый результат достигается и без этого».

Что такое bionic в айфоне

Как и каждый год, в очередном поколении смартфонов iPhone используется чип собственной разработки Apple. В последние годы эти чипы конкурируют только между собой, поскольку процессоры для Android-смартфонов заметно уступают им по вычислительной мощи.

реклама

Поэтому не стало сюрпризами, что и в этом году применяется процессор Apple A13 Bionic и он только упрочил лидерство над Qualcomm Snapdragon 855 из Android-флагманов. Другого никто и не ждал, поскольку даже прошлогодний Apple A12 Bionic быстрее, чем Snapdragon 855 нынешнего года.

Чего Apple смогла достичь на этот раз, так это не только прироста производительности, но и повышения энергоэффективности. По этой причине линейка смартфонов iPhone 11 обладает рекордной для аппаратов Apple автономностью.

На графике Apple показала, насколько именно быстр А13.

Snapdragon 855, Kirin 980 и Snapdragon 845 заметно уступают. Последний отстаёт от A13 почти в два раза.

Основные характеристики A13 Bionic:

Снижению расхода энергии разработчики уделили самое пристальное внимание. Способствует этому не только второе поколение техпроцесса 7 нм, но и использование четырёх экономичных вычислительных ядер для выполнения большинства каждодневных задач.

Apple говорит, что A13 обладает лучшей среди смартфонов платформой машинного обучения. Главным усовершенствованием стали новые ускорители, которые позволяют выполнять большинство распространённых задач машинного обучения в 6 раз быстрее. Центральный процессор способен производить 1 трлн. операций в секунду.

Имеется контроллер машинного обучения, который позволяет выполнять планировку задач центрального и графического процессора и блока нейронных вычислений. Таким образом выполняется поиск баланса между скоростью и эффективностью. Локально на устройстве может выполняться обработка разговорного языка, классификация изображений на фотографиях и видео, анимация персонажей в приложениях дополненной реальности и многое другое.

Apple говорит о своём преимуществе из-за обладания вертикальным стеком. Это означает, что она сама делает программное обеспечение, аппаратные компоненты и разрабатывает чипы. Всё это наилучшим образом оптимизируется одно под другое.

Для чего в процессорах Apple нужны нейроядра Neural Engine. Третья сила магии iPhone

Начиная с iPhone X, ко всем своим чипам серии A Apple добавляет приставку Bionic. Природная натура этого слова подкрепляется особенным модулем внутри процессора, который называется Neural Engine.

Он состоит из вычислительных блоков, которые помогают iPhone решать задачи, связанные с контекстом.

Перед Neural Engine не стоит задача решить уравнение или отобразить изображение. Это гораздо более тонкая технология, без которой наши смартфоны оставались бы скучными и не умели узнавать нас в лицо.

Ниже расскажу, почему Apple хвалится развитием этого элемента в своих чипах с такой же частотой, как с CPU и GPU. Объясню, зачем именно нужен Neural Engine в том числе в MacBook. А ещё проследим, как нейроядра внутри iPhone стали третьей необходимой силой после вычисления и графики.

Как устроены чипы. CPU и GPU на ПК отдельно, у мобильных вместе

В большинстве ПК, особенно домашних, установлены два главных чипа: CPU и GPU. Они физически находятся в разных частях системного блока и в большинстве случаев созданы разными производителями.

CPU расшифровывается как Central Processing Unit и переводится «центральное вычислительное устройство».

Отвечает за сложные и параллельные вычисления инструкций. Без него компьютер не заработает.

GPU расшифровывается как Graphic Processing Unit и переводится «графическое вычислительное устройство».

Формирует и выводит на монитор визуальную информацию, красиво отображает вычисления процессора и его ОС (операционной системы).

Иногда GPU встраивают прямо в CPU, такой элемент слабее и чаще всего служит временной заменой, чтобы вы видели происходящие внутри компьютера размышления, пока ищете замену дискретной видеокарте. Такие поставляются отдельными модулями.

В компактных устройствах железо работает не только на выдачу мощного результата, но и на сохранение энергии. Важно, чтобы устройство не перегрелось из-за избытка тепла от большой вычислительной нагрузки.

Тут встроенная в CPU графика уже главная, дополнительные процессоры, как правило, либо обрезаны в мощности, либо полноценно работают только при подключении к сети. В смартфонах и планшетах дискретного модуля GPU в принципе не бывает.

Единственный управляющий чип становится чем-то больше обычного CPU. Он превращается в комплексную систему.

И Apple уже добилась в этом лидирующей позиции, поэтому стала интегрировать в процессоры новый тип вычислительных транзисторов.

Есть CPU, есть GPU, а есть Neural Engine

История началась с процессоров для iPhone, в которые постепенно интегрировались новые элементы. Например, Neural Engine. Он ускоряет умные фишки камеры, помогает лучше анализировать голос для Siri и быстрее распознавать людей на ваших фотографиях.

Чуть позже тем же подходом Apple сделала комплексный чип M1 для своих Mac. Внутри него этих ядер ещё больше, и они ежедневно помогают решать те же задачи, что и в iPhone.

В потребительских устройствах для этих целей отдельный чип не ставили, но за ним постепенно закрепляется похожее название.

NPU расшифровывается как Neural Processing Unit и пока никак общепринято не переводится на русский.

Термин постепенно входит в употребление, но каждый производитель называет его по-своему. Будем опираться на формировку Apple, которая звучит как Neural Engine или «Нейронный процессор».

Должно соблюдаться условие: система, которую будут запускать на таком типе процессора, должна быть сначала натренирована на других примерах.

Первый Neural Engine использовали исключительно для Face ID

Apple полностью контролирует производство своих процессоров начиная с iPhone 4 и чипа внутри него A4, которые вышли в 2010 году.

Компания среди первых начала внедрять новые технологии в чипы на мобильных устройствах. Например, переход на 64-битную разрядную систему, интеграцию сопроцессора движения и фотографии, использование минимальных техпроцессов (7 нм, 5 нм).

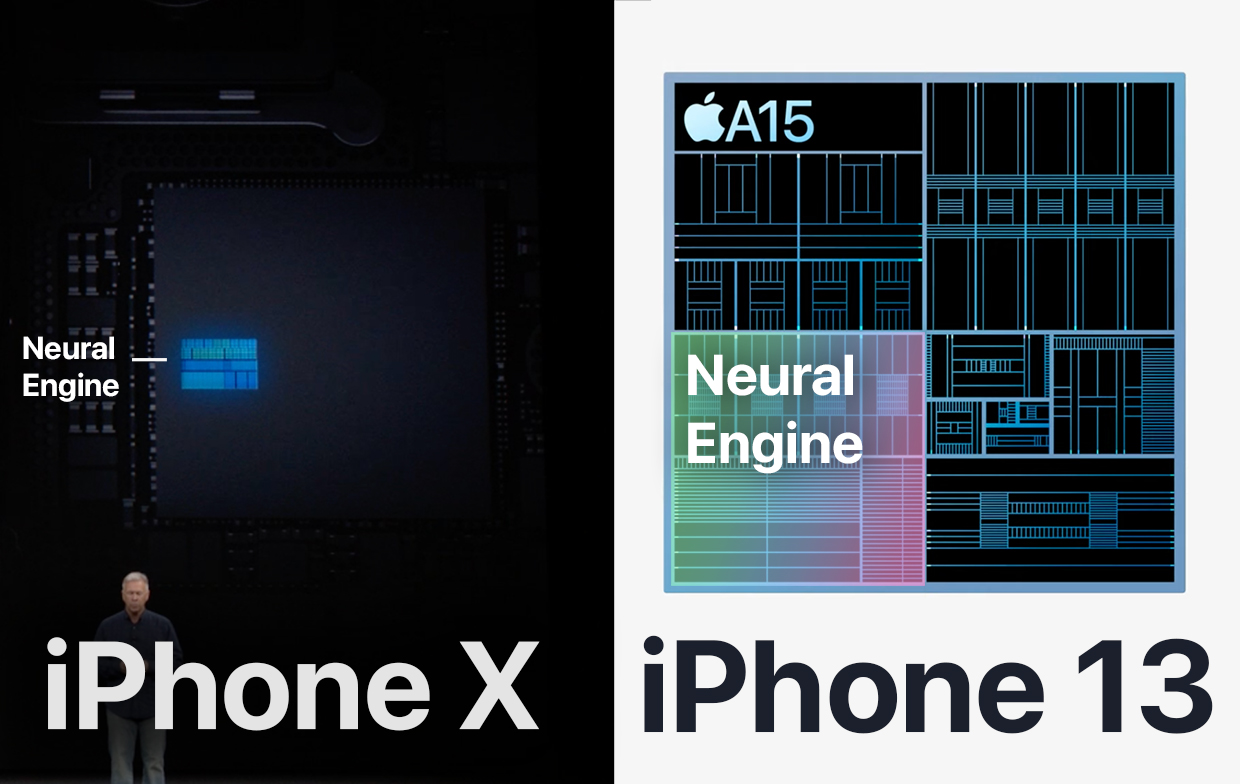

Ключевым стал 2017 год, когда вышел iPhone X. На его презентации впервые пошла речь о небольшом нейросетевом модуле внутри чипа A11, который Apple впервые и до сих пор называет с приставкой Bionic.

Тогда этому маленькому блоку внутри чипа уделили каплю внимания, чтобы рассказать, как он юрко отличает настоящее лицо от искусственной копии в виде театральной маски. Мы узнали о Neural Engine только то, что он способен обучаться по внешнему виду пользователя, и на этом всё.

С каждым новым поколением NPU значительно развивали и обучали новым возможностям.

В 2021 году он помогает искать определённых людей и создавать воспоминания в приложении Фото, анализировать 40 мимических лиц в реальном времени и создавать Киноэффект в iPhone 13.

Эволюция оказалась впечатляющей.

Как развивался Neural Engine в iPhone

Каждая презентация Apple не обходится без упоминания сопроцессора и без указания, насколько выросла его производительность.

Ниже будет полный список iPhone начиная с 2017 года, с описанием возможностей, которые добавляла компания вместе с улучшением Neural Engine и его ядер.

iPhone X

В чипе A11 внутри iPhone X технология появилась первые.

Два ядра, которые служили исключительно для того, чтобы корректно распознавать лица.

Производительность: 600 миллиардов операций в секунду.

iPhone XS и iPhone XR

В A12 внутри iPhone XS и iPhone XR поставили 8 нейроядер, к которым добавили машинное обучение в других приложениях кроме Face ID и «умную вычислительную систему».

Эта система распознаёт тип задачи, поступающей в процессор, и решает, на каких блоках её обрабатывать: в Neural Engine, CPU или GPU.

Машинное обучение улучшило:

• Предложения слов в клавиатуре

• Подборку фотографий в Воспоминаниях

• Вывод полезных мест в Картах

• Адаптацию экрана True Tone

• Поиск снимков в Фото.

Это было нужно для портретного режима с одной камерой на iPhone XR и для AR-эффектов камеры. Например, чтобы накладывать сценический свет или отслеживать движение 50-ти мышц лица во время звонка по Face Time.

Именно благодаря обучению «на ходу» режим портрета из iOS 15 в Face Time доступен на смартфонах с процессором A12 Bionic и новее.

Производительность: 5 триллионов операций в секунду.

iPhone 11 и iPhone 11 Pro

В A13 внутри iPhone 11 установлен Neural Engine снова из 8 ядер.

Тогда блоку повысили мощность на 20% и снизили потребление на 15% за счёт выборочной подачи энергии на разные области A13.

Вместе с машинным обучением NPU улучшил распознавание речи и стал быстрее справляться с трекингом лицевой мимики в реальном времени.

В этот раз в CPU добавили блоки для ускорения машинного обучения, которые стали в 8 раз быстрее проводить матричные вычисления. Вероятно, именно они дали ускорение нейроядрам.

Производительность: 6 триллионов операций в секунду.

iPhone 12 и iPhone 12 Pro

В A14 из iPhone 12 Neural Engine стал в два раза больше и состоял из 16 ядер.

NPU стал на 80% быстрее того, который был установлен в A13.

Эти улучшения помогли внедрить Deep Fusion во все камеры iPhone, включая фронтальную и сверхширокоугольную. Последняя, несмотря на то, что физически была идентична прошлому поколению, стала снимать более чёткие фотографии.

Этот же NPU установлен во все чипы серии M1 от Apple для Mac.

Производительность: 11 триллионов операций в секунду.

iPhone 13 и iPhone 13 Pro

В A15 из iPhone 13 Neural Engine остался с теми же 16 ядрами. Но они стали заметно мощнее. Даже в новых M1 Pro и M1 Max такого нет.

На этой презентации Apple напомнила, что установленные в Neural Engine элементы для машинного обучения работают эффективно за счёт блоков их ускорения в разделе CPU.

На данный момент это самый мощный NPU среди продуктов Apple. Главной его возможностью стала запись видео с глубоким размытием. Режим в приложении Камера в любом из iPhone 13 называется Киноэффект.

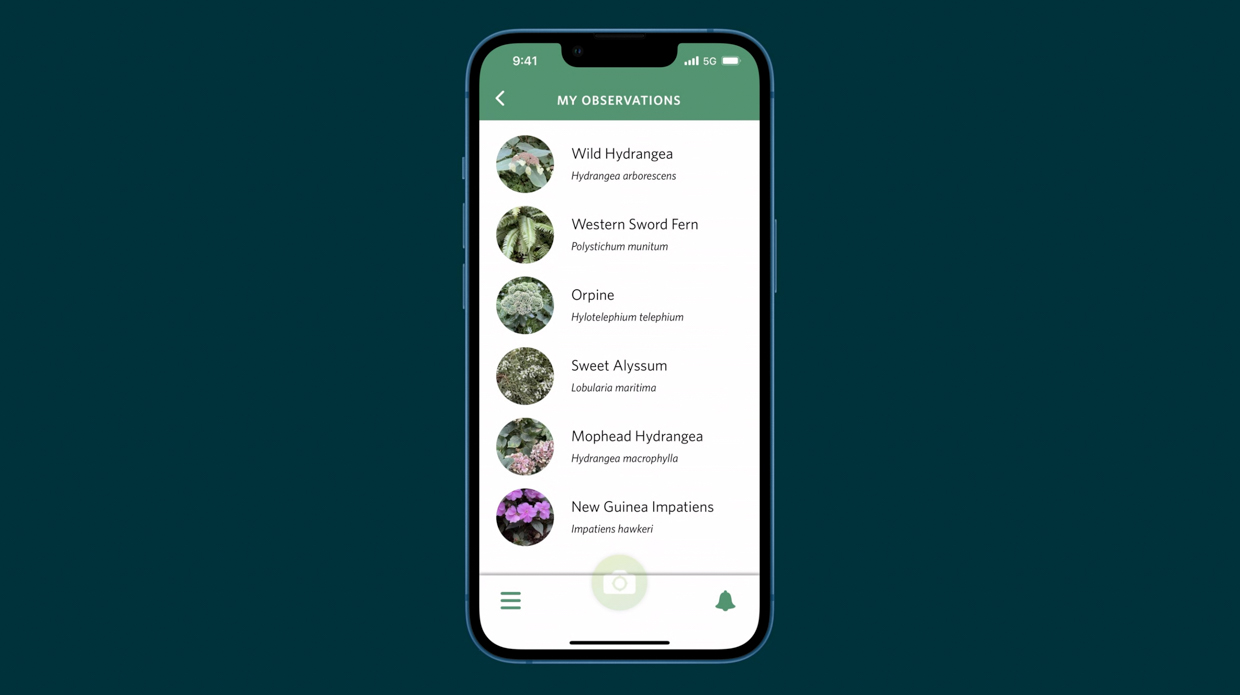

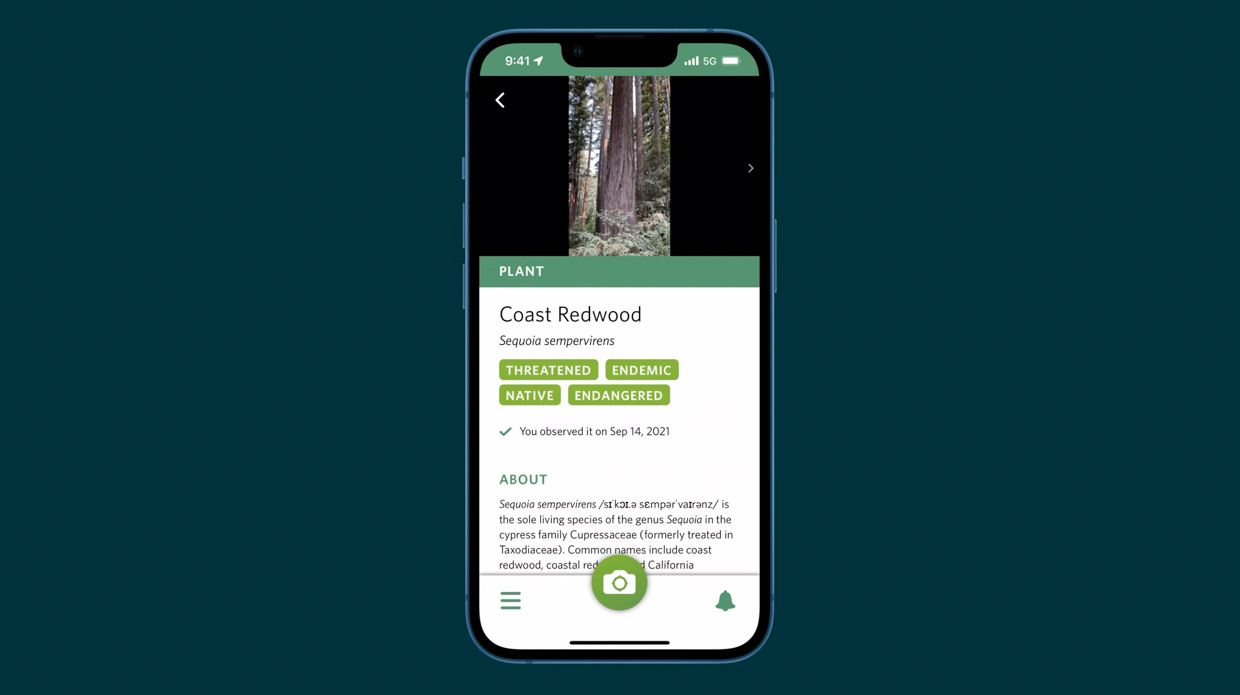

Ещё он помогает Siri распознавать диктовку и корректировать навигатор внутри Apple Maps, делать трекинг предметов в реальном времени, распознавать виды растений и ускорять перевод текста с фотографии в письменный.

Производительность: 15,8 триллионов операций в секунду.

В чём ещё помогает Neural Engine в смартфонах

Многие считают Siri отстающей в развитии по сравнению с другими ассистентами, но на самом деле за этой технологией стоят сложные процессы.

Раньше, когда вы задавали вопрос «Скажи курс доллара к рублю», смартфон записывал данные и отправлял их на сервер с сопроводительными данными вроде обладателя голоса, местоположения, времени суток, чтобы было проще сформулировать ответ. Позже ответ обрабатывался и отправлялся обратно.

Сейчас нейросетевой чип в смартфоне берёт обработку натуральной голосовой модели на себя. Он в реальном времени превращает речь в запрос сам, и в некоторых ситуациях берёт на себя его полную обработку. Он сам понимает, что пользователь хочет узнать и сам же формирует сценарий, по которому будет отвечать.

Например, если вы попросите смартфон сделать сложные расчёты, он справится с ними намного быстрее, чем раньше, потому что сделает это без отправки на сервера. А расчёт начнёт до того, как вы закончите говорить.

Зачем Neural Engine в Mac

Огромный кусок главных функций M1 занимает Neural Engine в правом верхнем углу

Apple постепенно переводит компьютеры Mac на свои процессоры. Год назад, в ноябре 2020-го представили чип M1, в октябре 2021-го к ним добавились M1 Pro и M1 Max.

Несмотря на разницу в производительности CPU и GPU, в каждом из них установлен один и тот же NPU из 16 ядер с мощностью 11 триллионов операций в секунду. То есть он дублирует таковой из A14 внутри iPhone 12.

Выделенные нейроядра в Mac ускоряют процессы в работе профессионалов, завязанные на машинном обучении.

Фотографы могут применить их в Pixelmator Pro, который увеличивает разрешение изображения с помощью процессов машинного обучения, которые активирует Neural Engine.

Видеографы могут использовать функцию умного отслеживания объектов в Final Cut Pro X, чтобы быстрее обрезать видео.

Для разработчиков, учёных и инженеров в их специализированных расчётах и преобразованиях данных, постановки виртуальных экспериментов он тоже будет полезен.

Например, на базе машинного обучения работает платформа TensorFlow. Она помогает внедрять в приложения такие технологии, как распознавание жестов, понимание контекста в естественных вопросах, перенос стиля одного изображения на другое. Чем быстрее будет железо, сделанное для него, тем лучше заработают эти функции.

Часть iPhone, которая делает его iPhone

Apple не устаёт повторять, что её сильная сторона кроется в трепетной связке ПО и железа.

Компания внедряет в свои смартфоны всё больше функций, которые полагаются на заточенные под них ядра. Среди них процессор обработки фото, управления дисплеем, портами и Neural Engine.

«Нейронный движок» помогает смартфону на лету понимать речь, подбирать трогательные Фото в виджете на рабочем столе и выдавать релевантные Воспоминания, отслеживать объекты в кадре Smart HDR, режима портрета и Киноэффекта.

Neural Engine формирует быструю и корректную выдачу данных в Spotlight, распознаёт текст из Камеры, может различать разные виде растений и породы собак.

И в целом он превращает смартфон в устройство, которое с каждым поколением всё лучше распознаёт контекст запроса без подключения к интернету.

Это одна из самых сильных вычислительных сторон iPhone помимо CPU и GPU. И она развивается сумасшедшими темпами из года в год.

Сложно предсказать, на что нейроядра будут способны через 10 лет. Но пока они выполняют свою работу бесшовно и незаметно для пользователя, Apple всё ещё может называть эту технологию магией.