Что секунду что говорите

Стать президентом Америки и потренироваться дома: 17 неизбитых функций Яндекс-колонки

Когда у нас дома появилась Яндекс-колонка с голосовым помощником Алисой, никто толком не знал, что с ней делать

Мы спрашивали у нее погоду, просили поставить таймер, чтобы вовремя достать яйца из кастрюли, и задавали дурацкие вопросы, на которые она смешно отвечала.

Со временем я изучила навыки Алисы, и она оказалась полезной практически в любой ситуации: на вечеринке Алиса скажет незабываемый тост, за завтраком поделится последними новостями, напомнит список продуктов в магазине и займет ребенка обучающими играми, пока родители работают.

Вот несколько ее способностей, которые кажутся мне наиболее полезными. Хотя Алиса живет в разных устройствах, для этой статьи я выбрала только те навыки, которые работают в домашней колонке и не требуют дополнительных устройств — специальных розеток и систем управления умным домом.

Выбирайте, что вам необходимо прямо сейчас:

Алиса может заменить тренера: она расскажет, как сделать упражнение, включит бодрую музыку и отсчитает необходимое количество повторений.

Сложность упражнений и скорость счета можно настраивать, а тренировку выбрать на свой вкус — интервальную, общеукрепляющую или йогу.

Что сказать Алисе: «Запусти навык „Умный счетчик калорий“», «Скажи умному счетчику калорий записать», «Попроси умный счетчик калорий записать»

Навык подойдет тем, кто следит за фигурой: Алиса скажет, сколько калорий в стандартной порции пасты «Карбонара» и салата «Цезарь», и уточнит содержание белков, жиров и углеводов. За завтраком, обедом и ужином можно попросить Алису записать каждое блюдо, а вечером она сообщит, сколько калорий вы съели и рассчитает меню на следующий день.

Алиса знает и точные данные блюд из сетей фастфуда. Можно сказать ей «Бигмак и макфлури» вместо «Бургер и мороженое» и не сомневаться в точности расчетов. Не забудьте записать напитки: Алиса поможет разобраться, какую часть от ежедневного рациона составляет стакан апельсинового сока, а какую — бокал вина.

Что сказать Алисе: «Запусти навык „Расшифровка пищевых добавок“»

Когда нет под рукой таблицы с расшифровкой непонятных ингредиентов вроде E100 или Е260, то поможет Алиса. Она определит добавку по шифру, расскажет, естественное или искусственное у нее происхождение, к какой категории относится вещество — например, краситель, усилитель вкуса или консервант, — и насколько оно безопасно.

Что сказать Алисе: «Запусти навык „Проверка симптомов коронавируса“»

Алиса перечисляет симптомы, которые могут сопровождать болезнь, и просит пользователя оценить, насколько часто они у него проявляются. После этого она анализирует ответы и дает рекомендации: сидеть дома и пить больше теплой жидкости или все-таки вызвать врача.

Что сказать Алисе: «Запусти „Навык тест на алкоголь“», «Сыграем в тест на алкоголь», «Поиграем в тест на алкоголь»

Этот навык поможет оценить свое состояние наутро после вечеринки, когда нужно садиться за руль. Чтобы не рисковать ни жизнью, ни деньгами на оплату штрафов, перед поездкой стоит проконсультироваться с Алисой. Она узнает пол и вес пользователя, спросит, что и в каком количестве человек употреблял накануне, и сообщит, сколько в крови промилле алкоголя.

Если по расчетам алкоголь в крови превышает допустимые нормы, помощник предупредит, на какое время стоит отложить поездку.

Что сказать Алисе: «Запусти навык „Умный шеф“»

Алиса посоветует, что приготовить из тех продуктов, которые уже есть дома, или предложит выбрать блюдо из каталога: перечислит все закуски, горячие блюда или десерты, которые знает, пока пользователь не найдет подходящий вариант.

Сначала Алиса продиктует список продуктов, а потом перейдет к инструкциям. После каждого шага она делает паузу и ждет, пока хозяин спокойно натрет сыр или обжарит лук — и даст команду продолжать.

Что сказать Алисе: «Запусти навык „Список покупок“», «Попроси список покупок добавить молоко и хлеб», «Попроси список покупок показаться»

Чтобы не приходилось несколько раз бегать то за маслом, то за сметаной, попросите Алису стать тем самым листком со списком продуктов. Просто говорите ей, что нужно купить, в любой момент, когда об этом вспомните, а она самостоятельно составит список и синхронизирует его с вашим смартфоном. В магазине запустите Алису в браузере и попросите показать список покупок.

Квесты Алисы напоминают классические квеструмы, только все события происходят в воображении пользователя. Алиса описывает обстоятельства, в которых оказался игрок, и интерьер помещения, откуда нужно выбраться, а пользователь может скомандовать своему персонажу, куда посмотреть, какие предметы взять и как их использовать.

В отличие от квестов в реальности, Алиса не ограничивает игроков во времени: можно останавливаться, когда надоест, а потом продолжать отгадывать загадки с того же места. Историю можно подобрать на любой вкус: игроки могут очутиться в секретной лаборатории или на космическом корабле, в мире литературного произведения или сериала.

Для детей квесты тоже есть: Алиса предложит поиграть за помощников Деда Мороза или стать волшебником, который справится с заданиями, только сочиняя рифмы и составляя верные слова из набора слогов.

Если квесты требуют от игроков мыслить логически, то викторины проверяют эрудицию. Алиса предлагает пользователям посоревноваться в знаниях самых разных фактов: от скорости, с которой солнечный свет достигает поверхности Земли, до того, как звучит по-сербски слово «свинья».

Правила викторин отличаются: в одних пользователю нужно выбрать правильный вариант среди нескольких, которые называет Алиса, а в других — согласиться или не согласиться с утверждением. Можно играть в одиночку, а можно в компании или даже командами: Алиса посчитает, у кого больше правильных ответов, и выберет победителя.

Что сказать Алисе: «Сыграем в „Да, мистер президент“»

В этой игре пользователь садится в кресло президента США: его задача — продержаться у власти четыре года, пройдя сквозь череду неоднозначных ситуаций. На вопросы Алисы игрок должен отвечать только «да» или «нет»: в зависимости от принятого решения будет меняться авторитет президента и бюджет страны.

Зачастую игроку придется выбирать, что дороже — одобрение публики или экономическая стабильность. Впрочем, импичмент ему могут объявить как за растрату, так и в связи с утратой доверия, так что победить в игре будет непросто.

Те, кому удастся справиться с задачей и удержать баланс, могут попробовать свои силы в похожих играх: приквеле «День выборов», где нужно не растерять электорат, и историческом аналоге «Да, милорд», в котором за неверно принятые решения грозит казнь.

Что сказать Алисе: «Запусти навык „Легко сказать“», «Запусти навык „Песни на звуки“», «Запусти навык „Песни для произношения“»

Детям, которые только учатся разговаривать, Алиса поможет освоить сложные звуки: для этого родителям нужно активировать навык-тренажер «Легко сказать», а дальше Алиса поговорит с ребенком уже сама.

Сначала герои — фиксики или звукли — предложат ребенку игровые упражнения: например, поцокать как лошадь, подребезжать как старые автомобили, научиться делать губами трубочку или парус из языка. А потом споют вместе с ребенком песню, которая поможет закрепить звук.

Чтобы упражнения не наскучили, герои развлекают ребенка интересными фактами: например, рассказывают, каким профессиям пригодятся дроны, о которых малыш только что спел куплет, или чем может быть полезна умная колонка.

Что сказать Алисе: «Запусти навык „Игра про репку“», «Запусти навык „Игра репка“»

Алиса может рассказать ребенку обычные сказки, а может — сказку-игру. В основе лежит классический сюжет про репку, только ребенок управляет героями самостоятельно: говорит Алисе, кого позвать на помощь следующим, и она добавляет героя в сюжет.

Сказка может быть сколь угодно длинной, а герои — самыми необычными: например, нам в сказке помогали не только бабка и внучка, но и папа, папина машина и какой-то Лаек. Чтобы сказка закончилась, ребенок должен позвать мышку, а пока он до этого не додумается, у родителей будет время заняться своими делами.

Что сказать Алисе: «Запусти навык „Игра киоск с лимонадом“», «Сыграем в игру „Киоск с лимонадом“»

«Киоск с лимонадом» — экономическая игра, в которой нужно создать свою торговую точку и продержаться на рынке. Настоящие бизнес-кейсы появляются с самого начала: чтобы магазин попал в рейтинг, нужно придумать название, которого еще нет у конкурентов. К заданию придется подойти творчески: все варианты со словом «лимонад» уже, разумеется, заняты.

С каждым шагом игра становится сложнее, но интереснее. Сначала потребуется рассчитать, сколько лимонов может позволить себе киоск на первые 100 рублей и сколько из них получится лимонада. Потом ребенок знакомится с динамическими рыночными отношениями: чтобы не разориться, цену на лимонад придется корректировать в зависимости от погоды и стоимости напитка в других киосках. Еще на цену влияет узнаваемость бренда: чтобы продавать дороже, нужно вкладываться в рекламу. В общем, все как в жизни.

Что сказать Алисе: «Запусти навык „Тотальный диктант“»

Навык понравится тем, кто хочет потренировать грамотность, но впадает в тоску от классических школьных диктантов. Умный помощник прочтет текст писательницы Гузель Яхиной, который она составила специально для «Тотального диктанта» в 2018 году.

Алиса читает текст так, как это сделал бы живой человек в аудитории: сначала произносит предложение полностью, а затем — по словосочетаниям, дважды повторяя каждое из них. Но, в отличие от живого чтеца, Алису можно попросить прочитать одно и то же предложение сколько угодно раз и раздумывать над сложными случаями, никуда не торопясь.

Проверять работу придется самостоятельно на сайте «Тотального диктанта»: кроме самого текста там можно найти разбор допустимых вариантов и посмотреть комментарии по правописанию каждого слова и знака препинания.

Что сказать Алисе: «Запусти навык „Умный пересказ“»

Если школьник не успевает подготовиться к уроку литературы — а в общих чертах узнать, в чем конфликт «Отцов и детей», нужно, то поможет Алиса.

Библиотека у Алисы пока не очень большая, но ключевые тексты в ней есть: например, «Дубровский», «Преступление и наказание», «Гранатовый браслет». Подготовиться к ЕГЭ по литературе таким образом вряд ли получится, а вот для того, чтобы найти аргументы для эссе по русскому языку, такие пересказы подойдут.

Что сказать Алисе: «Запусти навык „Распределительная шляпа“»

Для тех, кому сложно определиться с вузом и специальностью, у Алисы есть собственная «Распределительная шляпа». Только она подбирает факультет не в Хогвартсе, а в российских учебных заведениях.

Чтобы посоветовать подходящие варианты, Алиса спросит у абитуриента, в каком городе он живет и хочет учиться, какие ЕГЭ выбрал и сколько получил баллов на пробных экзаменах, насколько хорошо у него с дисциплиной и нравятся ли ему занятия физкультурой.

Рекомендации Алисы достаточно поверхностны: они не учитывают, какие кружки посещает ребенок и чем любит заниматься в свободное время. Но сузить круг поисков Алиса поможет: она отбракует все вузы, которые точно не подходят по набору экзаменов, а из оставшихся уже можно выбирать подходящий институт и по другим критериям.

Что сказать Алисе: «Запусти навык „Олимпиадный навигатор“», «Запусти навык „Навигатор олимпиад“»

Этот навык пригодится выпускникам, которые хотят поступить в университет по результатам олимпиад, а не по ЕГЭ. Сложность в том, что узнавать об олимпиадах нужно гораздо раньше, чем придет время вступительных экзаменов. А еще потребуется разобраться, какая олимпиада гарантирует победителям поступление или максимальный балл за профильный экзамен, а на какую уже не стоит тратить время.

Неочевидные фичи яндекс станции

Добрый день. У меня яндекс станция появилась 2 года назад и я собрал свои личные наблюдения за яндекс станцией ну и инфраструктурой яндекса как оно взаимодействует в целом. Сподвигло меня то что я купил себе новую Яндекс макс и по сути это для меня конец эпохи старой колонки.

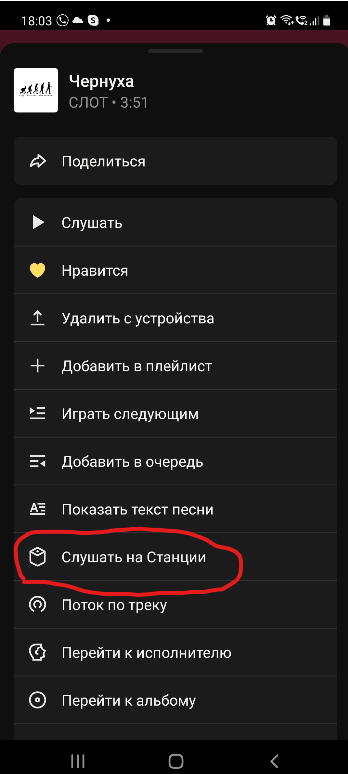

И так приступим. Интеграция яндекс станции с телефоном. Если у вас есть плюс скорее всего вы слушаете музыку на телефоне, но это не точно. когда вы находитесь в 1 сети телефон\станция то появляется возможность отправить через приложение яндекс музыку трек на яндекс станцию

Эта фитча может помочь если вы скажем пришли с улицы и хотите продолжить слушать музыку на станции просто тыкаете последний трек нажимаете слушать на станции и погнали.

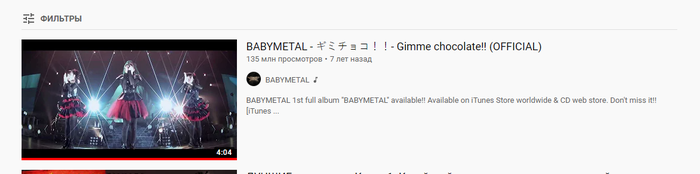

Так же есть интеграция ютуба. Все пользователи яндекс станции понимают что чтобы открыть через голосового помощника видос который называется:

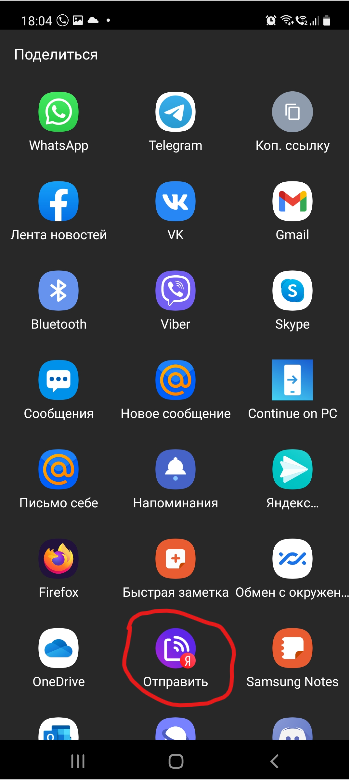

Вам надо попотеть. но есть выход. Заходите на телефоне в ютуб. жамкаете три точки и нажимаете «поделиться» далее в списке ищем:

Вот так вы можете отправить видео с ютуба на яндекс станцию на прямую через телефон.

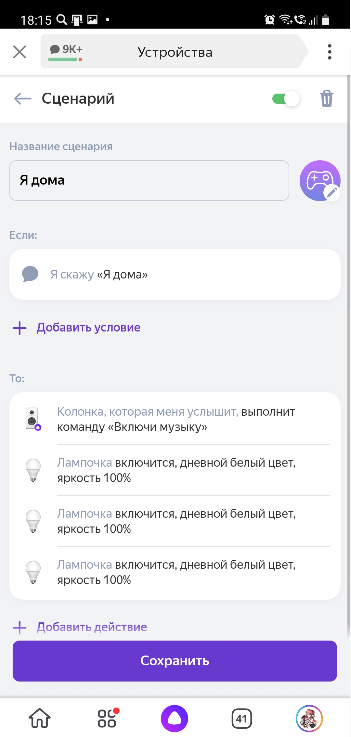

Настройка умного дома. Да у меня есть умные лампочки и можно настроить «сценарий» через приложения яндекс на телефону. Ну вот скажем я настроил сценарий при котором я говорю «Я дома» и у меня включается свет и включается музыка. Так же можно закодировать другие слова и привязать к конкретной фразе. Тоесть условно чтобы при вашей фразе «Алиса, включи это говно» оно будет у вас включать монгольский рок.

Переходим к интеграции с компьютером. Тут на самом деле всё просто. Есть яндекс эфир и яндекс видео вот их можно отправлять с компьютера на устройство.

Видимо с плеером однокласников тоже работает как и с ютубом, не знал но такая фича есть.

Переходим к самому необычному применению яндекс станции. Представим что у вас гараж и там нету интернета но вы хотите поковыряться в машине под музыку. Приносим яндекс станцию она не даёт подключить блютуз по команде потому что ворчит на отсутствие интернета. Беда. Не отчаиваемся. Зажимаем на 3 секунды кнопку активации на колонке, вводим тем самым её в режим поиска вай фая и смотрим на телефоне вай фай сети. Должна появиться вай фай сеть yandex. Подключаемся к ней. Она создана чтобы напрямую передать пароль от вай фая или подключить станцию к устройству но нам не это нужно. Далее мы в 1 сети со станцией и лезем в блютуз. Станция должна начать отображаться как устройство ищущее сопряжение. Подключаем яндекс станцию по блютузу и транслируем свою музыку с телефона через станцию.

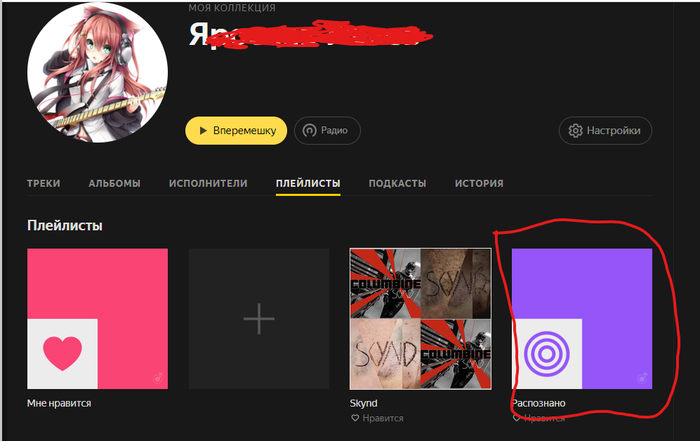

Так же есть одна малопопулярная фитча как включить приложение яндекса активировать голосовой помощник и сказать «скажи какая музыка играет» эта команда аналог шазама. Она не только слушает какой трек играет и пишет об этом. При такой манипуляции Алиса добавляет в вашу учётку на яндекс музыке ещё 1 плейлист «распознанное» и пихает все песни туда. Тоесть вы не только узнали что играет но так же можете в дальнейшем не искать его.

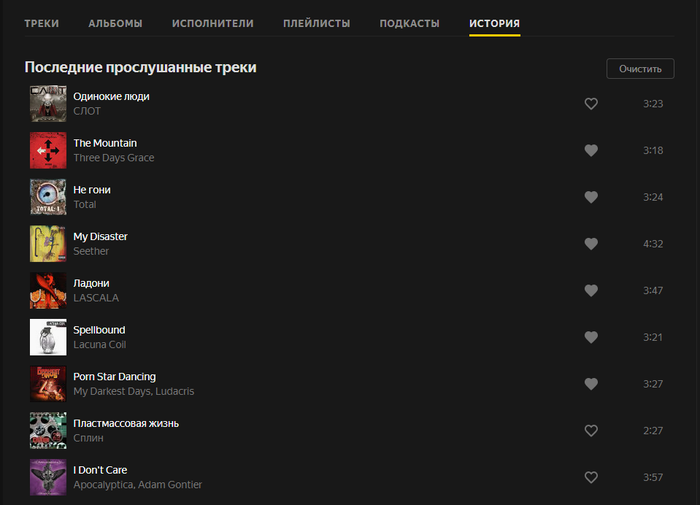

Так же по поводу музыки есть 1 фитча. Предположим вы за рулём играет подборка и вы не успели поставить лайк чтобы потом её послушать. Опять же не отчаиваемся именно в браузерном формате яндекс музыке есть история прослушивания по которой формируются песни Если вы хотите чтобы у вас история пошла с нуля можете её отчистить тогда яндекс не будет вам подкидывать условного Диму Билана которого ставили накануне на пьянке.

Здесь я собрал только свои личные наблюдения за сервисом яндекса и в частности яндекс станции. Решил написать пост на случай малоли кто не знает. Надеюсь пост окажется полезным хоть кому-нибудь. Делитесь и другими возможностями яндекса если такие есть, буду рад почитать.

Шёпот и эмоции в Алисе: история развития голосового синтеза Яндекса

Четыре года назад мы запустили Алису. С самого начала она обладала собственным, узнаваемым голосом. Хотя проблемы тоже были: интонации хромали, эмоции скакали от слова к слову, а омонимы и вовсе ставили синтез в тупик. Алиса звучала пусть и не как робот, но ещё и не как человек.

Исследования показывают, что желание общаться с голосовым помощником напрямую зависит от того, насколько точно он имитирует речь людей. Поэтому мы постоянно работаем над «очеловечениванием» голоса Алисы. С тех пор сменилось несколько поколений нашего голосового синтеза. Мы научились расставлять интонации, отличать «замОк» от «зАмка» и многое другое.

Сейчас мы переходим на следующий уровень: учим Алису управлять эмоциями и стилем своей речи, распознавать шёпот и отвечать на него шёпотом. Казалось бы, что в этом сложного и почему всё это было невозможно ещё несколько лет назад? Вот об этом я и расскажу сегодня сообществу Хабра.

Ранний параметрический синтез: эпоха до Алисы

Мы начали заниматься голосовыми технологиями в 2012 году. Через год родился SpeechKit. Ещё через год мы научились синтезировать голос — возможно, вы помните YaC 2014 и экспериментальный проект Яндекс.Диктовка. С тех пор прогресс не останавливается.

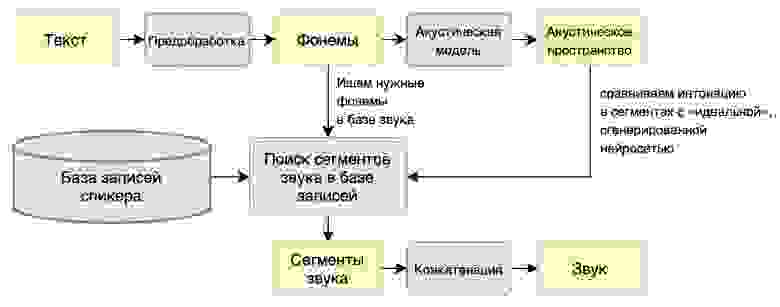

Исторически речевой синтез бывает двух видов: конкатенативный и параметрический. В случае с первым, есть база кусочков звука, размеченных элементами речи — словами или фонемами. Мы собираем предложение из кусочков, конкатенируя (то есть склеивая) звуковые сегменты. Такой метод требует большой базы звука, он очень дорогой и негибкий, зато до пришествия нейросетей давал самое высокое качество.

При параметрическом синтезе базы звука нет — мы рисуем его с нуля. Из-за большого прыжка в размерности end2end работает плохо даже сейчас. Лучше разделить это преобразование на два шага: сначала нарисовать звук в особом параметрическом (отсюда название метода) пространстве, а затем преобразовать параметрическое представление звука в wav-файл.

В 2014 году нейросетевые методы речевого синтеза только зарождались. Тогда качеством правил конкатенативный синтез, но нам в эру SpeechKit было необходимо легковесное решение (для Навигатора), поэтому остановились на простом и дешёвом параметрическом синтезе. Он состоял из двух блоков:

Это стандартная архитектура для любой ранней параметрики со своими достоинствами и недостатками. Главный плюс — для обучения модели нужно мало данных (нам хватило 5-10 часов записей человеческой речи). Можно синтезировать любой произвольный текст, который даже будет плавно звучать. К сожалению, слишком плавно: недостатком раннего параметрического синтеза было то, что полученный голос звучал неестественно. Он был слишком гладким, лишённым интонаций и эмоций, звенел металлом. Люди так не говорят.

Вот как звучал голос при раннем параметрическом синтезе:

Причина неестественности синтезированного голоса кроется в самой архитектуре. У акустической модели мало информации о тексте в целом. Даже рекуррентная нейросеть, которая, казалось бы, умеет запоминать предыдущие состояния, очень быстро забывает их и фактически не учитывает полный текст. При этом человек обычно произносит речь, понимая, что только что прозвучало и что будет дальше по тексту.

Кроме того, человеческая речь мультимодальна — есть несколько способов произнести текст, каждый из которых описывается сигналом и звучит более-менее нормально. Но среднее между этими способами звучит неестественно. Проблема стандартных регрессионных методов глубокого обучения в том, что они ищут одну моду — «хорошее среднее» — и попадают в такие «провалы неестественности». В результате оказывается, что лучше случайно выбрать один из двух способов, чем попасть в среднее между ними.

Впрочем, даже если акустическая модель и смогла бы разобраться в контексте и выдать обогащённое информацией промежуточное состояние, то с ним уже не мог справиться примитивный вокодер. Поэтому мы не остановились и стали искать более совершенные решения.

Конкатенативный синтез: рождение Алисы

В 2016 году мы решили создать Алису — сразу было понятно, что это более амбициозная задача, чем всё, чем занимались раньше. Дело в том, что в отличие от простых TTS-инструментов, голосовой помощник должен звучать человечно, иначе люди просто не станут с ним (или с ней) общаться. Предыдущая архитектура совершенно не подходила. К счастью, был и другой подход. Точнее, даже два.

Тогда как раз набирал обороты нейропараметрический подход, в котором задачу вокодера выполняла сложная нейросетевая модель. Например, появился проект WaveNet на базе свёрточной нейросети, которая могла обходиться и без отдельной акустической модели. На вход можно было загрузить простые лингвистические данные, а на выходе получить приличную речь.

Первым импульсом было пойти именно таким путём, но нейросети были совсем сырые и медленные, поэтому мы не стали их рассматривать как основное решение, а исследовали эту задачу в фоновом режиме. На генерацию секунды речи уходило до пяти минут реального времени. Это очень долго: чтобы использовать синтез в реальном времени, нужно генерировать секунду звука быстрее, чем за секунду.

Что же делать? Если нельзя синтезировать живую речь с нуля, нужно взять крошечные фрагменты речи человека и собрать из них любую произвольную фразу. Напомню, что в этом суть конкатенативного синтеза, который обычно ассоциируется с методом unit selection. Пять лет назад он уже давал наилучшее качество (при достаточном количестве данных) в задачах, где была нужна качественная речь в реальном времени. И здесь мы смогли переиспользовать нейросети нашей старой параметрики. Работало это следующим образом:

Схема конкатенативного синтеза

У такого подхода тоже есть плюсы и минусы. Среди достоинств — более естественное звучание голоса, ведь исходный материал не синтезирован, а записан вживую. Правда, есть и обратная сторона: чем меньше данных, тем более грубо будут звучать места склейки фрагментов. Для шаблонных фраз всё более-менее хорошо, но шаг влево или вправо — и вы замечаете склейку. Поэтому нужно очень много исходного материала, а это требует многих часов записи голоса диктора. К примеру, в первые несколько лет работы над Алисой нам пришлось записать несколько десятков часов. Это несколько месяцев непрерывной работы с актрисой Татьяной Шитовой в студии.

При этом нужно не просто «прочитать текст по листочку». Чем более нейтрально будет звучать голос, тем лучше. Обычно от актёров ждут эмоциональности, проявления темперамента в своей речи. У нас ровно обратная задача, потому что нужны универсальные «кубики» для создания произвольных фраз.

Вот характерный пример работы синтеза:

В этом главный недостаток метода unit selection: несмотря на все усилия, фрагменты речи не будут идеально соответствовать друг другу по эмоциям и стилю. Из-за этого сгенерированная речь Алисы постоянно «переключалась» между ними. На коротких фразах это не всегда заметно, но если хотите услышать произвольный ответ длиной хотя бы в пару предложений (например, быстрый ответ из поиска), то недостатки подхода становятся очевидны.

В общем, unit selection перестал нас устраивать и нужно было развиваться дальше.

Иногда они возвращаются: опять параметрический синтез

В результате мы вернулись к архитектуре из двух последовательных блоков: акустическая модель и вокодер. Правда, на более низком уровне обновилось примерно всё.

1. Акустическая модель

В отличие от старой параметрики, новую модель мы построили на основе seq2seq-подхода с механизмом внимания.

Помните проблему с потерей контекста в нашей ранней параметрике? Если нет нормального контекста, то нет и нормальной интонации в речи. Решение пришло из машинного перевода.

Дело в том, что в машинном переводе как раз возникает проблема глобального контекста — смысл слов в разных языках может задаваться разным порядком или вообще разными структурами, поэтому порой для корректного перевода предложения нужно увидеть его целиком. Для решения этой задачи исследователи предложили механизм внимания — идея в том, чтобы рассмотреть всё предложение разом, но сфокусироваться (через softmax-слой) на небольшом числе «важных» токенов.

При генерации каждого нового выходного токена нейросеть смотрит на обработанные токены (фонемы для речевого синтеза или символы языка для перевода) входа и «решает», насколько каждый из них важен на этом шаге. Оценив важность, сеть учитывает её при агрегировании результатов и получает информацию для генерации очередного токена выхода.

Таким образом нейросеть может заглянуть в любой элемент входа на любом шаге и при этом не перегружается информацией, поскольку фокусируется на небольшом количестве входных токенов. Для синтеза важна подобная глобальность, так как интонация сама по себе глобальна и нужно «видеть» всё предложение, чтобы правильно его проинтонировать.

На тот момент для синтеза была хорошая seq2seq-архитектура Tacotron 2 — она и легла в основу нашей акустической модели.

2. Мел-спектрограмма

Параметрическое пространство можно сжать разными способами. Более сжатые представления лучше работают с примитивными акустическими моделями и вокодерами — там меньше возможностей для ошибок. Более полные представления позволяют лучше восстановить wav, но их генерация — сложная задача для акустической модели. Кроме того, восстановление из таких представлений у детерминированных вокодеров не очень качественное из-за их нестабильности. С появлением нейросетевых вокодеров сложность промежуточного пространства стала расти и сейчас в индустрии одним из стандартов стала мел-спектрограмма.

Она отличается от обычного распределения частоты звука по времени тем, что частоты переводятся в особую мел-частоту звука. Другими словами, мел-спектрограмма — это спектрограмма, в которой частота звука выражена в мелах, а не герцах. Мелы пришли из музыкальной акустики, а их название — это просто сокращение слова «мелодия».

Строение улитки уха (из Википедии)

Эта шкала не линейная и основана на том, что человеческое ухо по-разному воспринимает звук различной частоты. Вспомните строение улитки в ухе: это просто канал, закрученный по спирали. Высокочастотный звук не может «повернуть» по спирали, поэтому воспринимается достаточно короткой частью слуховых рецепторов. Низкочастотный же звук проходит вглубь. Поэтому люди хорошо различают низкочастотные звуки, но высокочастотные сливаются.

Мел-спектрограмма как раз позволяет представить звук, акцентируясь на той части спектра, которая значимо различается слухом. Это полезно, потому что мы генерируем звук именно для человека, а не для машины.

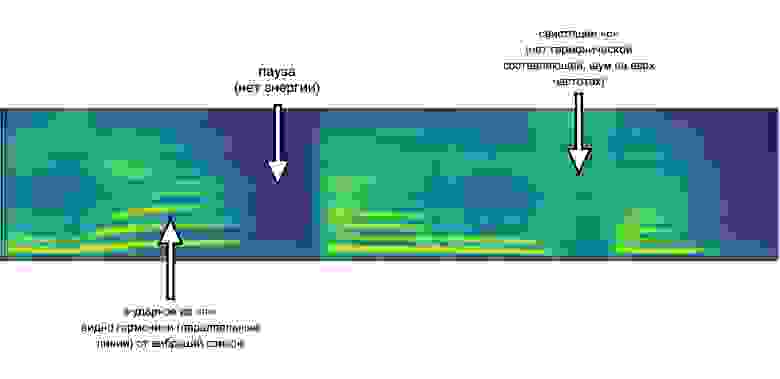

Вот как выглядит мел-спектрограмма синтеза текста «Я — Алиса»:

У мел-спектрограммы по одному измерению [X на рисунке выше] — время, по другому [Y] — частота, а значение [яркость на рисунке] — мощность сигнала на заданной частоте в определенный момент времени. Проще говоря, эта штуковина показывает, какое распределение по мощностям было у различных частот звука в конкретный момент. Мел-спектрограмма непрерывна, то есть с ней можно работать как с изображением.

А так звучит результат синтеза:

3. Новый вокодер

Вероятно, вы уже догадались, что мы перешли к использованию нового нейросетевого вокодера. Именно он в реальном времени превращает мел-спектрограмму в голос. Наиболее близкий аналог нашего первого решения на основе нейросетей, которое вышло в 2018 году — модель WaveGlow.

Архитектура WaveGlow основана на генеративных потоках — довольно изящном методе создания генеративных сетей, впервые предложенном в статье про генерацию лиц. Сеть обучается конвертировать случайный шум и мел-спектрограмму на входе в осмысленный wav-сэмпл. За счёт случайного шума на входе обеспечивается выбор случайной wav-ки — одной из множества соответствующих мел-спектрограмме. Как я объяснил выше, в домене речи такой случайный выбор будет лучше детерминированного среднего по всем возможным wav-кам.

В отличие от WaveNet, WaveGlow не авторегрессионен, то есть не требует для генерации нового wav-сэмпла знания предыдущих. Его параллельная свёрточная архитектура хорошо ложится на вычислительную модель видеокарты, позволяя за одну секунду работы генерировать несколько сотен секунд звука.

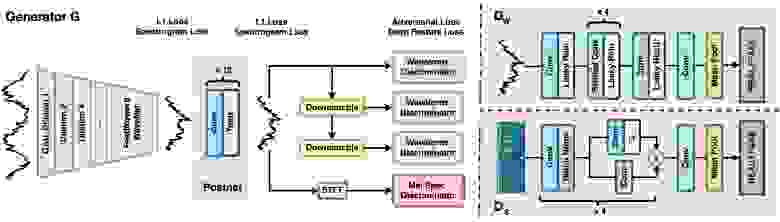

Затем вышла модель HiFi-GAN, которая сильно выигрывала по качеству у других решений. HiFi-GAN — доработка генеративно-состязательной сети MelGAN, создающей wav-сэмплы на основе мел-спектрограммы.

Главное отличие, за счёт которого HiFi-GAN обеспечивает гораздо лучшее качество, заключается в наборе подсетей-дискриминаторов. Они валидируют натуральность звука, смотря на сэмплы с различными периодами и на различном масштабе. Как и WaveGlow, HiFi-GAN не имеет авторегрессионной зависимости и хорошо параллелится, при этом новая сеть намного легковеснее, что позволило при реализации ещё больше повысить скорость синтеза. Кроме того, оказалось, что HiFi-GAN лучше работает на экспрессивной речи, что в дальнейшем позволило запустить эмоциональный синтез — об этом подробно расскажу чуть позже. Летом 2021 года мы полностью перешли на HiFi-GAN.

Схема HiFi-GAN из статьи авторов модели

Комбинация этих трёх компонентов позволила вернуться к параметрическому синтезу голоса, который звучал плавно и качественно, требовал меньше данных и давал больше возможностей в кастомизации и изменении стиля голоса.

Параллельно мы работали над улучшением отдельных элементов синтеза:

С чувством, толком, расстановкой: стили голоса Алисы

Один и тот же текст можно произнести десятком разных способов, при этом сам исходный текст, как правило, никаких подсказок не содержит. Если отправить такой текст в акустическую модель без дополнительных меток и обучить её на достаточно богатом различными стилями и интонациями корпусе, то модель сойдёт с ума — либо переусреднит всё к металлическому «голосу робота», либо начнёт генерировать случайный стиль на каждое предложение. Это и произошло с Алисой: в начале она воспроизводила рандомные стили в разговоре. Казалось, что у неё менялось настроение в каждом предложении.

Вот пример записи с явными перебоями в стилях:

Чтобы решить проблему, мы добавили в акустическую модель стили: в процессе обучения нейросети специально ввели «утечку». Суть в том, что через очень lossy-пространство (всего 16 чисел на всё предложение) разрешаем сетке посмотреть на ответ — истинную мел-спектрограмму, которую ей и нужно предсказать на обучении. За счёт такой «шпаргалки» сеть не пытается выдумывать непредсказуемую по тексту компоненту, а для другой информации не хватит размерности шпаргалки.

На инференсе мы генерируем стилевую подсказку, похожую на те, что были в обучающем сете. Это можно делать, взяв готовый стиль из обучающего примера или обучив специальную подсеть генерировать стили по тексту.

Если эту подсеть обучить на особом подмножестве примеров, можно получить специальные стили для, скажем, мягкого или дружелюбного голоса. Или резкого и холодного. Или относительно нейтрального. Чтобы определиться со стилем по умолчанию, мы устроили турнир, где судьями выступали пользователи Толоки. Там не было разметки, мы просто нашли кластеры стилей и провели между ними соревнование. Победил кластер с очень мягкой и приятной интонацией.

Дальше началось самое интересное. Мы взяли образцы синтезированной «мягкой» речи Алисы и фрагменты речи актрисы Татьяны Шитовой, которые относились к более резкому стилю. Затем эти образцы с одним и тем же текстом протестировали вслепую на толокерах. Оказалось, что люди выбирают синтезированный вариант Алисы, несмотря на более плохое качество по сравнению с реальной речью человека. В принципе, этого можно было ожидать: уверен, многие предпочтут более ласковый разговор по телефону (то есть с потерей в качестве) живому, но холодному общению.

К примеру, так звучал резкий голос:

Результаты турниров позволили нам выделить во всем обучающем датасете данные, которые относятся к стилю-победителю, и использовать для обучения только их. Благодаря этому Алиса по умолчанию стала говорить более мягким и дружелюбным голосом.

Этот пример показывает, что с точки зрения восприятия важно работать не только над качеством синтеза, но и над стилем речи. После этого оставалось только обогатить Алису новыми эмоциями.

Бодрая или спокойная: управляем эмоциями Алисы

Когда вы включаете утреннее шоу Алисы или запускаете автоматический перевод лекции на YouTube, то слышите разные голоса — бодрый в первом случае и более флегматичный в другом. Эту разницу сложно описать словами, но она интуитивно понятна — люди хорошо умеют распознавать эмоции и произносить один и тот же текст с разной эмоциональной окраской. Мы обучили этому навыку Алису с помощью той же разметки подсказок, которую применили для стилей.

У языка есть интересное свойство — просодия, или набор элементов, которые не выражаются словами. Это особенности произношения, интенсивность, придыхание и так далее. Один текст можно произнести со множеством смыслов. Как и в случае со стилями речи, можно, например, выделить кластеры «веселая Алиса», «злая Алиса» и так далее.

Поскольку стилевой механизм отделяет просодию («как говорим») от артикуляции («что говорим»), то новую эмоцию можно получить буквально из пары часов данных. По сути, нейросети нужно только выучить стиль, а информацию о том, как читать сочетания фонем, она возьмёт из остального корпуса.

Прямо сейчас доступны три эмоции. Например, часть пользователей утреннего шоу Алисы слышат бодрую эмоцию. Кроме того, её можно услышать, спросив Алису «Кем ты работаешь?» или «Какую музыку ты любишь?». Флегматичная эмоция пригодилась для перевода видео — оказалось, что голос по умолчанию слишком игривый для этой задачи. Наконец, радостная эмоция нужна для ответов Алисы на специфические запросы вроде «Давай дружить» и «Орёл или решка?». Ещё есть негативная эмоция, которую пока не знаем, как использовать — сложно представить ситуацию, когда людям понравится, что на них ругается робот.

Первый корпус эмоций мы записали ещё при WaveGlow, но результат нас не устроил и выкатывать его не стали. С переходом на HiFi-GAN стало понятно, что он хорошо работает с эмоциями, это позволило запустить полноценный эмоциональный синтез.

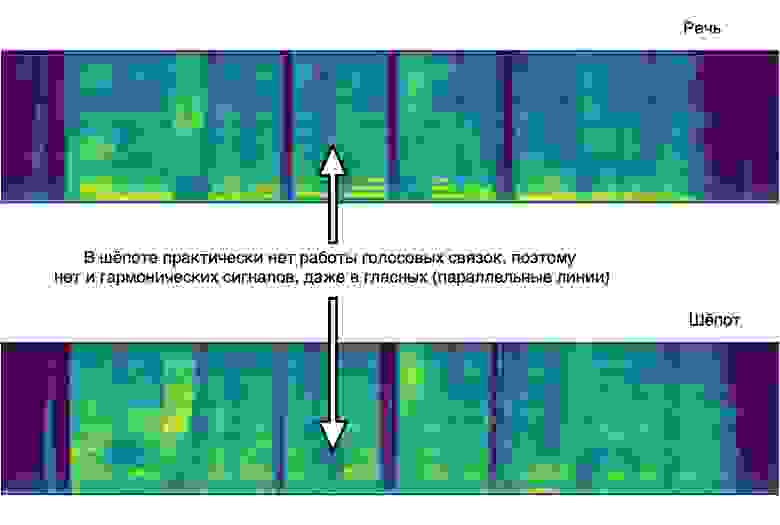

Наконец, мы решили внедрить шёпот. Когда люди обращаются к Алисе шёпотом, она должна и отвечать шёпотом — это делает её человечнее. При этом шёпот — не просто тихая речь, там слова произносятся без использования голосовых связок. Спектр звука получается совсем другим.

С одной стороны, это упрощает детекцию шёпота: по «картинке» мел-спектрограммы можно понять, где заканчивается обычная речь и начинается шепот. С другой стороны, это усложняет синтез шёпота: привычные механизмы обработки и подготовки речи перестают работать. Поэтому шёпотный синтез нельзя получить детерминированным преобразованием сигнала из речи.

Так выглядят мел-спектрограммы обычной речи и шёпота при произнесении одной и той же фразы:

Так звучит обычная речь:

Сначала мы научили Алису понимать шёпот. Для этого обучили нейросеть различать спектры звука для обычного голоса и шёпота. Система смотрит на спектр звука и решает, когда говорят шёпотом, а когда — голосом.

В процессе обучения оказалось, что спектры шёпота и речи курильщиков похожи, так что пришлось научить нейросеть их различать. Для этого собрали больше пограничных данных с речью курильщиков и простуженных людей и донастроили нейросеть на них.

Чтобы научить Алису говорить шёпотом, мы записали несколько часов шёпота речи в исполнении Татьяны Шитовой. Сложности начались уже на предобработке данных: наш VAD (детектор тишины в речи) сломался на шёпотных гласных — трудно отличить сказанное шёпотом «а!» от обычного громкого вздоха. Починить его удалось, только совместив признаки энергии сигнала и данные от распознавания речи, при этом под шёпот конструкцию пришлось калибровать отдельно.

Затем записанные данные добавили в обучающий корпус акустической модели. Мы решили рассматривать шёпот как еще один «стиль» речи или, в терминах нашего синтеза, «эмоцию». Добавив данные в трейнсет, мы дали акустической модели на вход дополнительную информацию — шёпот или эмоцию она сейчас проигрывает. По этому входу модель научилась по команде пользователя переключаться между генерацией речи и шёпота.

Сгенерированный шёпот по качеству не отличался от обычной речи. По нашей метрике PSER (Pronunciation Sentence Error Rate — средняя доля ошибок произношения в предложении) он оказался даже лучше. Оказалось, что ряд ошибок интонации в шёпотной речи были значительно менее ярко выражены.

Этот голос будет полезен при общении с Алисой ночью, чтобы не мешать близким. Можно задавать вопросы тихим голосом и Алиса будет отвечать шёпотом. Кроме того, такой стиль ещё и звучит очень приятно — поклонники ASMR оценят.