Что изучает data science а что big data

В чем разница между наукой о данных, анализом данных, большими данными, аналитикой, дата майнингом и машинным обучением

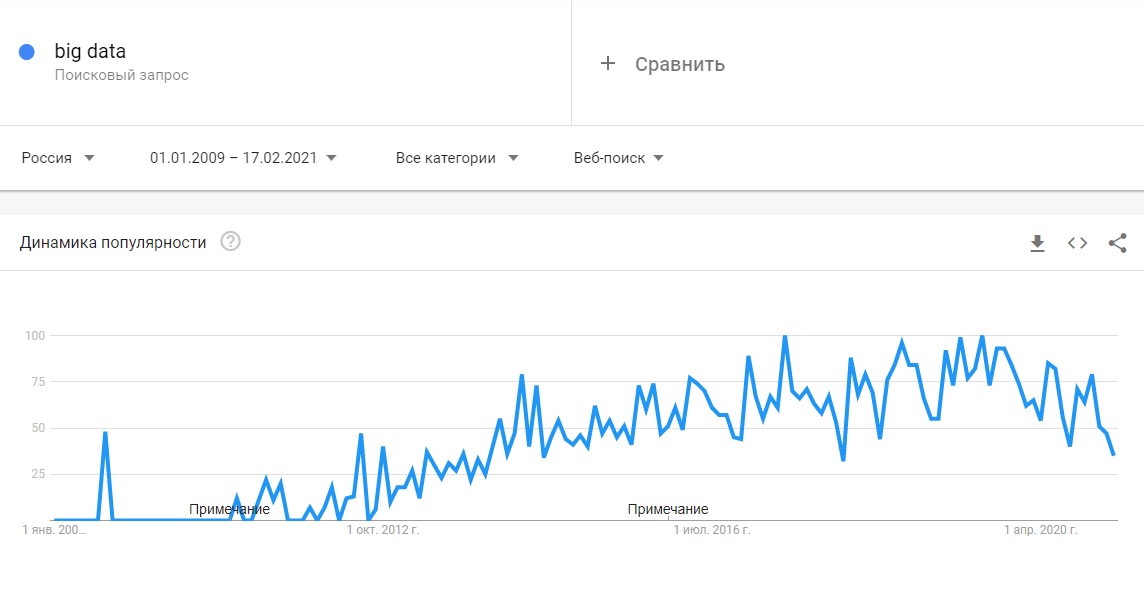

В последнее время слово big data звучит отовсюду и в некотором роде это понятие стало мейнстримом. С большими данными тесно связаны такие термины как наука о данных (data science), анализ данных (data analysis), аналитика данных (data analytics), сбор данных (data mining) и машинное обучение (machine learning).

Почему все стали так помешаны на больших данных и что значат все эти слова?

Почему все молятся на биг дату

Чем больше данных, тем сложнее с ними работать и анализировать. Математические модели, применимые к небольшим массивам данных скорее всего не сработают при анализе биг даты. Тем не менее в науке о данных большие данные занимают важное место. Чем больше массив, тем интересней будут результаты, извлеченные из глубоких недр большой кучи данных.

Преимущества больших данных:

Наука о данных

Наука о данных это глубокие познания о выводимых данных. Чтобы заниматься наукой о данных необходимо знать математику на высоком уровне, алгоритмические техники, бизнес-аналитику и даже психологию. Все это нужно чтобы перелопатить огромную кучу инфы и обнаружить полезный инсайт или интересные закономерности.

Наука о данных базируется вокруг строгих аналитических доказательств и работает со структурированными и не структурированными данными. В принципе все, что связано с отбором, подготовкой и анализом, лежит в пределах науки о данных.

Примеры применения науки о данных:

Аналитика

Аналитика — это наука об анализе, применении анализа данных для принятия решений.

Аналитика данных предназначена для внедрения инсайтов в массив данных и предполагает использование информационных запросов и процедур объединения данных. Она представляет различные зависимости между входными параметрами. Например, автоматически выявленные, не очевидные связи между покупками.

В науке о данных для построения прогнозируемой модели используются сырые данные. В аналитике зачастую данные уже подготовлены, а отчеты может интерпретировать практически любой юзер. Аналитику не нужны глубокие знания высшей математики, достаточно хорошо оперировать данными и строить удачные прогнозы.

Анализ данных

Анализ данных — это деятельность специалиста, которая направлена на получение информации о массиве данных. Аналитик может использовать различные инструменты для анализа, а может строить умозаключения и прогнозы полагаясь на накопленный опыт. Например, трейдер Forex может открывать и закрывать трейдерские позиции, основываясь на простых наблюдениях и интуиции.

Машинное обучение

Машинное обучение тесно связано с наукой о данных. Это техника искусственного обучения, которую применяют для сбора больших данных. По-простому это возможность обучить систему или алгоритм получать различные представления из массива.

При машинном обучении для построения модели прогнозирования целевых переменных используется некий первичный набор знаний. Машинное обучение применимо к различным типам сложных систем: от регрессионных моделей и метода опорных векторов до нейронных сетей. Здесь центром является компьютер, который обучается распознавать и прогнозировать.

Примеры алгоритмов:

Отбор данных

Сырые данные изначально беспорядочны и запутаны, собраны из различных источников и непроверенных записей. Не очищенные данные могут скрыть правду, зарытую глубоко в биг дате, и ввести в заблуждение аналитика.

Дата майнинг — это процесс очистки больших данных и подготовки их последующему анализу или использованию в алгоритмах машинного обучения. Дата майнеру нужно обладать исключительными распознавательными качествами, чудесной интуицией и техническими умениями для объединения и трансформирования огромного количества данных.

📊 Data Science и Big Data: сходства и различия

Если вы заинтересованы в работе с данными, важно иметь четкое представление о связанных с ней направлениях ИТ. В статье, подготовленной при поддержке Факультетов Искусственного интеллекта и Аналитики Big Data онлайн-университета GeekBrains, мы расскажем о сходстве и основных различиях между специализациями Data Science и Big Data.

Термины

Data Science – междисциплинарная область, которая охватывает практически все, что связано с данными: от их подготовки до очистки и анализа. Data Science использует научные методы и алгоритмы для работы как со структурированными, так и с неструктурированными данными. Эта область сочетает в себе статистику, математику, машинное обучение, решение проблем и многое другое.

В статье «Научиться Data Science онлайн» мы подробнее рассказали, чем занимаются специалисты Data Science и как овладеть профессией с нуля.

Big Data

Big Data – область, в которой рассматриваются различные способы анализа и систематического извлечения больших объемов данных. Big Data включает применение механических или алгоритмических процессов получения оперативной информации для решения сложных бизнес-задач. Специалисты по Big Data работают с сырыми неструктурированными данными, результаты анализа которых используются для поддержки принятия решений в бизнесе. Аналитика больших данных включает проверку, преобразование, очистку и моделирование данных.

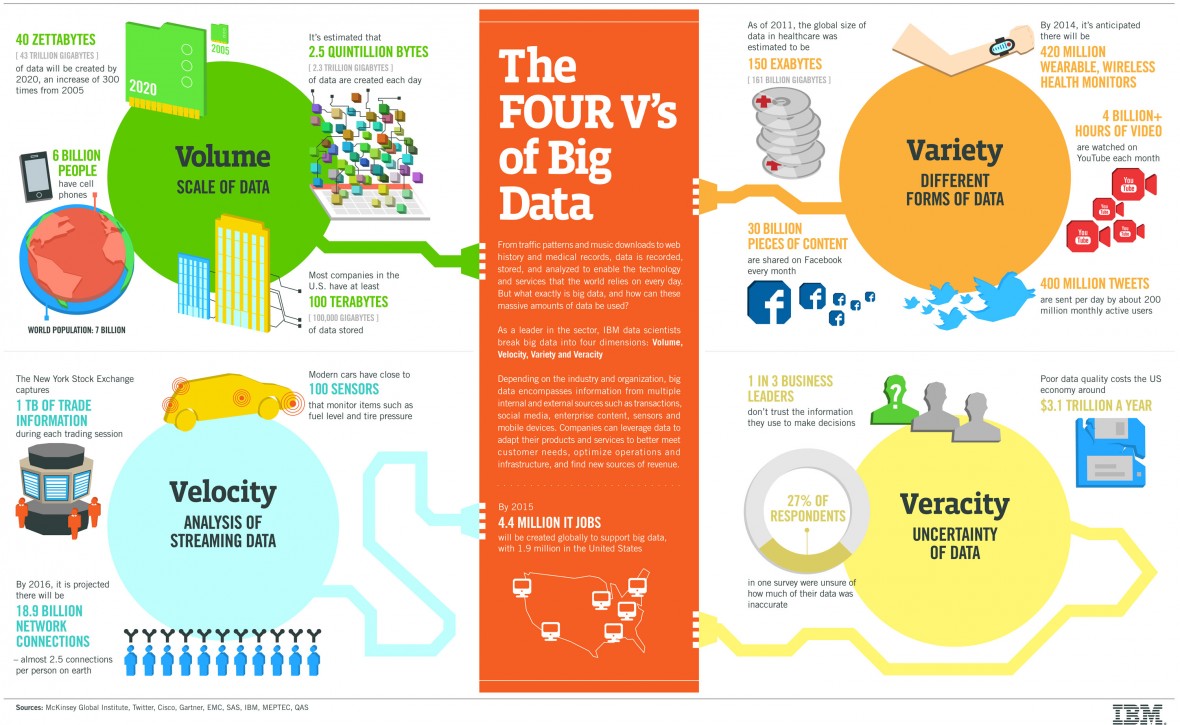

Работа с большими данными строится вокруг четырех правил (c англ. V’s of Big Data: Volume, Velocity, Variety, Veracity):

Применение

Data Science

Big Data

Аналитика больших данных применяется в самых разных областях. Перечислим некоторые из них:

Навыки

Data Science

Big Data

Специалист по анализу больших данных должен хорошо разбираться в таких языках программирования, как R и/или Python и SQL. Наряду с хорошими знаниями статистики и математики, ему потребуются навыки работы с инструментами, вроде Hadoop или Spark, для решения проблем, связанных с огромными объемами данных и их распределенной обработкой. Необходимо владеть навыками визуализации и преобразования данных, а также разбираться в машинном обучении.

Обязанности

Data Science

Учитывая огромное количество ежедневно обрабатываемых с помощью различных устройств по всему миру данных, организации заинтересованы в получении ценной информации из этого потока. Специалисты Data Science выполняют исследовательский анализ, а также используют различные виды алгоритмов машинного обучения для составления прогнозов определенных событий. Они сосредоточены на выявлении неизвестных корреляций, скрытых моделей и рыночных тенденций.

Big Data

В обязанности аналитиков больших данных входит работа с большим количеством разнородной информации, собранной из различных источников и поступающей с высокой скоростью. Специалисты по Big Data описывают поведение и структуру данных, а также то, как они могут быть представлены с помощью инструментов анализа: Spark, Hadoop и т. д.

Ключевые обязанности специалиста по Big Data включает понимание идей и тенденций, которые выявляются с помощью огромных наборов данных. После преобразования неструктурированной информации, бизнесу становится ясно, чего именно хотят клиенты, какие продукты продвигаются быстрее, каковы ожидания пользователей от обслуживания, как ускорить выход продукта на рынок и какие способы снижения затрат существуют. Большие данные явно приводят к большим временным выгодам для организаций, поэтому существует огромный спрос на специалистов в данной области.

Карьерные перспективы

В российском IT-секторе, есть тенденция к разделению специалистов по Data Science и Big Data при найме на работу. Однако по запросам Big Data в Яндекс.Работа и HeadHunter, можно заметить, что анализ больших данных включен в описание вакансий как Data Scientist, так и Big Data Engineer.

Заключение

Если вы хотите построить карьеру в Data Science или Big Data, лучше начать прямо сейчас. Эти области постоянно расширяются, генерируя новые вакансии. Для освоения необходимых навыков с нуля запишитесь на курсы факультетов Искусственного интеллекта и Аналитики Big Data онлайн-университета GeekBrains. Учебные программы построены на практической работе над проектами с ведущими специалистами отрасли и личным помощником-куратором.

Новая данность: что такое Data Science и зачем она нужна бизнесу

Что изучает Data Science

Каждый день человечество генерирует примерно 2,5 квинтиллиона байт различных данных. Они создаются буквально при каждом клике и пролистывании страницы, не говоря уже о просмотре видео и фотографий в онлайн-сервисах и соцсетях.

Наука о данных появилась задолго до того, как их объемы превысили все мыслимые прогнозы. Отсчет принято вести с 1966 года, когда в мире появился Комитет по данным для науки и техники — CODATA. Его создали в рамках Международного совета по науке, который ставил своей целью сбор, оценку, хранение и поиск важнейших данных для решения научных и технических задач. В составе комитета работают ученые, профессора крупных университетов и представители академий наук из нескольких стран, включая Россию.

Сам термин Data Science вошел в обиход в середине 1970-х с подачи датского ученого-информатика Петера Наура. Согласно его определению, эта дисциплина изучает жизненный цикл цифровых данных от появления до использования в других областях знаний. Однако со временем это определение стало более широким и гибким.

Data Science (DS) — междисциплинарная область на стыке статистики, математики, системного анализа и машинного обучения, которая охватывает все этапы работы с данными. Она предполагает исследование и анализ сверхбольших массивов информации и ориентирована в первую очередь на получение практических результатов.

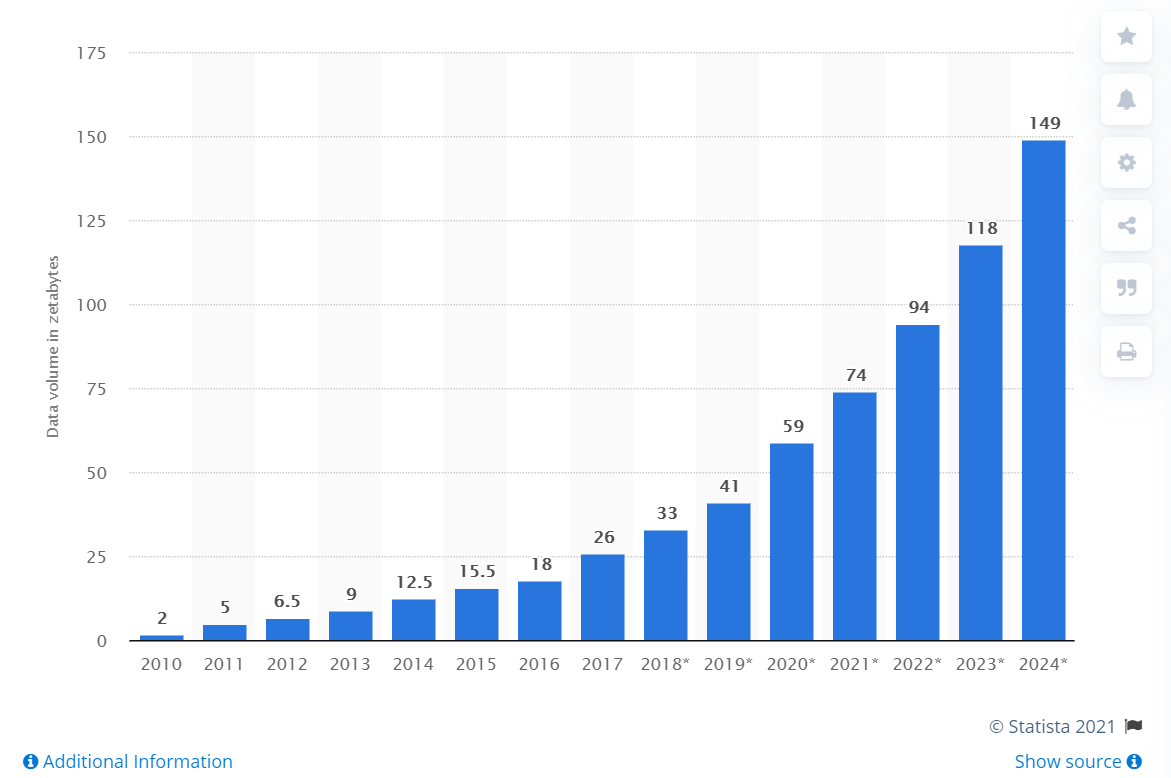

В 2010-х годах объемы данных стали расти по экспоненте. Свою роль сыграл целый ряд факторов — от повсеместного распространения мобильного интернета и популярности соцсетей до всеобщей оцифровки сервисов и процессов. В итоге профессия дата-сайентиста быстро превратилась в одну из самых популярных и востребованных. Еще в 2012 году позицию дата-сайентиста журналисты назвали самой привлекательной работой XXI века (The Sexiest Job of the XXI Century).

Развитие Data Science шло вместе с внедрением технологий Big Data и анализа данных. И хотя эти области часто пересекаются, их не следует путать между собой. Все они предполагают понимание больших массивов информации. Но если аналитика данных отвечает на вопросы о прошлом (например, об изменениях в поведениях клиентов какого-либо интернет-сервиса за последние несколько лет), то Data Science в буквальном смысле смотрит в будущее. Специалисты по DS на основе больших данных могут создавать модели, которые предсказывают, что случится завтра. В том числе и предсказывать спрос на те или иные товары и услуги.

Зачем Data Science бизнесу

Компании используют Data Science вне зависимости от размера бизнеса, показывает статистика Kaggle (профессиональная соцсеть специалистов по работе с данными). А по подсчетам IDC и Hitachi, 78% предприятий подтверждают, что количество анализируемой и используемой информации в последнее время значительно возросло. Бизнес понимает, что неструктурированная информация содержит очень важные для компании знания, способные повлиять на результаты бизнеса, отмечают авторы исследования.

Причем это касается самых разных сфер экономики. Вот лишь несколько примеров отраслей, которые используют Data Science для решения своих задач:

И это лишь самый краткий и поверхностный список использования Data Science. Количество различных кейсов с использованием «науки о данных» увеличивается с каждым годом в геометрической прогрессии.

Каждый интернет-пользователь и просто потребитель ежедневно десятки раз сталкивается с продуктами и решениями, в которых применяются инструменты Data Science. К примеру, аудио-сервис Spotify использует их, чтобы лучше подбирать треки для пользователей в соответствии с их предпочтениями. То же самое можно сказать о предложении фильмов и сериалах на видео-стримингах, таких как Netflix. А в Uber науку о данных рассматривают как инструмент для предиктивной аналитики, прогнозирования спроса, улучшения и автоматизации всех продуктов и клиентского опыта.

Конечно, дата-сайентисты не могут в точности предсказать будущее компании и учесть абсолютно все возможные риски. «Все модели неправильные, но некоторые из них полезны», — иронизировал по этому поводу британский статистик Джордж Бокс. Тем не менее, инструменты Data Science служат хорошей поддержкой для компаний, которые хотят принимать более информированные и обоснованные решения о своем будущем.

Как работают дата-сайентисты

Для работы с данными дата-сайентисты применяют целый комплекс инструментов — пакеты статистического моделирования, различные базы данных, специальное программное обеспечение. Но, главное, они используют технологии искусственного интеллекта и создают модели машинного обучения (нейросети), которые помогают бизнесу анализировать информацию, делать выводы и прогнозировать будущее.

Каждую такую нейросеть необходимо спланировать, построить, оценить, развернуть и только потом перейти к ее обучению. «Сейчас, по нашим оценкам, в процессе работы над ИИ-решениями только 30% времени специалистов уходит на обучение моделей. Все остальное — на подготовку к нему и другую рутину», — говорит CTO «Сбербанк Груп», исполнительный вице-президент и глава блока «Технологии» Давид Рафаловский.

Компания Anaconda, которая разрабатывает продукты для работы с данными, приводит еще более печальную статистику. Ее опросы показывают, что в среднем почти половину времени (45%) специалисты тратят на подготовку данных, то есть их загрузку и очистку. Еще примерно треть уходит на визуализацию данных и выбор модели. На обучение и развертывание остается всего 12% и 11% рабочего времени соответственно.

Дата-сайентисты в облаках

Облегчить и ускорить работу по сбору данных, построению и развертыванию моделей помогают специальные облачные платформы. Именно облачные платформы для машинного обучения стали самым актуальным трендом в Data Science. Поскольку речь идет о больших объемах информации, сложных ML-моделях, о готовых и доступных для работы распределенных команд инструментах, то дата-сайентистами понадобились гибкие, масштабируемые и доступные ресурсы.

Именно для дата-сайентистов облачные провайдеры создали платформы, ориентированные на подготовку и запуск моделей машинного обучения и дальнейшую работу с ними. Пока таких решений немного и одно из них было полностью создано в России. В конце 2020 года компания Sbercloud представила облачную платформу полного цикла разработки и реализации AI-сервисов — ML Space. Платформа содержит набор инструментов и ресурсов для создания, обучения и развертывания моделей машинного обучения — от быстрого подключения к источникам данных до автоматического развертывания обученных моделей на динамически масштабируемых облачных ресурсах SberCloud.

Сейчас ML Space — единственный в мире облачный сервис, позволяющий организовать распределенное обучение на 1000+ GPU. Эту возможность обеспечивает собственный облачный суперкомпьютер SberCloud — «Кристофари». Запущенный в 2019 году «Кристофари» является сейчас самым мощным российским вычислительным кластером и занимает 40 место в мировом рейтинге cуперкомпьютеров TOP500

Платформу уже используют команды разработчиков экосистемы Сбера. Именно с ее помощью было запущено семейство виртуальных ассистентов «Салют». Для их создания с помощью «Кристофари» и ML Space было обучено более 70 различных ASR- моделей (автоматическое распознавание речи) и большое количество моделей Text-to-Speech. Сейчас ML Space доступна для любых коммерческих пользователи, учебных и научных организаций.

«ML Space – это настоящий технологический прорыв в области работы с искусственным интеллектом. По нескольким ключевым параметрам ML Space уже превосходит лучшие мировые решения. Я считаю, что сегодня ML Space одна из лучших в мире облачных платформ для машинного обучения. Опытным дата-сайентистам она предоставляет новые удобные инструменты, возможность распределенной работы, автоматизации создания, обучения и внедрения ИИ-моделей. Компаниям и организациям, не имеющим глубокой ML-экспертизы, ML Space дает возможность впервые использовать искусственный интеллект в своих продуктах, приложениях и рабочих процессах», — уверен Отари Меликишвили, лидер продуктового вправления AI Cloud, компании SberCloud.

Облака помогают рынку все шире использовать платформы для работы с данными, предлагая безграничные вычислительные мощности, подтверждают аналитики Mordor Intelligence.

По мнению экспертов из Anaconda, потребуется время, чтобы бизнес и сами специалисты созрели для широкого использования инструментов DS и смогли получить результаты. Но прогресс уже очевиден. «Мы ожидаем, что в ближайшие два-три года Data Science продолжит двигаться к тому, чтобы стать стратегической функцией бизнеса во многих отраслях», — прогнозирует компания.

Что такое Big Data и почему их называют «новой нефтью»

Что такое Big Data?

Big Data или большие данные — это структурированные или неструктурированные массивы данных большого объема. Их обрабатывают при помощи специальных автоматизированных инструментов, чтобы использовать для статистики, анализа, прогнозов и принятия решений.

Сам термин «большие данные» предложил редактор журнала Nature Клиффорд Линч в спецвыпуске 2008 года [1]. Он говорил о взрывном росте объемов информации в мире. К большим данным Линч отнес любые массивы неоднородных данных более 150 Гб в сутки, однако единого критерия до сих пор не существует.

До 2011 года анализом больших данных занимались только в рамках научных и статистических исследований. Но к началу 2012-го объемы данных выросли до огромных масштабов, и возникла потребность в их систематизации и практическом применении.

С 2014 на Big Data обратили внимание ведущие мировые вузы, где обучают прикладным инженерным и ИТ-специальностям. Затем к сбору и анализу подключились ИТ-корпорации — такие, как Microsoft, IBM, Oracle, EMC, а затем и Google, Apple, Facebook и Amazon. Сегодня большие данные используют крупные компании во всех отраслях, а также — госорганы. Подробнее об этом — в материале «Кто и зачем собирает большие данные?»

Какие есть характеристики Big Data?

Компания Meta Group предложила основные характеристики больших данных [2]:

Сегодня к этим трем добавляют еще три признака [3]:

Как работает Big Data: как собирают и хранят большие данные?

Большие данные необходимы, чтобы проанализировать все значимые факторы и принять правильное решение. С помощью Big Data строят модели-симуляции, чтобы протестировать то или иное решение, идею, продукт.

Главные источники больших данных:

С 2007 года в распоряжении ФБР и ЦРУ появилась PRISM — один из самых продвинутых сервисов, который собирает персональные данные обо всех пользователях соцсетей, а также сервисов Microsoft, Google, Apple, Yahoo и даже записи телефонных разговоров.

Современные вычислительные системы обеспечивают мгновенный доступ к массивам больших данных. Для их хранения используют специальные дата-центры с самыми мощными серверами.

Помимо традиционных, физических серверов используют облачные хранилища, «озера данных» (data lake — хранилища большого объема неструктурированных данных из одного источника) и Hadoop — фреймворк, состоящий из набора утилит для разработки и выполнения программ распределенных вычислений. Для работы с Big Data применяют передовые методы интеграции и управления, а также подготовки данных для аналитики.

Big Data Analytics — как анализируют большие данные?

Благодаря высокопроизводительным технологиям — таким, как грид-вычисления или аналитика в оперативной памяти, компании могут использовать любые объемы больших данных для анализа. Иногда Big Data сначала структурируют, отбирая только те, что нужны для анализа. Все чаще большие данные применяют для задач в рамках расширенной аналитики, включая искусственный интеллект.

Выделяют четыре основных метода анализа Big Data [4]:

1. Описательная аналитика (descriptive analytics) — самая распространенная. Она отвечает на вопрос «Что произошло?», анализирует данные, поступающие в реальном времени, и исторические данные. Главная цель — выяснить причины и закономерности успехов или неудач в той или иной сфере, чтобы использовать эти данные для наиболее эффективных моделей. Для описательной аналитики используют базовые математические функции. Типичный пример — социологические исследования или данные веб-статистики, которые компания получает через Google Analytics.

«Есть два больших класса моделей для принятия решений по ценообразованию. Первый отталкивается от рыночных цен на тот или иной товар. Данные о ценниках в других магазинах собираются, анализируются и на их основе по определенным правилам устанавливаются собственные цены.

Второй класс моделей связан с выстраиванием кривой спроса, которая отражает объемы продаж в зависимости от цены. Это более аналитическая история. В онлайне такой механизм применяется очень широко, и мы переносим эту технологию из онлайна в офлайн».

2. Прогнозная или предикативная аналитика (predictive analytics) — помогает спрогнозировать наиболее вероятное развитие событий на основе имеющихся данных. Для этого используют готовые шаблоны на основе каких-либо объектов или явлений с аналогичным набором характеристик. С помощью предикативной (или предиктивной, прогнозной) аналитики можно, например, просчитать обвал или изменение цен на фондовом рынке. Или оценить возможности потенциального заемщика по выплате кредита.

3. Предписательная аналитика (prescriptive analytics) — следующий уровень по сравнению с прогнозной. С помощью Big Data и современных технологий можно выявить проблемные точки в бизнесе или любой другой деятельности и рассчитать, при каком сценарии их можно избежать их в будущем.

4. Диагностическая аналитика (diagnostic analytics) — использует данные, чтобы проанализировать причины произошедшего. Это помогает выявлять аномалии и случайные связи между событиями и действиями.

Например, Amazon анализирует данные о продажах и валовой прибыли для различных продуктов, чтобы выяснить, почему они принесли меньше дохода, чем ожидалось.

Данные обрабатывают и анализируют с помощью различных инструментов и технологий [6] [7]:

Как отметил в подкасте РБК Трендов менеджер по развитию IoT «Яндекс.Облака» Александр Сурков, разработчики придерживаются двух критериев сбора информации:

Чтобы обрабатывать большие массивы данных в режиме онлайн используют суперкомпьютеры: их мощность и вычислительные возможности многократно превосходят обычные. Подробнее — в материале «Как устроены суперкомпьютеры и что они умеют».

Big Data и Data Science — в чем разница?

Data Science или наука о данных — это сфера деятельности, которая подразумевает сбор, обработку и анализ данных, — структурированных и неструктурированных, не только больших. В ней используют методы математического и статистического анализа, а также программные решения. Data Science работает, в том числе, и с Big Data, но ее главная цель — найти в данных что-то ценное, чтобы использовать это для конкретных задач.

В каких отраслях уже используют Big Data?

Павел Иванченко, руководитель по IoT «МегаФона»:

«IoT-решение из области так называемого точного земледелия — это когда специальные метеостанции, которые стоят в полях, с помощью сенсоров собирают данные (температура, влажность) и с помощью передающих радио-GSM-модулей отправляют их на IoT-платформу. На ней посредством алгоритмов big data происходит обработка собранной с сенсоров информации и строится высокоточный почасовой прогноз погоды. Клиент видит его в интерфейсе на компьютере, планшете или смартфоне и может оперативно принимать решения».

Big Data в России и мире

По данным компании IBS [8], в 2012 году объем хранящихся в мире цифровых данных вырос на 50%: с 1,8 до 2,7 Збайт (2,7 трлн Гбайт). В 2015-м в мире каждые десять минут генерировалось столько же данных, сколько за весь 2003 год.

По данным компании NetApp, к 2003 году в мире накопилось 5 Эбайтов данных (1 Эбайт = 1 млрд Гбайт). В 2015-м — более 6,5 Збайта, причем тогда большие данные использовали лишь 17% компаний по всему миру [9]. Большую часть данных будут генерировать сами компании, а не их клиенты. При этом обычный пользователь будет коммуницировать с различными устройствами, которые генерируют данные, около 4 800 раз в день.

Сейчас в США с большими данными работает более 55% компаний [11], в Европе и Азии — около 53%. Только за последние пять лет распространение Big Data в бизнесе выросло в три раза.

В Китае действует более 200 законов и правил, касающихся защиты личной информации. С 2019 года все популярные приложения для смартфонов начали проверять и блокировать, если они собирают данные о пользователях вопреки законам. В итоге данные через местные сервисы собирает государство, и многие из них недоступны извне.

С 2018 года в Евросоюзе действует GDPR — Всеобщий регламент по защите данных. Он регулирует все, что касается сбора, хранения и использования данных онлайн-пользователей. Когда закон вступил в силу год назад, он считался самой жесткой в мире системой защиты конфиденциальности людей в Интернете.

В России рынок больших данных только зарождается. К примеру, сотовые операторы делятся с банками информацией о потенциальных заемщиках [12]. Среди корпораций, которые собирают и анализируют данные — «Яндекс», «Сбер», Mail.ru. Появились специальные инструменты, которые помогают бизнесу собирать и анализировать Big Data — такие, как российский сервис Ctrl2GO.

Big Data в бизнесе

Большие данные полезны для бизнеса в трех главных направлениях:

Крупные компании — такие, как Netflix, Procter & Gamble или Coca-Cola — с помощью больших данных прогнозируют потребительский спрос. 70% решений в бизнесе и госуправлении принимается на основе геоданных. Подробнее — в материале о том, как бизнес извлекает прибыль из Big Data.

Каковы проблемы и перспективы Big Data?

Главные проблемы:

Плюсы и перспективы:

В ближайшем будущем большие данные станут главным инструментом для принятия решений — начиная с сетевых бизнесов и заканчивая целыми государствами и международными организациями [15].