Чем определяется объем знаний человека получающего сообщение

Чем определяется объем знаний человека получающего сообщение

В содержательном подходе количество информации, заключенное в сообщении, определяется объемом знаний, который это сообщение несет получающему его человеку.

Процесс познания можно изобразить в виде расширяющегося “круга знания“, всё что за пределами круга – область незнания.

Чем больше знаешь, тем больше понимаешь, что ничего не знаешь…

Другими словами, по мере получения знаний, человек раздвигает границы познания, но при этом всё больше осознает объёмы своего незнания.

Например, знания выпускника школы гораздо больше чем знания первоклассника, но и граница его незнания также существенно больше, т.е. старшеклассник при подготовке к выпускным экзаменам обнаруживает непонимание некоторых законов или правил и вынужден их восполнять. Тогда как первоклассник вообще ничего не знает об этих законах и правилах.

Подход к измерению информации, как способу уменьшения неопределённости знания, позволяет измерять информацию, особенно это ВАЖНО для информатики, которая изучает процессы хранения и передачи информации.

Информацию можно рассматривать как набор сообщений.

Сообщение – это форма представления каких-либо сведений в виде речи, текста, изображений, графиков, таблиц и т.д.

Информация – это знания, которые мы получаем из внешнего мира. Количество информации, заключенное в сообщении, должно быть тем больше, чем больше оно пополняет наши знания.

1 бит – минимальная единица измерения количества информации.

Сообщение, уменьшающее неопределенность знания в два раза, несет 1 бит информации.

Допустим, вы бросаете, загадывая, что выпадет: орел или решка.

Есть всего два возможных результата бросания монеты. Причем ни один из этих результатов не имеет преимущества перед другим. В таком случае говорят, что они равновероятны.

В случае с монетой перед ее подбрасыванием неопределенность знания о результате равна двум.

Игральный кубик с шестью гранями может с равной вероятностью упасть на любую из них. Значит, неопределенность знания о результате бросания кубика равна шести.

Неопределенность знания о результате некоторого события (бросание монеты или игрального кубика, жребий и др.) – это количество возможных результатов.

Пусть в некотором сообщении содержатся сведения о том, что произошло одно из N равновероятных событий.

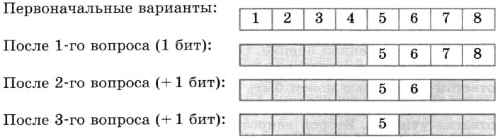

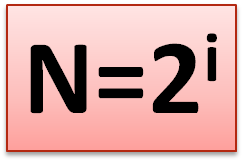

Тогда количество информации i, содержащееся в сообщении о том, что произошло одно из N равновероятных событий, можно определить из формулы Хартли:

Шахматная доска состоит из 64 полей: 8 столбцов на 8 строк.

Какое количество бит несет сообщение о выборе одного шахматного поля?

Поскольку выбор любой из 64 клеток равновероятен, то количество бит находится из формулы:

Чем определяется объем знаний человека получающего сообщение

Урок 6. Содержательный (вероятностный) подход к измерению информации

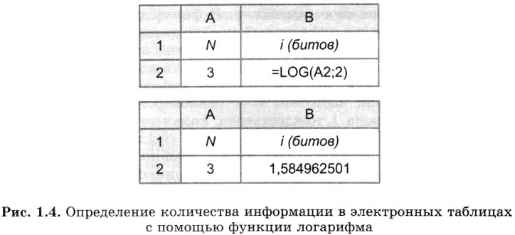

Измерение информации. Содержательный подход

|  | ||

|  | ||

|

| Рис. 1.4. Управление роботом с использованием информационных сообщений |

Всего возможных информационных сообщений 8, поэтому формула (1.1) принимает вид уравнения относительно I:

Разложим стоящее в левой части уравнения число 8 на сомножители и представим его в степенной форме:

Равенство левой и правой частей уравнения справедливо, если равны показатели степени числа 2. Таким образом, I = 3 бита, т. е. количество информации, которое несет роботу каждое информационное сообщение, равно 3 битам.

Алфавитный подход к определению количества информации

При алфавитном подходе к определению количества информации отвлекаются от содержания информации и рассматривают информационное сообщение как последовательность знаков определенной знаковой системы.

|

| Рис. 1.5. Передача информации |

Формула (1.1) связывает между собой количество возможных информационных сообщений N и количество информации I, которое несет полученное сообщение. Тогда в рассматриваемой ситуации N – это количество знаков в алфавите знаковой системы, а I – количество информации, которое несет каждый знак:

С помощью этой формулы можно, например, определить количество информации, которое несет знак в двоичной знаковой системе:

Таким образом, в двоичной знаковой системе знак несет 1 бит информации. Интересно, что сама единица измерения количества информации «бит» (bit) получила свое название ОТ английского словосочетания «Binary digiT» – «двоичная цифра».

Информационная емкость знака двоичной знаковой системы составляет 1 бит.

Чем большее количество знаков содержит алфавит знаковой системы, тем большее количество информации несет один знак. В качестве примера определим количество информации, которое несет буква русского алфавита. В русский алфавит входят 33 буквы, однако на практике часто для передачи сообщений используются только 32 буквы (исключается буква «ё»).

С помощью формулы (1.1) определим количество информации, которое несет буква русского алфавита:

Таким образом, буква русского алфавита несет 5 битов информации (при алфавитном подходе к измерению количества информации).

Количество информации, которое несет знак, зависит от вероятности его получения. Если получатель заранее точно знает, какой знак придет, то полученное количество информации будет равно 0. Наоборот, чем менее вероятно получение знака, тем больше его информационная емкость.

В русской письменной речи частота использования букв в тексте различна, так в среднем на 1000 знаков осмысленного текста приходится 200 букв «а» и в сто раз меньшее количество буквы «ф» (всего 2). Таким образом, с точки зрения теории информации, информационная емкость знаков русского алфавита различна (у буквы «а» она наименьшая, а у буквы «ф» – наибольшая).

Количество информации в сообщении. Сообщение состоит из последовательности знаков, каждый из которых несет определенное количество информации.

Если знаки несут одинаковое количество информации, то количество информации Ic в сообщении можно подсчитать, умножив количество информации Iз, которое несет один знак, на длину кода (количество знаков в сообщении) К:

Так, каждая цифра двоичного компьютерного кода несет информацию в 1 бит. Следовательно, две цифры несут информацию в 2 бита, три цифры – в 3 бита и т. д. Количество информации в битах равно количеству цифр двоичного компьютерного кода (табл. 1.1).

Все мы привыкли к тому, что все вокруг можно измерить. Мы можем определить массу посылки, длину стола, скорость движения автомобиля. Но как определить количество информации, содержащееся в сообщении? Ответ на вопрос в статье.

Итак, давайте для начала выберем сообщение. Пусть это будет «Принтер — устройство вывода информации.«. Наша задача — определить, сколько информации содержится в данном сообщении. Иными словами — сколько памяти потребуется для его хранения.

Определение количества информации в сообщении

Для решения задачи нам нужно определить, сколько информации несет один символ сообщения, а потом умножить это значение на количество символов. И если количество символов мы можем посчитать, то вес символа нужно вычислить. Для этого посчитаем количество различных символов в сообщении. Напомню, что знаки препинания, пробел — это тоже символы. Кроме того, если в сообщении встречается одна и та же строчная и прописная буква — мы считаем их как два различных символа. Приступим.

В слове Принтер 6 различных символов (р встречается дважды и считается один раз), далее 7-й символ пробел и девятый — тире. Так как пробел уже был, то после тире мы его не считаем. В слове устройство 10 символов, но различных — 7, так как буквы с, т и о повторяются. Кроме того буквы т и р уже была в слове Принтер. Так что получается, что в слове устройство 5 различных символов. Считая таким образом дальше мы получим, что в сообщении 20 различных символов.

Далее вспомним формулу, которую называют главной формулой информатики:

Подставив в нее вместо N количество различных символов, мы узнаем, сколько информации несет один символ в битах. В нашем случае формула будет выглядеть так:

Вспомним степени двойки и поймем, что i находится в диапазоне от 4 до 5 (так как 2 4 =16, а 2 5 =32). А так как бит — минимальная единица измерения информации и дробным быть не может, то мы округляем i в большую сторону до 5. Иначе, если принять, что i=4, мы смогли бы закодировать только 2 4 =16 символов, а у нас их 20. Поэтому получаем, что i=5, то есть каждый символ в нашем сообщении несет 5 бит информации.

Осталось посчитать сколько символов в нашем сообщении. Но теперь мы будем считать все символы, не важно повторяются они или нет. Получим, что сообщение состоит из 39 символов. А так как каждый символ — это 5 бит информации, то, умножив 5 на 39 мы получим:

5 бит x 39 символов = 195 бит

Это и есть ответ на вопрос задачи — в сообщении 195 бит информации. И, подводя итог, можно написать алгоритм нахождения объема информации в сообщении:

Объемный способ измерения информации

Технический способ измерения количества информации (или, точнее, информационного объема сообщения) основан на подсчета количества символов, из которых образовано сообщение. При этом не учитывается смысловое содержание сообщения. Например, многократное повторение одного и того же текста не несет новой информации, однако в результате занимает больший объем памяти, требует большего времени для передачи и т.п. Поэтому этот способ удобен в технических расчетах.

Американский математик и инженер К. Шеннон в 1948 г. получил формулу для расчета количества информации, содержащейся в системе, обладающей произвольным набором неравновероятных (в общем случае) состояний

где n – число возможных состояний системы, pi – вероятность i-го состояния (причем pi = 1)

Чем меньше вероятность наступления события, тем большую информацию это событие несет.

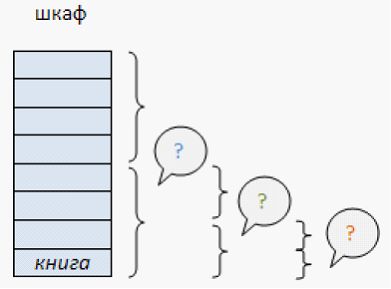

На книжном стеллаже восемь полок. Книга может быть поставлена на любую из них. Сколько информации содержит сообщение о том, где находится книга?

Применим метод половинного деления. Зададим несколько вопросов уменьшающих неопределенность знаний в два раза.

– Книга лежит выше четвертой полки?

Книга — на второй полке?

Ну теперь все ясно! Книга лежит на первой полке! Каждый ответ уменьшал неопределенность в два раза.

Всего было задано три вопроса. Значит набрано 3 бита информации. И если бы сразу было сказано, что книга лежит на первой полке, то этим сообщением были бы переданы те же 3 бита информации.

Если обозначить возможное количество событий, или, другими словами, неопределенность знаний N, а буквой I количество информации в сообщении о том, что произошло одно из N событий, то можно записать формулу:

Количество информации, содержащееся в сообщении о том, что произошло одно из N равновероятных событий, определяется из решения показательного уравнения:

А теперь познакомимся с другим способом измерения информации. Этот способ не связывает количество информации с содержанием сообщения, и называется он алфавитным подходом.

При алфавитном подходе к определению количества информации отвлекаются от содержания информации и рассматривают информационное сообщение как последовательность знаков определенной знаковой системы.

Все множество используемых в языке символов будем традиционно называть алфавитом. Обычно под алфавитом понимают только буквы, но поскольку в тексте могут встречаться знаки препинания, цифры, скобки, то мы их тоже включим в алфавит. В алфавит также следует включить и пробел, т.е. пропуск между словами.

Полное количество символов алфавита принято называть мощностью алфавита. Будем обозначать эту величину буквой N. Например, мощность алфавита из русских букв и отмеченных дополнительных символов равна 54.

В каждой очередной позиции текста может появиться любой из N символов. Тогда, согласно известной нам формуле, каждый такой символ несет I бит информации, которое можно определить из решения уравнения: 2I = 54. Получаем: I = 5.755 бит.

Вот сколько информации несет один символ в русском тексте! А теперь для того, чтобы найти количество информации во всем тексте, нужно посчитать число символов в нем и умножить на I.

Посчитаем количество информации на одной странице книги. Пусть страница содержит 50 строк. В каждой строке — 60 символов. Значит, на странице умещается 50×60=3000 знаков. Тогда объем информации будет равен: 5,755 х 3000 = 17265 бит.

При алфавитном подходе к измерению информации количество информации зависит не от содержания, а от размера текста и мощности алфавита.

Пусть небольшая книжка, сделанная с помощью компьютера, содержит 150 страниц; на каждой странице — 40 строк, в каждой строке — 60 символов. Значит страница содержит 40×60=2400 байт информации. Объем всей информации в книге: 2400 х 150 = 360 000 байт.

В любой системе единиц измерения существуют основные единицы и производные от них.

Для измерения больших объемов информации используются следующие производные от байта единицы:

1 килобайт = 1Кб = 210 байт = 1024 байта.

1 мегабайт = 1Мб = 210 Кб = 1024 Кб.

1 гигабайт = 1Гб = 210 Мб = 1024 Мб.

Прием-передача информации могут происходить с разной скоростью. Количество информации, передаваемое за единицу времени, есть скорость передачи информации или скорость информационного потока.

Очевидно, эта скорость выражается в таких единицах, как бит в секунду (бит/с), байт в секунду (байт/с), килобайт в секунду (Кбайт/с) и т.д.

Вопросы для самопроверки

Вопросы для самопроверки

1. Формальная и неформальная постановка задачи.

2. Дайте определение «модель» и требования к моделированию.

3. Характеристика стадий построения информационной модели.

4. Классификация моделей.

5. Виды форм представления информационных моделей.

6. Этапы разработки компьютерных моделей.

7. Информация, классификация информации.

8. Методы получения и использования информации.

9. Носитель информации.

10. Способы измерения информации.

11. Алфавитный подход к измерения информации.

Не нашли то, что искали? Воспользуйтесь поиском:

Лучшие изречения: Только сон приблежает студента к концу лекции. А чужой храп его отдаляет. 8956 –

91.146.8.87 © studopedia.ru Не является автором материалов, которые размещены. Но предоставляет возможность бесплатного использования. Есть нарушение авторского права? Напишите нам | Обратная связь.

Отключите adBlock!

и обновите страницу (F5)

очень нужно

- Чем определяется объем знаний для проверки по каждой должности

- Чем определяется объем и номенклатура профессиональных услуг по профилактике гнвп и оф

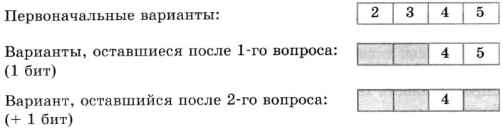

Неопределенность знания — это количество возможных вариантов ответа на интересовавший вас вопрос. Еще можно сказать: возможных исходов события. Здесь событие — например, выборы мэра; исход — выбор, например, Н. Н. Никитина.

Неопределенность знания — это количество возможных вариантов ответа на интересовавший вас вопрос. Еще можно сказать: возможных исходов события. Здесь событие — например, выборы мэра; исход — выбор, например, Н. Н. Никитина.

Сообщение, уменьшающее неопределенность знания об исходе некоторого события в два раза, несет 1 бит информации.

Сообщение, уменьшающее неопределенность знания об исходе некоторого события в два раза, несет 1 бит информации.